Información de la materia

Docentes:

- Mariano Benitez

- Rodolfo Sumoza

- Tomás Najún

- Rodrigo Pazos

- David Túa

Hay parte práctica y parte teórica. La idea es llevar la práctica al día (?).

¿De qué vamos a hablar?

Programas interconectados en la red

Para qué se comunican? Es necesario?

- Por disponibilidad

- Por escalabilidad

- Si un programa se vuelve muy pesado y consume muchos recursos, va a ser necesario volverlo distribuido.

- Por ubicación geográfica

¿Para qué armar una red?

Si es más fácil hacer todo en la misma compu, ¿para qué me voy a gastar en hacer una red?

Esencialmente, por 2 motivos:

-

Por diseño/definición es distribuido

- Red de bancos

- Sensores / elementos de IoT

- Aplicaciones móviles Básicamente, cuando el problema es inherentemente distribuido, no hay chance de juntarlo. Este motivo se llamará "Descentralizado", el cual es necesario.

-

Porque no alcanza una sola computadora

- No me alcanza la memoria, CPU, etc.

- No se puede apagar nunca

- Tiene que ser muy rápido Básicamente, cuando tengo requerimientos que me obligan a usar más de una computadora. A esto le vamos a decir "Distribuido", el cual es un motivo suficiente.

¡Los sistemas distribuidos son complejos!

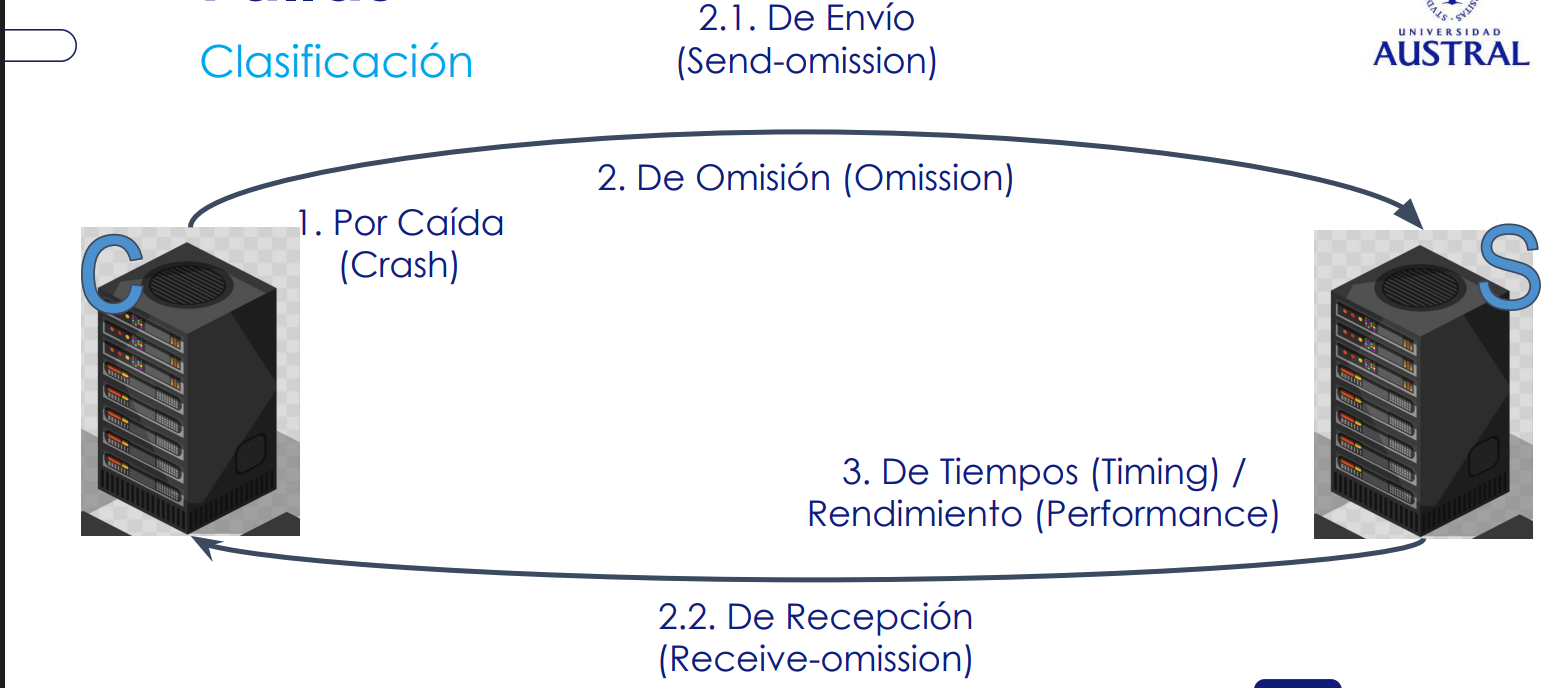

Cuando hay más cosas que se pueden romper, se agrega muchísima complejidad. Uno tiene que estar preparado para que las cosas se rompan.

Justamente, en un sistema distribuido es mucho más complejo porque tiene muchos componentes.

Te pueden pasar mil cosas

- Se rompe la computadora

- No se sabe con quién se tiene que comunicar

- No se ponen de acuerdo

- Se corta la comunicación

- Se pierden los bits

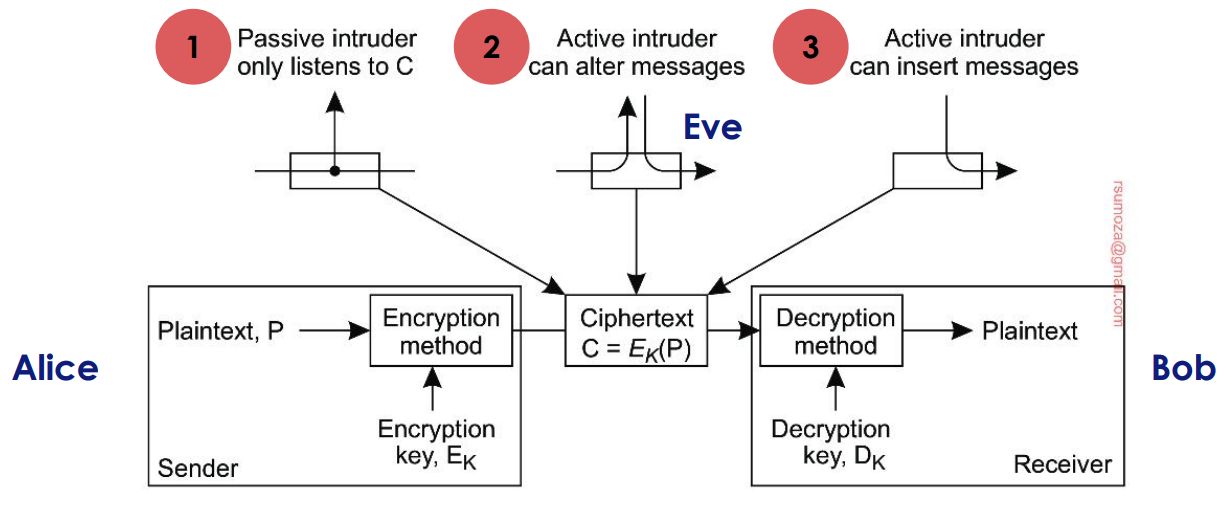

- Pueden venir intrusos

- Atacantes, por ejemplo

- Obvio, hay bugs en el código Entre otras cosas...

Si no se controlan estas cosas: ¿La gente podría confiar en el sistema? Si no se confía en el sistema, no sirve para nada.

El principal desafío de los sistemas distribuidos es hacerlos confiables.

Cómo sabemos todo esto?

- Del libro de Tanenbaum.

- Es un bodrio de leer, en la materia se tratan de bajar las ideas principales del mismo.

¿Qué pasa en un sistema distribuido?

- Hay procesos.

- Que se comunican.

- Que se coordinan entre sí.

- Que necesitan encontrarse.

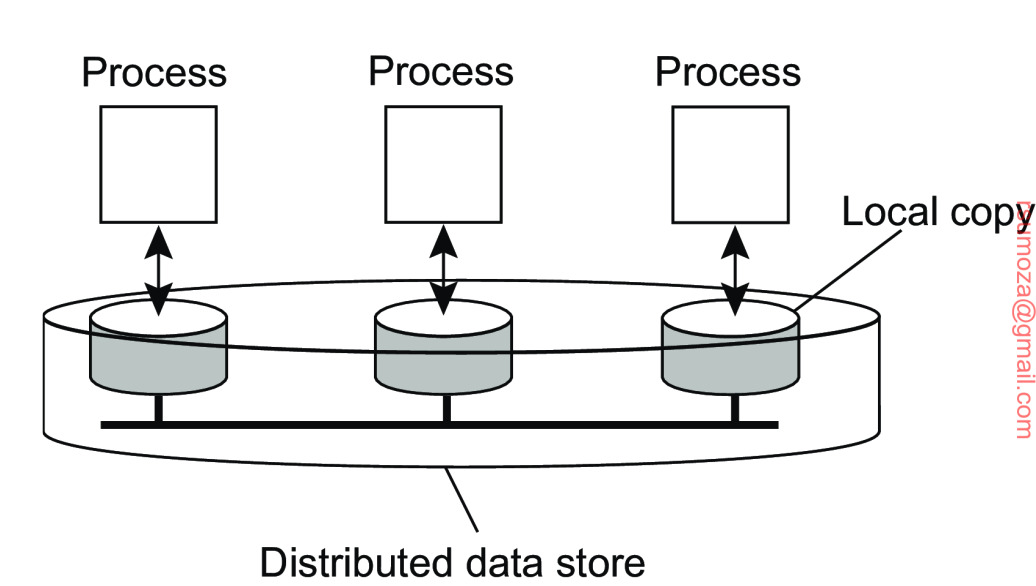

- Que comparten información.

- Que se prenden, apagan y rompen.

- Que se defienden ante amenazas.

Enfoque de la materia

La realidad:

- Son una banda de temas y muy complejos y amplios

- Se puede ir en mucho detalle en cada punto (profundidad)

- Los problemas y las soluciones cambian todo el tiempo

- Pero las bases siguen siendo las mismas

- Se usa en el trabajo de todo ingeniero de software

Entonces como ingenieros, ¿qué es lo importante?

- Tener un conocimiento de las bases que forman un sistema distribuido

- Analizar un sistema y reconocer sus capacidades y limitaciones

- Proponer soluciones en forma objetiva y clara

Un buen diseño de un sistema distribuido (qué pasa cuando se rompe, cómo encaro temas de escalabilidad, etc.) logra que no tengas que hacer cambios de arquitectura grandes en caso de la necesidad de un cambio.

¿Qué se llevan al final de la materia?

- Conocimientos de los aspectos de los sistemas distribuidos

- Entendimiento de las características y el impacto de cada aspecto

- Habilidades básicas para analizar y evaluar problemas y soluciones

¿Qué no se llevan?

- Conocimiento profundo de alguna solución (ej: Kubernetes)

¿Qué capacidades necesitan traer?

- Analizar información y situaciones complejas

- Presentar alternativas de forma objetiva

- Tener pensamiento crítico, en resumen.

Teoría (70% de la cursada)

- Foco en los conceptos

- Problemas y características

- Bajada a tierra del libro

Práctica (30% de la cursada)

- Foco en las habilidades

- Analizar situaciones

- Presentación de propuestas

De parte de que aprenden

- Lean los capítulos después de la clase

- Consultas en la siguiente

Evaluaciones

2 parciales, 11 de septiembre y 30 de octubre Recus: 6 y 11 de noviembre

2 TPs

- Entrega TP1: 18 de septiembre

- Entrega TP2: 6 de noviembre

Introducción

Objetivos funcionales

¿Vale la pena construir un sistema distribuido? ¿Para qué hago un sistema distribuido? Porque tengo que compartir información

Objetivos que merecen crear un sistema distribuido

-

Los principales:

- Ofrecer recursos/procesos a otros

- Transparencia en la distribución de procesos y recursos

- Interoperabilidad

- Confiabilidad

-

Otros aspectos influyentes

- Seguridad

- Escalabilidad

Por compartir recursos

Brindar acceso a recursos para que esté disponible para muchos usuarios.

En este contexto, casi que cualquier cosa que quiera compartir es un recurso:

- Archivos

- mensajes

- Impresoras

- Servicios

- etc.

Cuando necesito compartir recursos, se merece un sistema distribuido. Recurso es un concepto amplio que puede ser cosas o procesos de negocio.

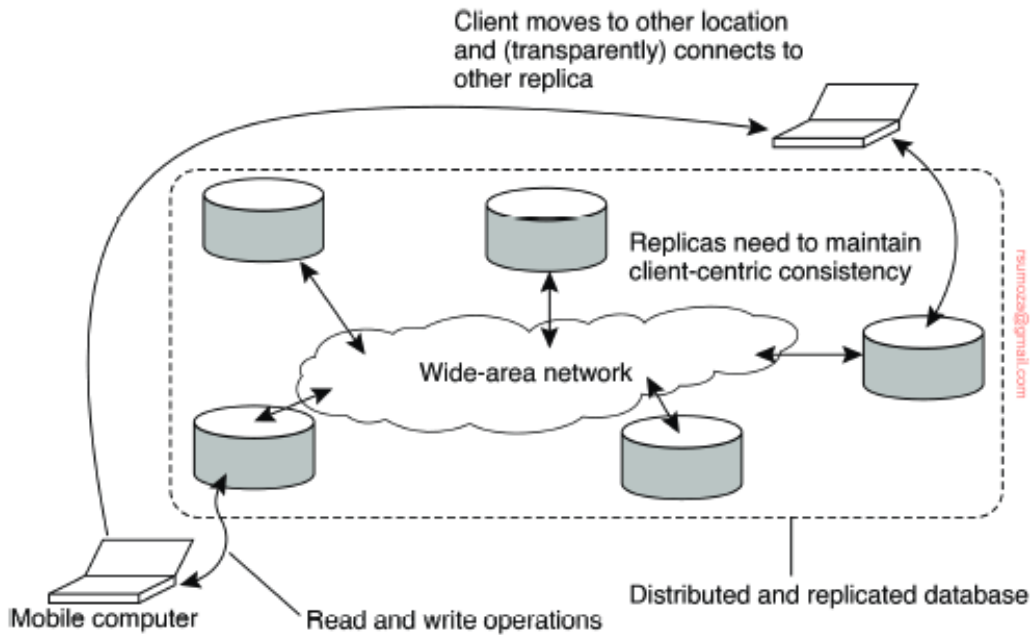

Transparencia en el acceso

Necesitamos esconder la ubicación de los recursos de la gente que accede Pero hay varios aspectos para "esconder" o hacer transparente:

- El acceso (representaciones de datos, sistemas operativos)

- La ubicación (donde está ubicado: data center, uno o varios)

- Reubicación (si muevo el recurso mientras lo estoy accediendo)

- Si yo me muevo mientras que quiero acceder un recurso, debería de poder accederlo.

- Migración (si el recurso se mueve)

- Si el recurso se mueve y yo no.

- Replicación (si hay una o varias copias del mismo recurso)

- Concurrencia (si hay muchos usuarios accediendo al mismo recurso)

- Fallas (el recurso puede fallar y recuperarse sin afectar el uso)

Con esconder, nos referimos a que deberíamos de poder acceder al recurso a pesar de cualquiera de estas condiciones previamente mencionadas.

Content Encoding: cuando se le pide un HTML muy pesado a un server en el browser, no se manda en Plain Text, sino que se zippea (comprime) y se manda.

Apertura e interoperabilidad

Un sistema abierto es cuando los componentes pueden ser usados por otros sistemas, y/o cuando el sistema tiene componentes originados por otro lado.

Normalmente nos referimos a:

- Sistemas que adhieren a reglas (protocolos) estándar.

La idea es que "todos nos apeguemos al mismo contrato", y que hagas fácil para el resto poder interactuar con dicho sistema.

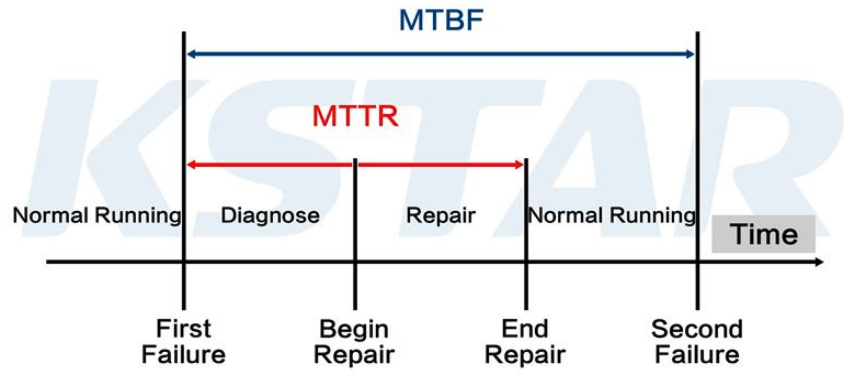

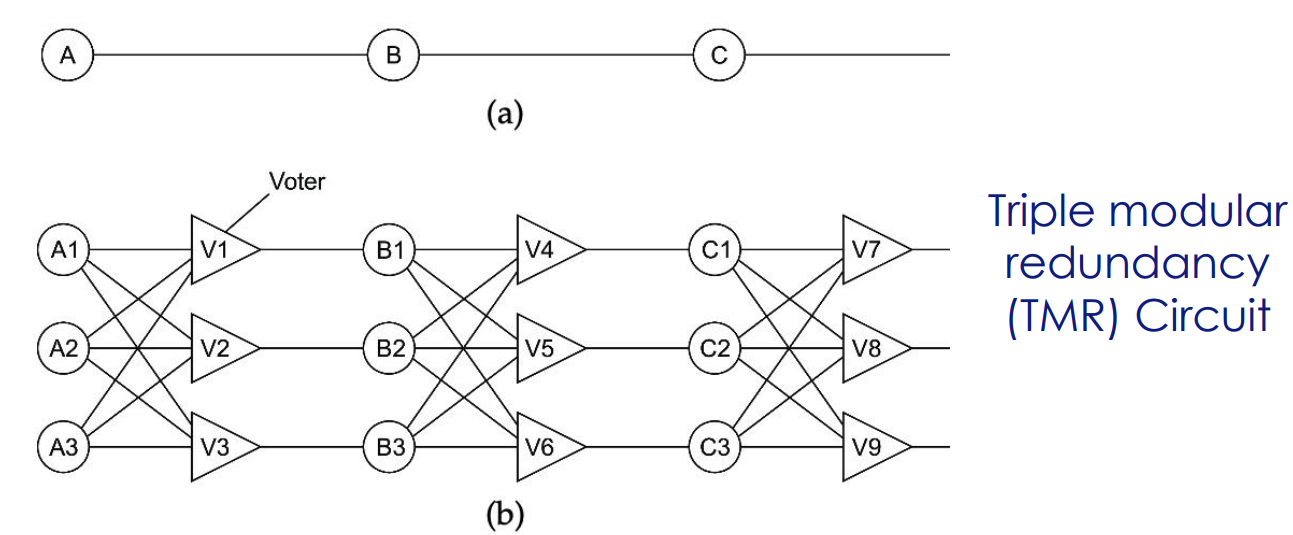

Confiabilidad

La confiabilidad de un sistema distribuido más compleja que uno centralizado:

¡Hay muchas más partes que pueden fallar!

Encima hay varios aspectos dentro de la confiabilidad:

- Disponibilidad

- Cuánto tiempo digo que voy a estar disponible

- Fiabilidad (reliability)

- Qué porcentaje del tiempo que digo que voy a estar disponible realmente estoy disponible

- Seguridad ante fallas (safety)

- Qué tan resiliente es el sistema, qué tanto soporta las fallas

- Mantenibilidad

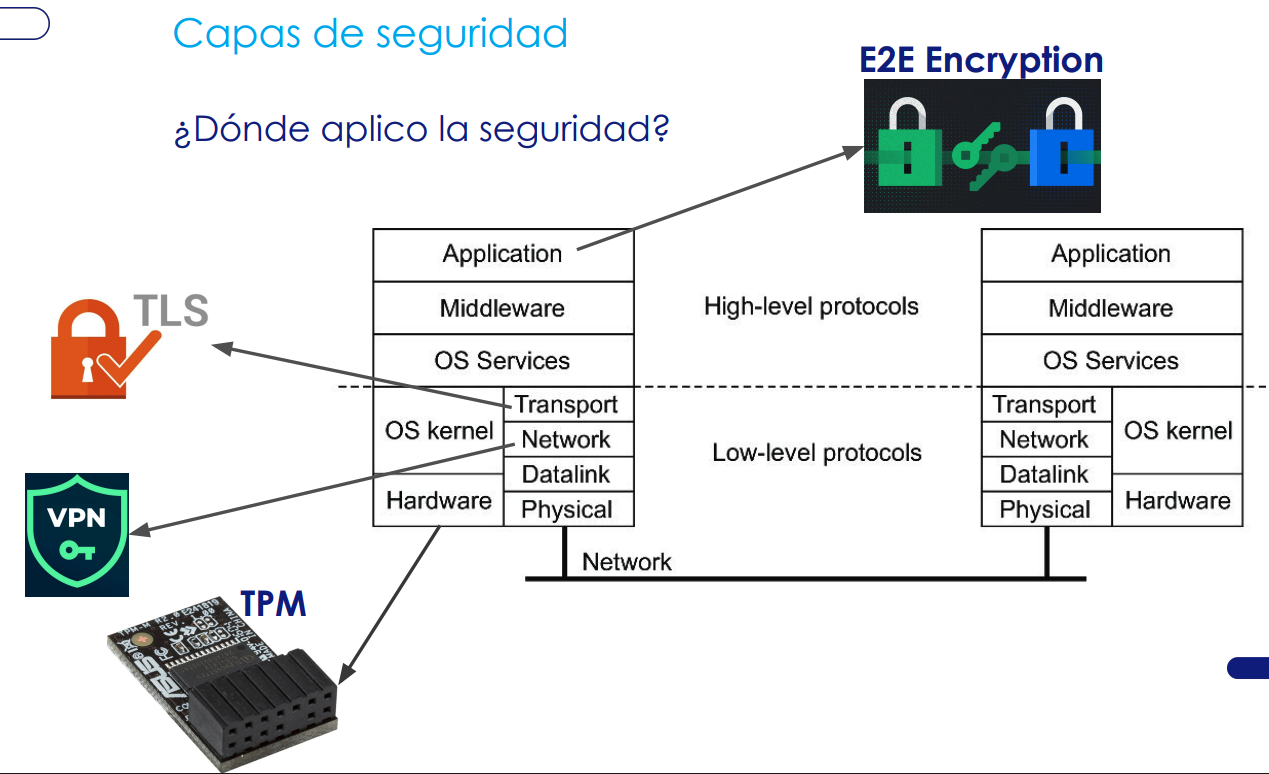

Seguridad

Queremos proteger el sistema de usos indebidos (en un concepto amplio)

Los conceptos comunes de seguridad:

- Identificación (quién sos)

- Autenticación (sos quien decís ser)

- Autorización (hacés sólo lo que tenés permitido hacer)

Otros aspectos relacionados:

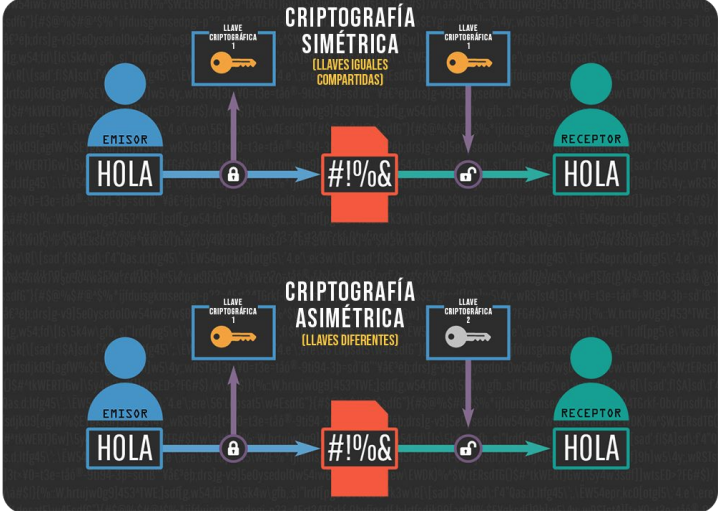

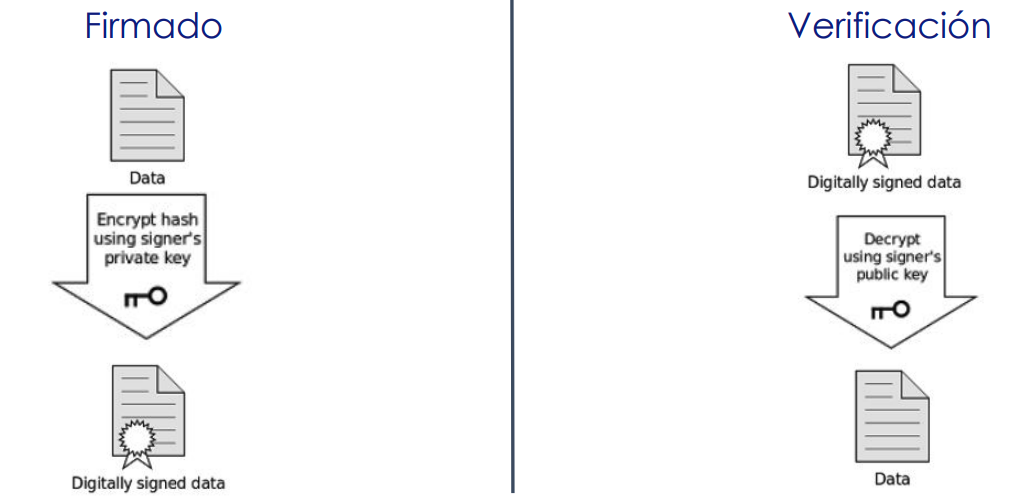

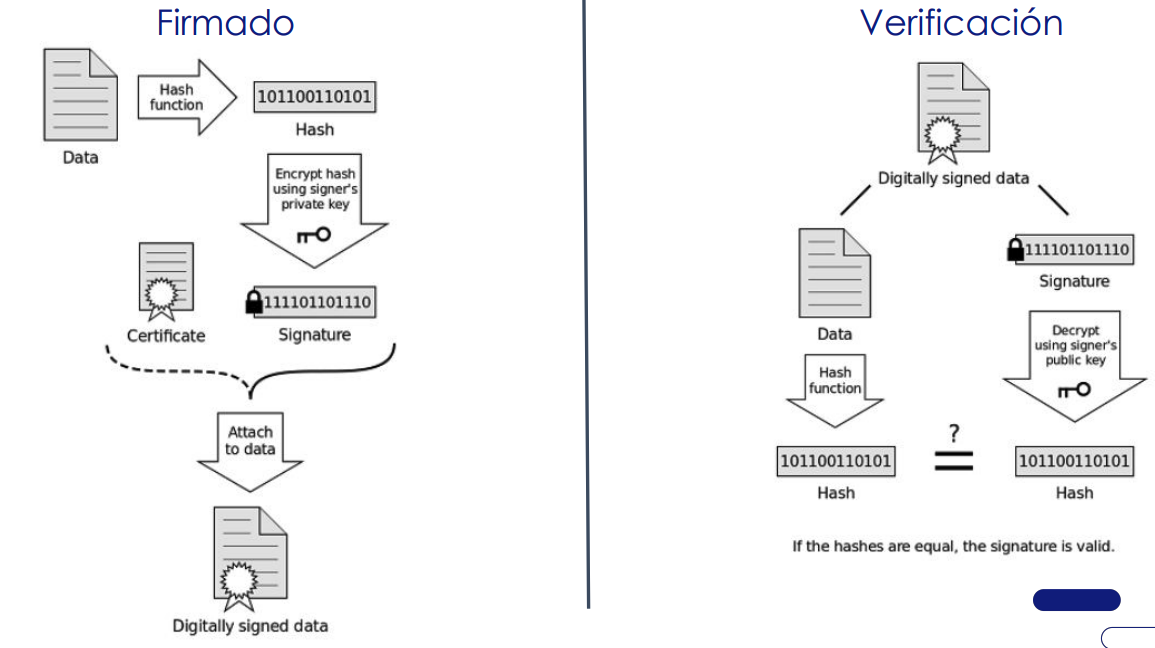

- Privacidad de la comunicación (que no escuchen nuestras conversaciones)

- Intercepción de la comunicación (que no se hagan pasar por otro)

Escalabilidad

Hay varias dimensiones relacionadas con la escalabilidad:

- En tamaño (cuántos usuarios o recursos acceden al sistema)

- Aumenta mucho el tráfico

- Puedo tener una Raspberry Pi con 124.000.000 intentos de conexión. No va a andar bien ni en pedo, tampoco escala.

- En geografía (si se accede al sistema desde distintas ubicaciones físicas)

- En administración (se puede administrar, aunque crezca)

Estrategias de escalamiento

- Mejorar la latencia: hacer eficiente la comunicación

- Es el tiempo "muerto" donde no se está procesando nada.

- Si bajo la latencia, puedo dedicarle más tiempo al procesamiento, justamente. Puedo acelerar la comunicación.

- Particionar y distribuir: llegar más rápido al dato.

- Tengo un F.S en la facultad. Si está en un sólo servidor, se van a encolar todas las requests que se hagan al server.

- Si particiono los F.S por apellido, puedo acceder más rápido a la información. Puedo paralelizar esos accesos.

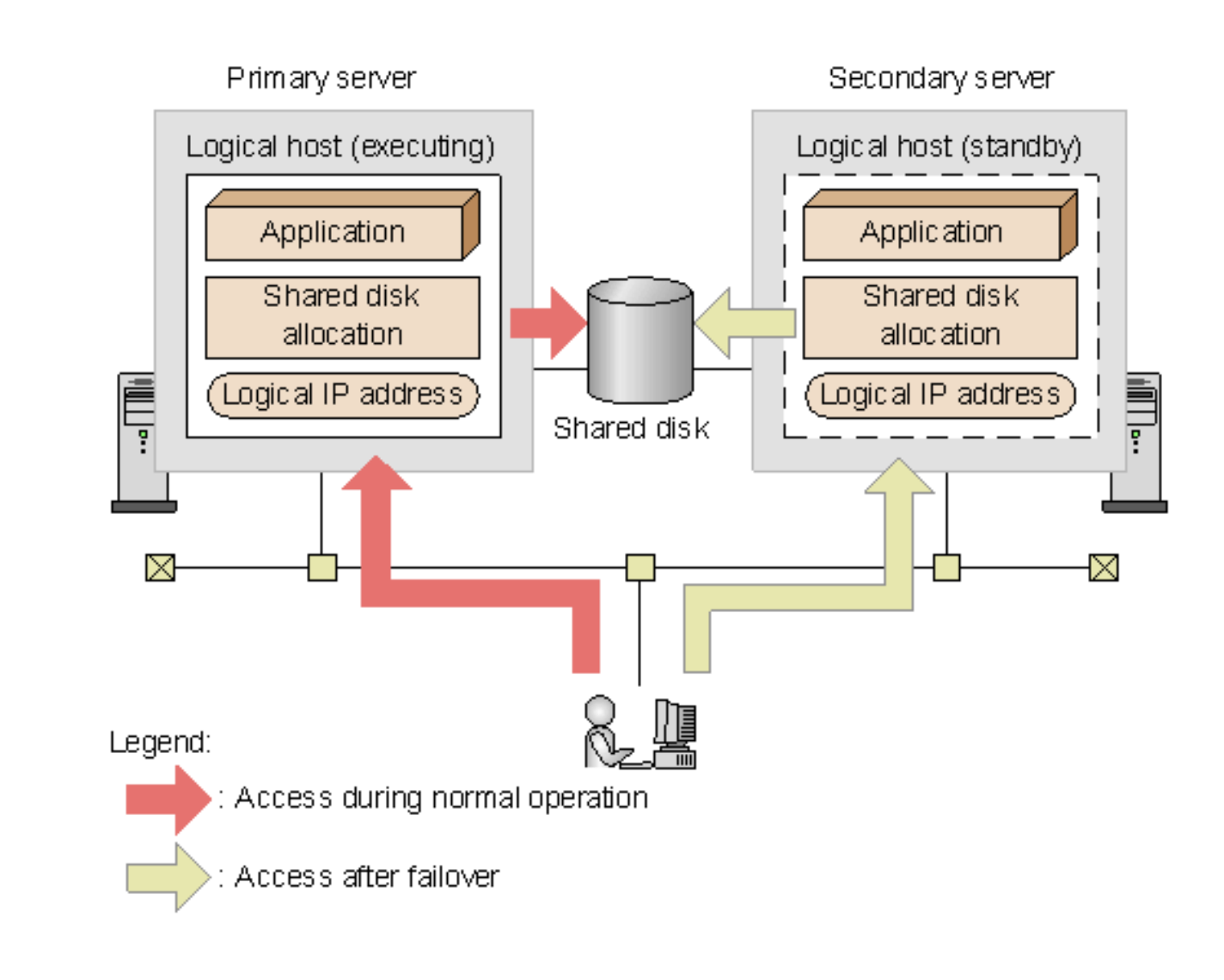

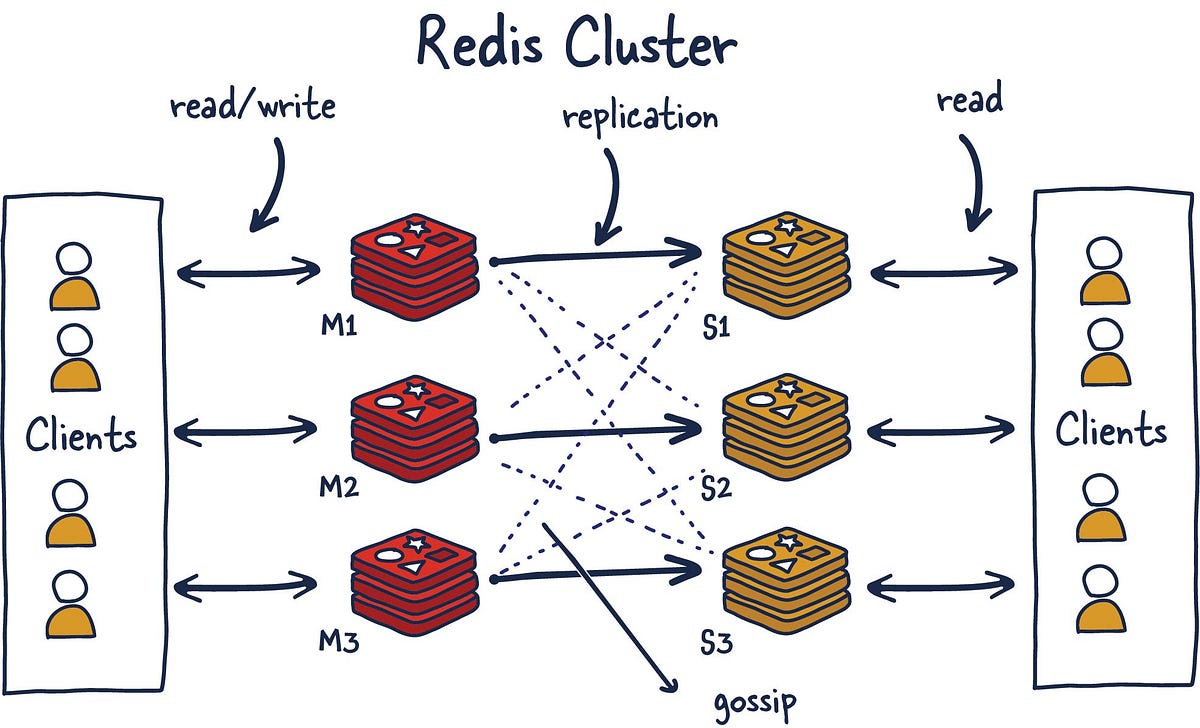

- Replicar: Orphan black y sus derivadas

- Es tener copias idénticas del recurso. Puedo darle una copia a los de un lado, otra a los de otro, así no acaparo el ancho de banda principal.

- Es una copia fiel, a diferencia del cache, más "pull".

- Caching: casi un clon, pero de una forma más específica

- Tengo una sola fuente de información, pero tengo almacenamientos intermedios que le hacen de copia a los que me preguntan.

- El cache es una copia "volátil", más "push".

- Usar esto o una réplica cambia muchas cosas dentro de la arquitectura.

El arte de hacer un sistema distribuido es hacer un trade-off entre escalabilidad, costos y capacidades.

YAC de sistemas distribuidos

YAC = yet another classification

YAML = yet another markup language

- Computación de alta performance

- Cluster computing (están todos juntos)

- Grid computing (sistema descentralizado cooperando)

- Masivo, muchas computadoras.

- Sistemas de información distribuidos

- Este es el mundo empresarial de esos días

- Enterprise application integration

- Sistemas ubicuos (pervasive)

- IoT

- Sistemas para dispositivos móviles

Derribando mitos

Verdadero o falso:

- La red es confiable

- La red es segura

- La red es homogénea

- La topología de la red no cambia

- La latencia es cero

- El ancho de banda es infinito

- El costo de comunicación es cero

- Hay una sola administración

Spoiler: son todas falsas.

Arquitectura de software

La idea principal es conocer los patrones de arquitectura que podemos usar para conectar sus partes. Tenemos que preguntarnos cosas como:

- ¿Qué distribución funcional y técnica de componentes usamos?

- ¿Cómo conectamos las piezas de software?

La elección de la arquitectura define las características del sistema:

- Capacidades, restricciones y desempeño

- Estilo arquitectónico

Estilos arquitectónicos

Hay básicamente 3 estilos:

- Por capas

- Orientada a servicios

- Pub/Sub

Por capas

Siempre van de arriba para abajo. Ejemplo: Stack de comunicación TCP, la arquitectura que siguen todos los proyectos de Spring.

Aplicaciones por capas. Modelo de 3 capas (aplicación, procesos y datos).

Orientada a servicios

Separo componentes funcionales en vez de por nivel de abstracción.

Criterios/formas para distribuir:

- Objetos

- Componentes

- Recursos (REST)

Es necesario saber los contratos de los componentes disponibles para usar, para saber qué me ofrece. No tiene mucha ciencia:

- Tengo un servicio que me devuelve la ubicación geográfica de una IP

- Tengo otro que, luego de autenticarme, me devuelve mi saldo de Mercado Pago

- ... Compongo estos servicios para desarrollar mis funcionalidades.

Distinción importante entre arquitecturas:

- ¿Necesito algún "ware" en el "middle"?

- Se comunican las partes directamente sin intermediarios

Middleware sirve para enviar mensajes entre orígenes y destinatarios. Es un cacho de software que se para en el medio y hace de mediador entre cliente y servidor, por ejemplo. Es una pieza de software más para administrar.

| Acoplado temporalmente | Desacoplado temporalmente | |

|---|---|---|

| Acoplado x referencia | Comunicación directa online. • Llamada REST | Mailbox: • Te dejo el mensaje |

| Desacoplado x referencia | Eventos • Notificar algo y los que están escuchando hacen | Espacio compartido de datos • Digo algo y los que quieren lo toman y accionan |

Pub/Sub

Tenés un montón de soluciones: Apache Kafka, Redis, RabbitMQ, etc.

Es un diseño desacoplado. Requiere una pieza de software adicional como intermediario.

No requiere que productores y consumidores estén disponibles al mismo tiempo. La asincronía requiere cierta relajación de los requerimientos de performance.

La diferencia principal entre eventos y espacio compartido es la persistencia del mensaje.

Middleware

Mediar entre componentes vía interfaces. Modelos:

- Wrappers

- Interceptor

La diferencia radica en lo siguiente:

- El wrapper es una implementación distinta que encapsula una implementación ya existente, pero le agrego comportamiento.

- Ej: File System. Tengo que leer un archivo puntual. No sé si estoy leyendo un disco físico o uno en la nube. Con la implementación que ya tenía sólo podía leer discos físicos, pero con el Wrapper que implementaron en la última versión puedo leer discos en OneDrive (?).

- El interceptor se pone más abajo, casi a nivel de protocolo, y en lugar de hacer la llamada directa lo manda por detrás a otro servicio. Ataja la llamada en el medio y la reenvía.

- Ej: File System. No sé qué disco estoy leyendo para acceder a un archivo en particular porque me lo resuelve el Interceptor que opera en el medio.

Otra vuelta de la arquitectura por capas

Cliente - Servidor: el clásico / casi una reliquia. Multi capas - algo más común, siempre separamos un poco más.

Ejemplos

- NFS

- Network File System

- WWW (World-Wide-Web)

- Abajo de todo está TCP/IP.

Criterios de distribución

Distribución vertical y horizontal.

Vertical: tengo varios nodos que hacen lo mismo Horizontal: tengo un nodo que cumple distintas funciones

Cuando están desacoplados, ¿cómo encuentro al destinatario?

¿Qué función cumplen los nodos? ¿Son todos iguales?

Distribución estructurada vs. peer to peer.

Conclusiones

Hay un montón de opciones para distribuir los componentes. La forma determina problemas y soluciones. Elegir una forma adecuada para los requerimientos es fundamental.

Arquitectura del sistema = distribución física de procesos y conexiones

La de sistema es la más técnica. Arquitectura de software = estructura funcional y patrones de uso

Procesos

Procesos e hilos

Tanto procesos como threads son formas de ejecutar en paralelo distintas funciones del sistema (Obvio...¿no?)

Los thread nos permiten separar las operaciones lentas (como el I/O) para no entorpecer el funcionamiento general del sistema.

Es una decisión de arquitectura interna del programa como usar los threads para mejorar el rendimiento general.

Muchas veces confiamos en la plataforma para que nos resuelva el manejo de threads pero a veces es importante ajustarlo a nuestras necesidades.

Virtualización

La clásica (toda la compu)

Contenedores

- Un poco más liviano

- Docker, Kubernetes

Clientes en entornos virtuales

- La clásica terminal

- X Windows

- Escritorios remotos

La virtualización tiene, en cierto punto, un beneficio sobre la fiabilidad en runtime (?).

Clientes

El que representa a los usuarios.

Representan la interfaz de los clientes contra los servicios:

- Escritorios remotos

- Protocolos de acceso a servicios (NFS)

- Web Browser

- Progressive Web Apps

Servidores

El que atiende a todos los clientes. En la mayoría de los casos hay un patrón común:

- Reciben conexiones en puertos de red.

- Procesan pedidos y devuelven una respuesta.

Los threads que se ejecutan en un server describe la arquitectura de software como procesan los pedidos

Hay servers que mantienen estado de sus clientes:

- Stateful vs. Stateless

- Back For Front (BFF).

- Están tuneados para lo que necesitan para las aplicaciones móviles.

- Si los servicios de backend de abajo cambian, sólo cambia el Back For Front y no la implementación directa de la aplicación móvil.

Definir que vas a usar un BFF es una decisión de arquitectura de software.

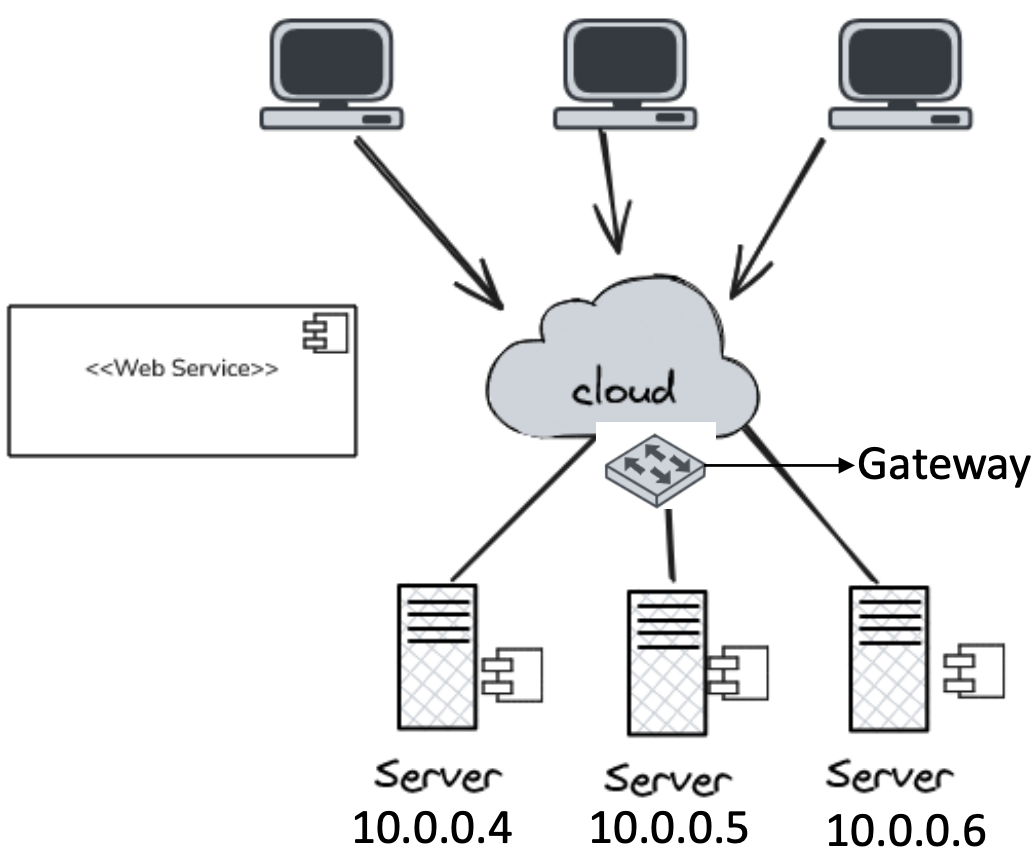

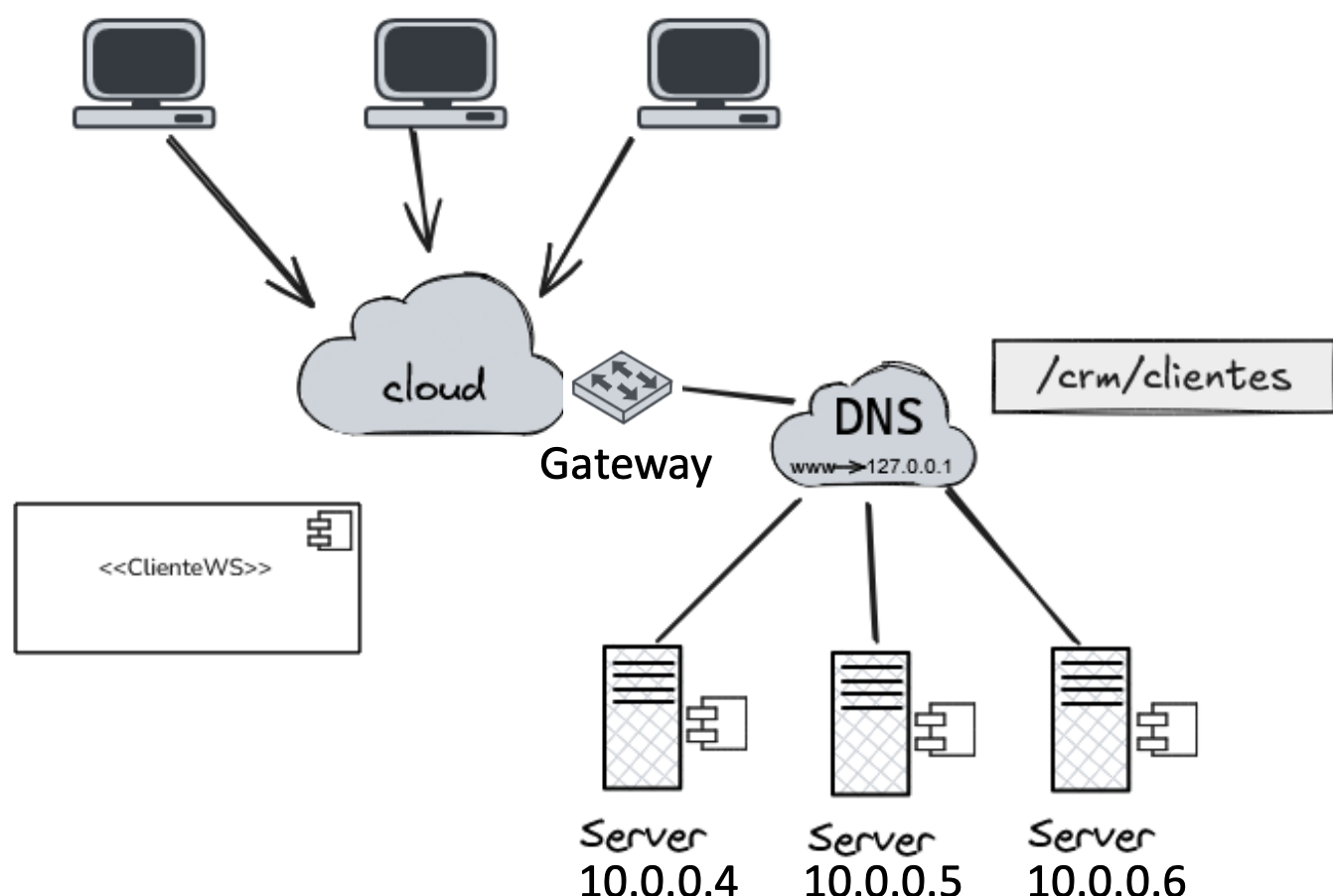

Cómo se implementa el escalamiento del server HTTP o TCP:

- Balanceador de carga.

- Es un intermediario que tiene que existir casi siempre en este tipo de sistemas.

- Es un pasamano que intercepta el mensaje, se fija quién está disponible y se lo manda.

- Si se quiere hacer escalamiento, es necesario un balanceador de carga.

- Existen versiones físicas y de software.

Migración de código

Dentro de la virtualización.

¿Qué hay que tener en cuenta para permitir una migración?

- Soporte de la infraestructura

- Características de soporte (reinicios, notificaciones)

Escalado horizontal o vertical Ejemplos:

- VmWare

- Migra una máquina de un equipo al otro y vos no te enteraste.

- Kubernetes

- Si vos querés escalarlo, te baja el POD y te lo levanta en otro lado. Te hace un reinicio para este "autoescalado".

- Azure

- AWS

La virtualización y el escalamiento tienen sus chiches para cuando se quiera migrar la infraestructura.

Conclusiones

Los procesos son la base de cualquier infraestructura de software, aunque sean centralizados o distribuidos.

La arquitectura interna de los procesos con threads es fundamental para la arquitectura del sistema.

La mayoría de las veces, nuestros procesos corren en ambientes virtualizados, y la migración de código se hace de forma transparente.

Sin embargo, es importante entender cómo los cambios de base afectan los procesos en ejecución.

TP1

Están pensando en hacer un servicio que dada una IP te devuelva una ubicación, y otro servicio que dada una coordenada te devuelva un clima.

Escalándolo...

- Cientos de miles de personas tratando de usarlo.

Clase 2

Un sistema distribuido es uno que involucra varios dispositivos que se comunican a través de la red, y trabajan en conjunto con tal de lograr un objetivo en común.

¿Qué diferencia tiene respecto a un sistema paralelo/concurrente?

- Los distribuidos involucran diferentes dispositivos, mientras que los concurrentes son parte del mismo dispositivo.

- Los distribuidos están "un nivel por encima".

- Un sistema distribuido (SD), al contrario de un sistema paralelo (memoria compartida + clock único), tiene distintos clocks (ergo noción del tiempo). Más específicamente, cada nodo tiene su propio clock.

¿Qué problemas podemos llegar a tener?

- Saber quién llegó primero a realizar una solicitud.

- Un nodo puede tener un registro de un mensaje en tal hora, y que otro tenga el mismo, pero sin considerar la latencia que hay entre nodos por su distancia.

En SDs, siempre terminamos haciendo estimaciones en cuanto al tiempo, como en Análisis Numérico.

Un sistema distribuido puede ser...

- Centralizado: el control lo tiene un ente central.

- Depende organizativamente de una cierta toma de decisiones.

- Depende de quién toma la decisión, no cómo se toma a nivel de hardware.

- A pesar de haber varias instancias o un cluster de nodos, se puede dar el caso en el que tomen la decisión de manera autónoma, sin pedirle permiso a otros.

- Descentralizado: el control se distribuye entre varios nodos.

- Las decisiones las toman varios nodos.

- Surgen nuevos problemas, como qué esquema de votación se implementa.

Esta clasificación depende de:

- Donde guardo los datos

- Cómo se distribuye el control y gestión de los datos

- Ubicación de los nodos

La distribución del sistema siempre debe ser transparente. La forma de actuar con el sistema debe ser la misma, independientemente de dónde me encuentre.

Aclaraciones respecto de la clase pasada

Un servidor en Brasil suele ser más caro que en EE.UU, puesto que en USA abundan mucho más los servidores, además de que la energía es potencialmente más barata.

Es muy raro que existan servidores en América del Sur.

Si montamos un servicio en servers de Amazon en USA, va a andar bien a pesar de la lejanía. ¿Por qué? Hay cables directos que conectan Argentina con USA-East.

CAP

- Consistencia: si yo escribo A en un lugar, y lo leo desde otro lado, tengo que leer A, sin modificaciones.

- Disponibilidad: está estrictamente relacionada con la consistencia, puesto que quiero respuestas rápidas.

- En el caso de las bases no relacionales, empieza a haber un trade-off entre la C y la D. A veces puedo llegar a querer responder rápido en lugar de responder con lo último.

- Volviendo al caso de la clase pasada (caso símil Netflix), con las recomendaciones voy a tener un problema (hasta cierto punto), puesto que no siempre quiero lo último.

- En cambio, para casos como los pagos, voy a necesitar darle prioridad a la consistencia. No puedo darle un servicio al usuario hasta que sepa que pagó.

- Particionamiento: con algún criterio, elijo cómo distribuyo los valores que persisto en mis distintas instancias.

- Problema: se cae una instancia, pierdo disponibilidad

- Solución: replicar las instancias con un cierto criterio.

- Ej: tener 2 réplicas para cada instancia.

Comunicación

Para comunicar 2 procesos, es necesaria alguna interfaz que medie entre estos. Por lo general, usamos algún protocolo de comunicación (ej: HTTP).

¿Para qué lo estudiamos?

- Porque es el método por el que los procesos distribuidos comparten información, lo que lo vuelve una pieza indispensable para hacerlos funcionar, y de forma eficiente.

- Porque el tipo de comunicación está fuertemente relacionado a requerimientos funcionales y no funcionales. Son decisiones de arquitectura

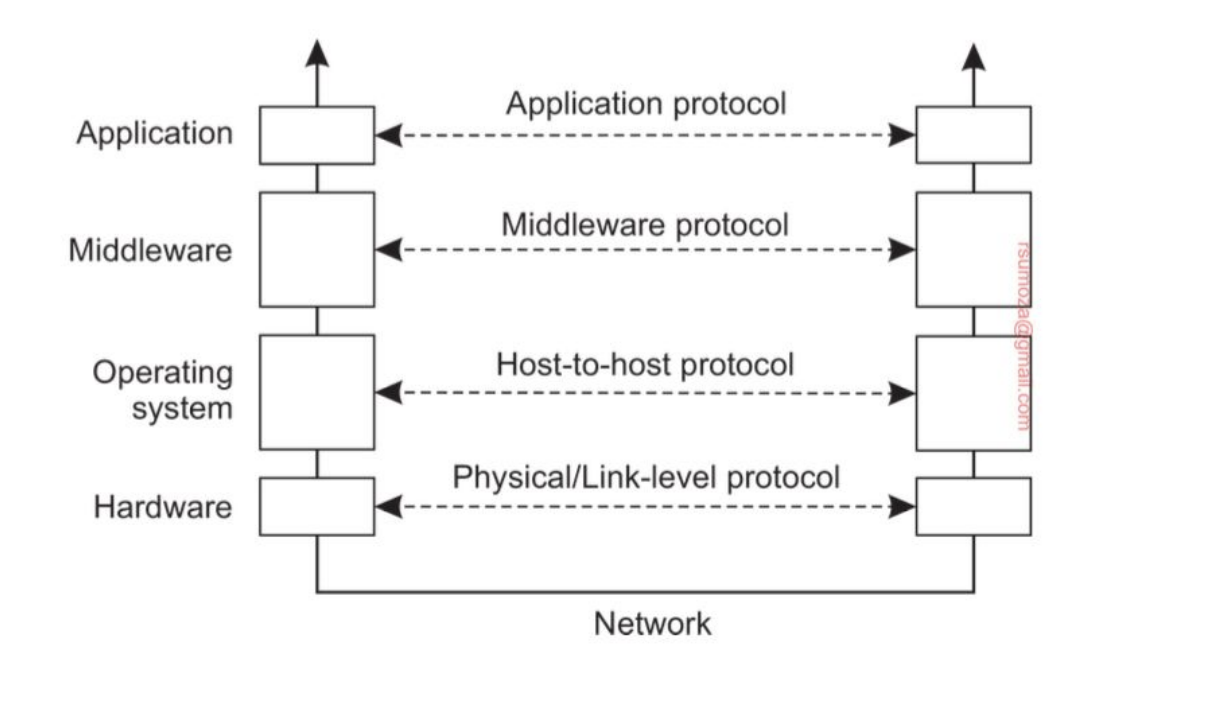

Modelo OSI

- El modelo OSI es un marco conceptual que divide la comunicación de redes en 7 capas organizadas de forma jerárquica.

- Sirve para estandarizar cómo los sistemas se comunican entre sí a través del uso de protocolos

- Cada capa se encarga de proveer servicios específicos a la capa superior.

- Del lado del emisor cada capa suma su header con su metadata al mensaje original. La versión final es enviada a través de la capa física

- Del lado del receptor cada capa procesa la parte del header correspondiente, la quita del mensaje y envía el resto a la parte superior

- Es importante notar que el modelo OSI es un modelo de referencia y no un conjunto de protocolos concretos Decimos que es un modelo porque es una representación de cómo funciona y cómo se envía la información a través de los distintos protocolos de comunicación.

Problema del Modelo OSI

TCP/IP le rompió el orto, para simplificar, porque era mucho más simple de implementar y modelar que OSI.

OSI, por su parte, yacía con el problema de que, para cada capa, había que implementar un protocolo puntual, lo cual le agregaba complejidad, ya que debía "funcionar" con el resto de protocolos (el de la capa de arriba, el de la de abajo, y consigo mismo).

TCP/IP ganó la guerra

Para que sean prácticos (tanto OSI como TCP/IP), hay que prestar mucha atención a cada capa.

No solemos interactuar mucho con las capas debajo de la de aplicación.

Capa de Middleware

Tanenbaum y otros autores terminan diferenciando la capa de middleware: procesos que corresponden a la capa de aplicación pero proveen servicios generales a otros procesos

- DNS le permite a las aplicaciones encontrar direcciones de red asociados a nombres (domains)

- Autenticación y autorización, que permiten identificar y permitir o denegar acceso

- Mismo lo hacemos a nivel capa de aplicación casi siempre, cuando implementamos o usamos (ej: Auth0) Authentication Middlewares, que validan si un usuario está autenticado y/o autorizado para realizar cierta acción.

Todo lo que hace el middleware es proveer capas de abstracción.

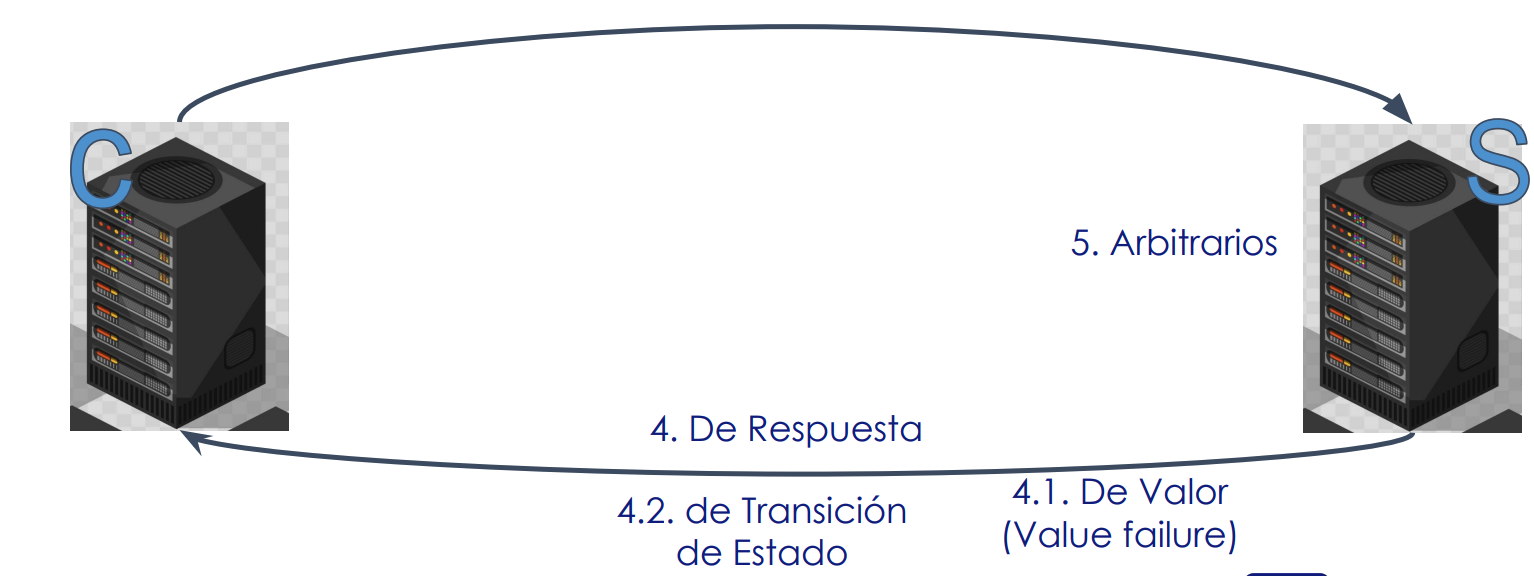

Tipos de comunicación

- Sincrónica: envío un mensaje y espero la respuesta, quedándome bloqueado hasta que llegue.

- Ej: una conversación cara a cara, una llamada.

- Asincrónica: emito el mensaje y trabajo con otra cosa; la respuesta me va a llegar cuando me tenga que llegar.

- Ej: una conversación por WhatsApp.

- Transitoria: si el receptor o alguna parte del sistema de transmisión falla, el mensaje se pierde

- Persistente: el middleware va a garantizar que el mensaje llegue al receptor, aunque no esté activo en ese momento.

Vamos a empezar a usar combinaciones de estos tipos de comunicación

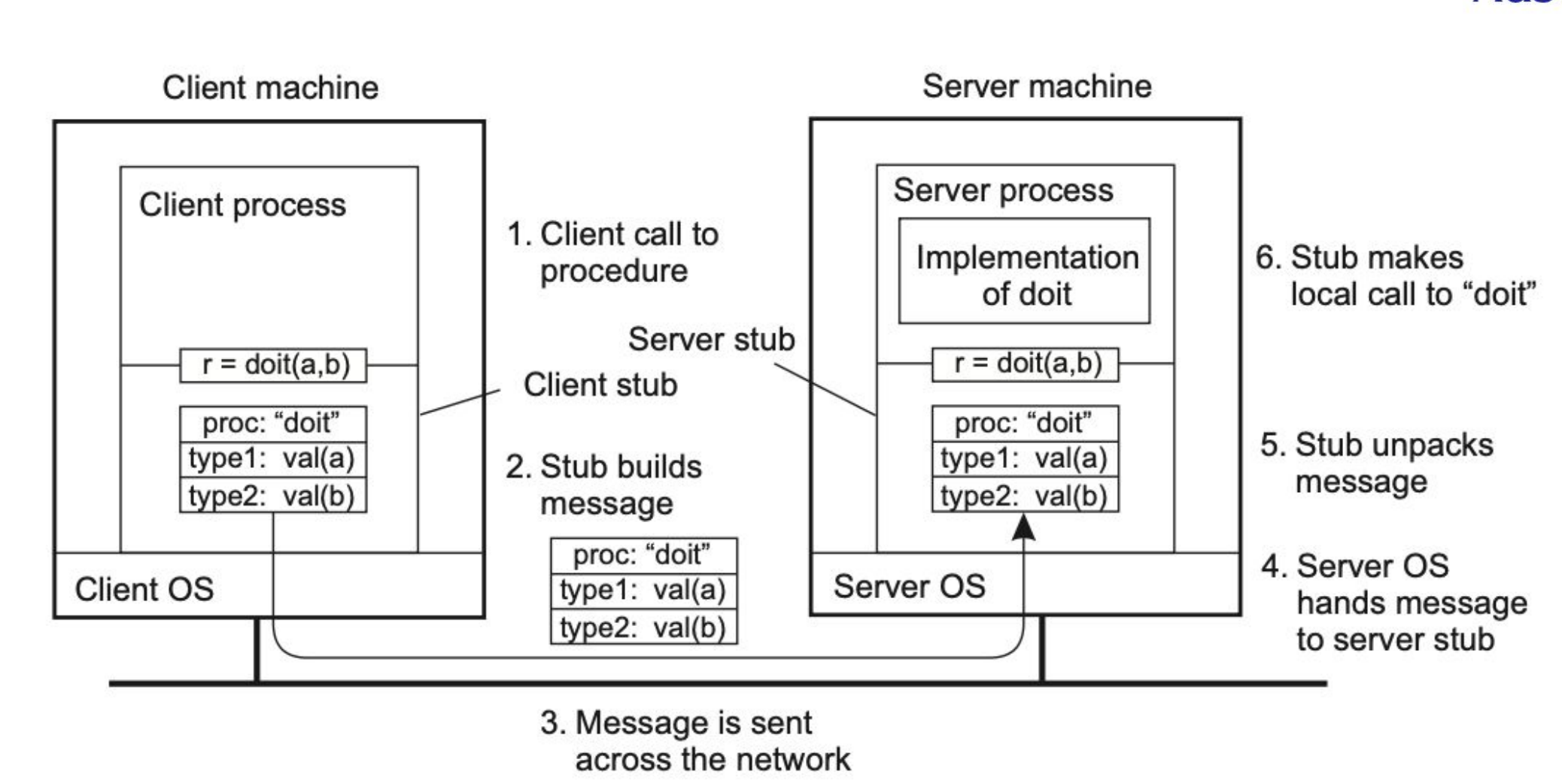

RPC

Refiere a Remote Procedure Call.

Anteriormente, las aplicaciones se programaban al punto de codear manualmente la forma de mandar mensajes. Es decir, leyendo el código, sabía perfectamente en qué momento se manda el mensaje, lo cual no era transparente.

Al presentar RPC, se planteó que la comunicación tiene que ser tan simple como llamar a un procedimiento de forma local, más allá de que se está ejecutando en otra máquina. La comunicación es totalmente transparente para el programador.

RPC es un modelo de comunicación que permite a un programa ejecutar procedimientos en otra máquina como si fuesen locales, cuya idea es esconder la complejidad de la red: yo llamo a la función sumar(2,3) desde mi notebook, y en lugar de correrlo localmente lo estoy corriendo en una Raspberry PI que tengo a 40 metros.

Procedimiento Función. Un procedimiento no devuelve un valor, es similar a una void function. Por eso RPC usa procedimientos.

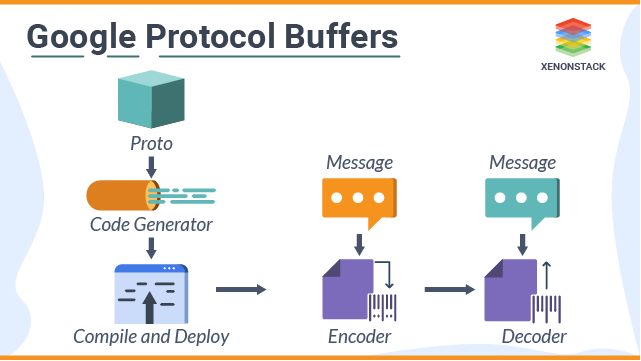

Stub: código que, en principio, no cumple el problema que estamos resolviendo, pero tiene herramientas que te brindan formas de hacerlo. Se encarga de transformar parámetros pasados entre el cliente y el servidor durante un RPC.

El cliente y el servidor conocen un stub en particular, que sirven como una interfaz que los abstraen de la forma de comunicación.

En resumidas cuentas, es un "middleware" que funciona como capa de abstracción entre cliente y servidor para que el cliente pueda ejecutar un RPC sobre el servidor.

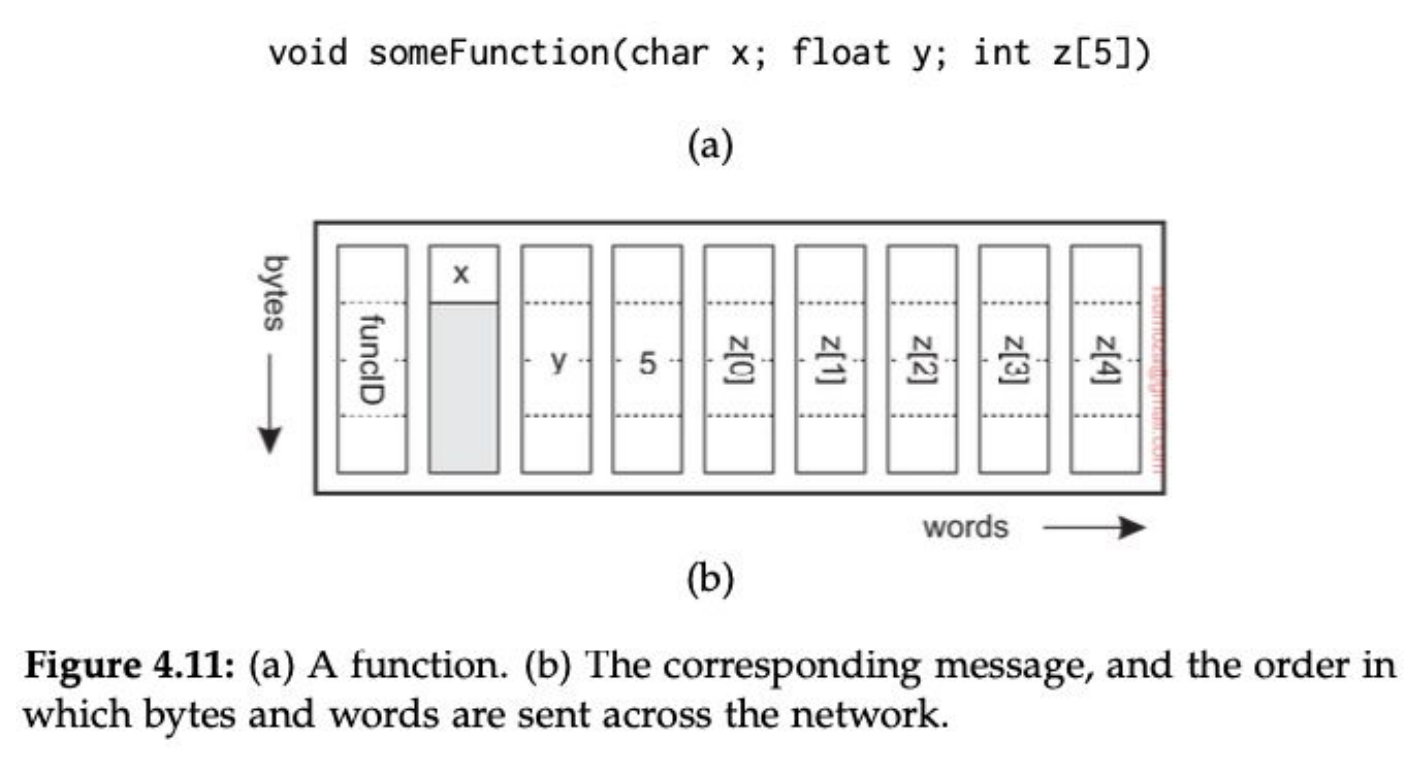

Parámetros

- Manejar parámetros en RPC no es trivial: codificar y decodificar los parámetros se llama marshalling (GO MENTIONED 🗣️🗣️) y unmarshalling.

- La idea es poder transformar información a formatos neutrales (bytes) que tanto el cliente como el server pueden interpretar de manera automática.

- Los problemas surgen cuando tratamos con punteros o colecciones: deberíamos enviar toda la colección o el objeto al que hace referencia el puntero al servidor. No es imposible pero tenemos que tener en cuenta que es costoso.

- Cuando tratamos con objetos muy complejos o colecciones anidadas el marshalling automático podría no estar disponible. Sería preferible manejarlo de manera manual.

- Estos problemas se alivian usando referencias globales.

¿Por qué no usamos JSON para sincronizar 2 stubs en RPC? Porque es súper ineficiente, si mando el JSON lo mando entero, no se comprime. Si bien existe RPC para JSON, es una cagada.

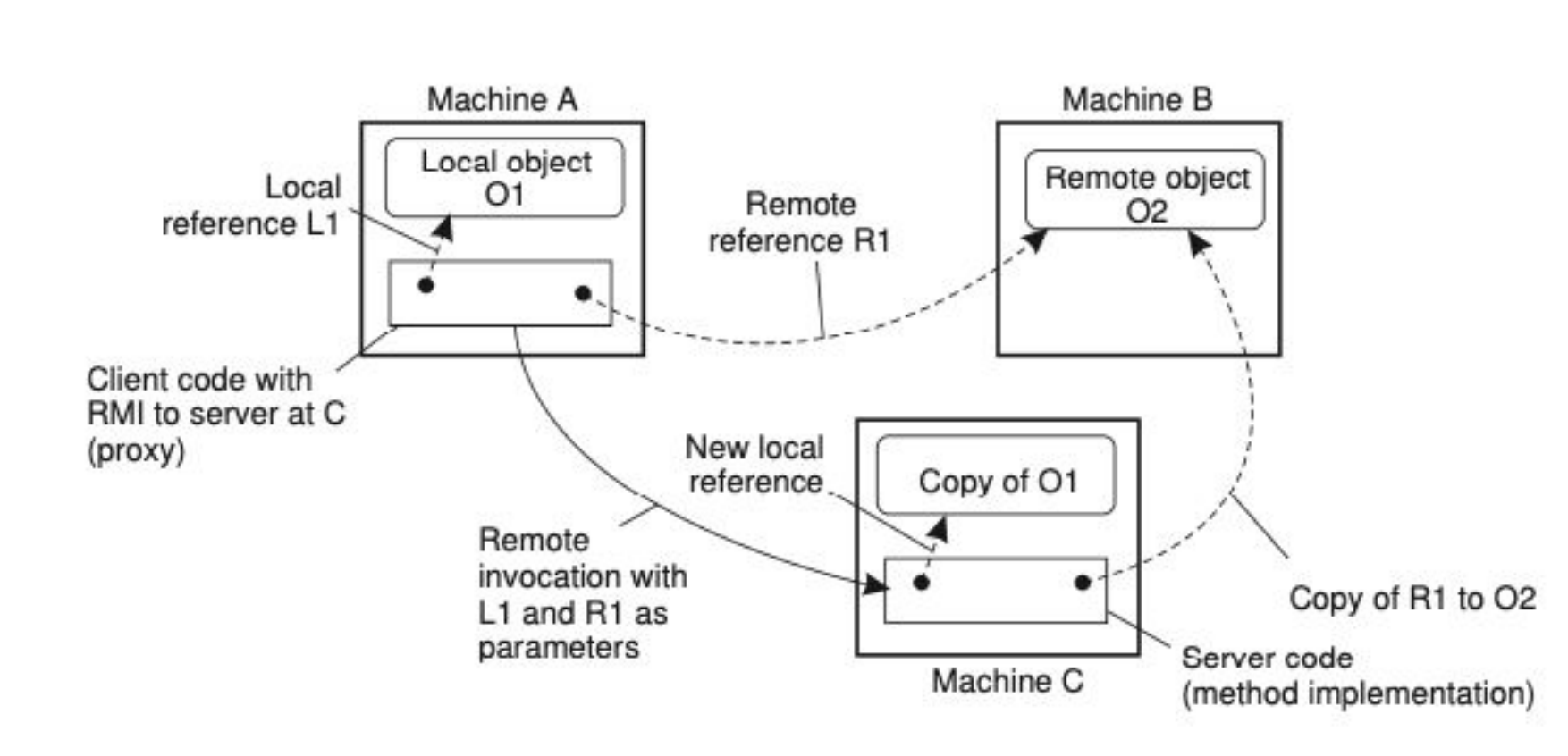

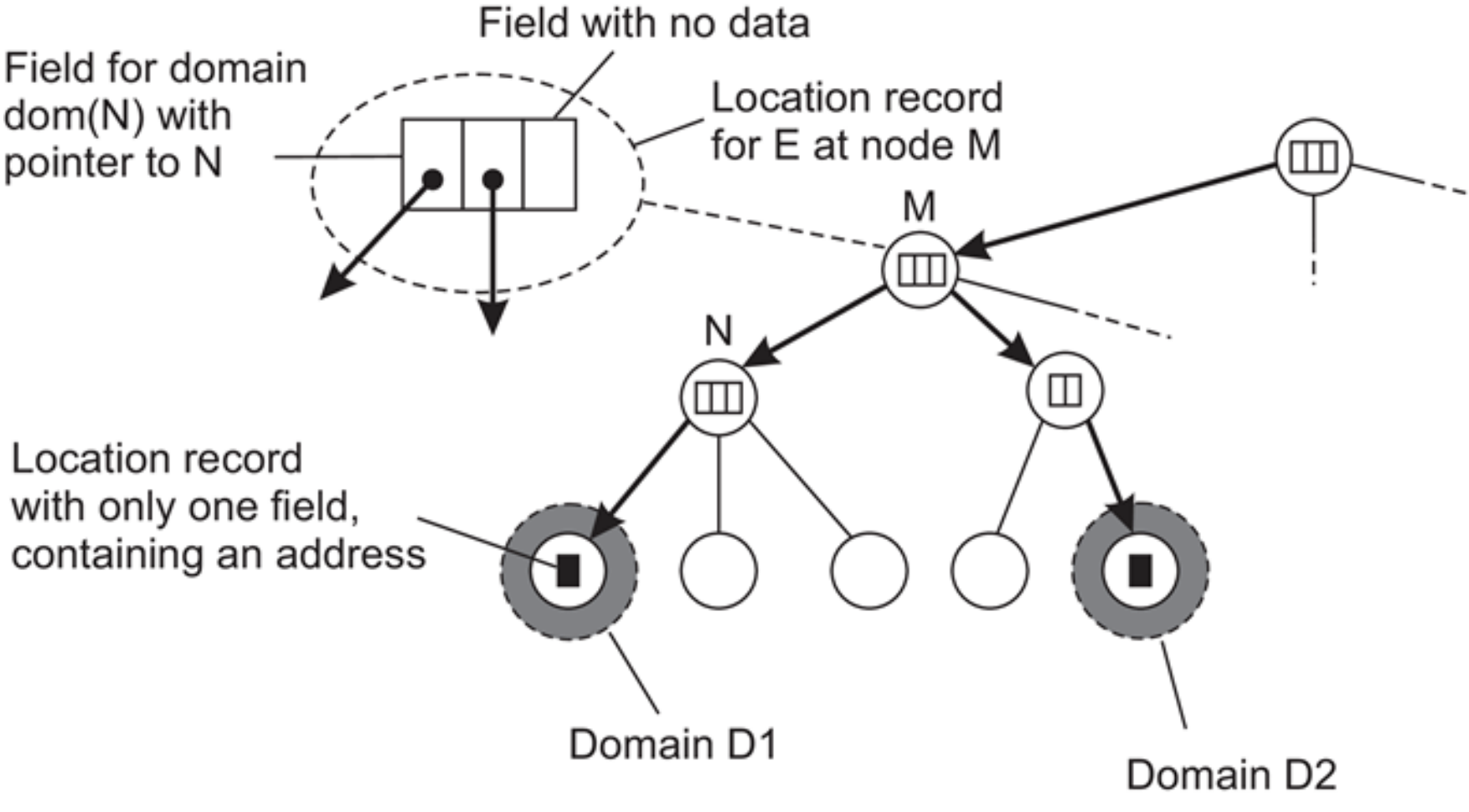

Referencias globales

Es una referencia que todos los miembros del sistema/programa conocen. En un sistema distribuido, que todos los servicios conozcan una referencia particular, se logra teniendo servicios/máquinas que estén dedicadas al pasaje de esa información o de esas referencias. Claramente, esto se hace cuando tenemos objetos relativamente pesados, si paso un int o un boolean por referencias globales usando RPC, soy un forro.

- Lo que se ve en la foto es lo siguiente:

- Machine

A– Objeto localO1- En la máquina

Aexiste un objeto localO1. - El cliente en

Atiene una referencia local (L1) para acceder a él directamente.

- En la máquina

- Machine

B– Objeto remotoO2- En la máquina

Bexiste un objeto remotoO2. - Machine

Atiene una referencia remota (R1) para invocar métodos sobreO2. - Esa referencia

R1es en realidad un proxy/stub que traduce las invocaciones locales en llamadas remotas aB.

- En la máquina

- Machine

C– Ejecución de un método remoto- El cliente en

Ainvoca un método remoto en MachineC, pasando como parámetros tantoL1(referencia a O1) comoR1(referencia aO2). - Machine

Crecibe esas referencias, y aquí ocurre lo importante:- Para

L1: en vez de pasar el objeto completo, se crea una copia deO1en MachineCcon una nueva referencia local. - Para

R1: en MachineCse crea una copia de la referencia remota aO2, de manera que desdeCse puede seguir invocando métodos sobre el objeto enB.

- Para

- El cliente en

- Machine

- En un sistema basado en objetos usar referencias es ideal

- Esto deja de ser eficiente cuando los objetos a los que hacemos referencia son pequeños (

ints,booleans)

Soporte

Si usamos RPC, el cliente y el servidor tienen que estar de acuerdo en el protocolo (formato de mensajes + procedimiento para manejar estructuras complejas). Para lograr eso, se puede especificar la interfaz y generar automáticamente los stubs. Otra alternativa es hacerlo parte del lenguaje.

Las diferentes herramientas de RPC lo hacen de manera automática.

¿Cómo armamos un sistema que use RPC?

Tenemos escenarios donde RPC es parte del lenguaje, lo cual sirve cuando los servicios están hechos con el mismo lenguaje. Un ejemplo en Java es RMI.

RPC es parte de la guía, lo vamos a tener que ver por nuestra cuenta.

Gran parte de los conocimientos los vamos a incorporar mejor de manera práctica.

Comunicación basada en mensajes

Los mensajes son finitos, en algún momento terminan, tienen un sentido (por esto un TcpStream de Rust no es un mensaje como tal, sino una cadena infinita de mensajes). En general tienen una interfaz que conocemos.

Los mensajes empiezan a ser relevantes en comunicación asíncrona, donde empiezan a surgir ciertas preguntas:

- ¿Qué pasa cuando el receptor no está activo en el momento en el que se genera la request?

- ¿Qué pasa cuando no queremos o necesitamos que la comunicación sea sincrónica?

- Excepto por algunas variaciones poco comunes, RPC no soporta estos casos. Y por eso necesitamos usar mensajes.

Necesitamos atajar estos problemas donde la comunicación falla, donde no sólo importa la transparencia de alto nivel.

Si la llamada falla en un HTTP Request, tengo que poder hacer un re-try.

Sockets

- Es posible armar una comunicación basada en mensajes usando los servicios que ofrece la capa de transporte. Es decir, fuera del middleware

- Son operaciones muy estandarizadas en diferentes interfaces, como los sockets que formaron parte de Berkeley Unix (BSD) y eventualmente fueron adoptados por POSIX

- Los sockets son abstracciones sobre el puerto que se usa para la comunicación

Tienen distintas operaciones:

Bind: asocia el socket a un puerto y host específicos.Listen: pone el socket en modo escucha para aceptar conexiones entrantes.Accept: acepta una conexión entrante y crea un nuevo socket para la comunicación.Connect: conecta el socket a un host y puerto remotos.Send: envía datos a través del socket.Recv: recibe datos del socket.Close: cierra el socket.

La implementación en Python tiene la particularidad de que escuchan de a N bytes. En el caso del ejemplo del slide, escucha de a 1024 bytes (1 kB). Va partiendo lo que va escuchando de a 1 kB, justamente.

Problemas de esta implementación:

- Tanto client como server se tienen que poner de acuerdo en muchas cosas:

- Host

- Port

- Protocolo de comunicación

- Tamaño del mensaje En resumen, no es nada transparente.

Soluciones a problemas de los sockets

ZeroMQ

- La implementación que vemos en clase es muy simple, y si queremos tener funcionalidades extras las tenemos que desarrollar nosotros, pero a modo explicativo ta güeno.

- Mejora las capacidades de los sistemas de comunicación basados en mensajes

- Simplifica y hace transparente los aspectos más concretos de las conexiones y nos permite tener un soporte para conexiones Many-to-One o One-to-Many

- Es asincrónico, pero basado en conexiones: esto implica que si el receptor no está activo para recibir los mensajes tiene que tener alguna forma de encolar los mensajes y enviarlos cuando pueda

- Ofrece tipos de socket que facilitan la programación de la comunicación. Estos tipos funcionan de a pares: REQ/REP, PUB/SUB, PUSH/PULL

Si tengo 2 procesos (P1, P2), y P1 le quiere mandar un mensaje a P2 pero P2 no está "despierto", P1 encola el mensaje (lo mantiene en memoria?) para mandarlo luego.

Si P2 quiere escuchar a P1 pero P1 muere, el mensaje que P1 le había mandado se pierde para siempre. De esta manera, a pesar de tener asincronismo, no tenemos consistencia.

ZeroMQ sigue teniendo el problema de tener que especificar dónde se quiere conectar, pero ta má güeno respecto a los sockets comunes.

- Socket default (TCP/IP)

from socket import *

class Server:

def run(self):

s = socket(AF_INET, SOCK_STREAM)

s.bind((HOST, PORT))

s.listen(1)

(conn, addr) = s.accept() # returns new socket and addr. client

while True: # forever

data = conn.recv(1024) # receive data from client

if not data: break # stop if client stopped

conn.send(data + b"*") # return sent data plus an "*"

conn.close() # close the connection

class Client:

def run(self):

s = socket(AF_INET, SOCK_STREAM)

s.connect((HOST, PORT)) # connect to server (block until accepted)

s.send(b"Hello, world") # send same data

data = s.recv(1024) # receive the response

print(data) # print what you received

s.send(b"") # tell the server to close

s.close() # close the connection

- Socket Req/Rep de ZeroMQ

import zmq

def server():

context = zmq.Context()

socket = context.socket(zmq.REP) # create reply socket

socket.bind("tcp://*:12345") # bind socket to address

while True:

message = socket.recv() # wait for incoming message

if not "STOP" in str(message): # if not to stop...

reply = str(message.decode()) + '*' # append "*" to message

socket.send(reply.encode()) # send it away (encoded)

else:

break # break out of loop and end

def client():

context = zmq.Context()

socket = context.socket(zmq.REQ) # create request socket

socket.connect("tcp://localhost:12345") # block until connected

socket.send(b"Hello world") # send message

message = socket.recv() # block until response

socket.send(b"STOP") # tell server to stop

print(message.decode()) # print result

- Socket Pub/Sub de ZeroMQ

import multiprocessing

import zmq, time

def server():

context = zmq.Context()

socket = context.socket(zmq.PUB) # create a publisher socket

socket.bind("tcp://*:12345") # bind socket to the address

while True:

time.sleep(5) # wait every 5 seconds

t = "TIME " + time.asctime()

socket.send(t.encode()) # publish the current time

def client():

context = zmq.Context()

socket = context.socket(zmq.SUB) # create a subscriber socket

socket.connect("tcp://localhost:12345") # connect to the server

socket.setsockopt(zmq.SUBSCRIBE, b"TIME") # subscribe to TIME messages

for i in range(5): # Five iterations

time_msg = socket.recv() # receive a message related to subscription

print(time_msg.decode()) # print the result

- Socket Push/Pull de ZeroMQ

def producer():

context = zmq.Context()

socket = context.socket(zmq.PUSH) # create a push socket

socket.bind("tcp://127.0.0.1:12345") # bind socket to address

while True:

workload = random.randint(1, 100) # compute workload

socket.send(pickle.dumps(workload)) # send workload to worker

time.sleep(workload / NWORKERS) # balance production by waiting

def worker(id):

context = zmq.Context()

socket = context.socket(zmq.PULL) # create a pull socket

socket.connect("tcp://localhost:12345") # connect to the producer

while True:

work = pickle.loads(socket.recv()) # receive work from a source

time.sleep(work) # pretend to work

REQ/REP es un modelo 1-1

El modelo PUSH/PULL lo que permite es distribuir los mensajes entre todos los "oyentes", y con que uno sólo lo escuche ta bien. ![]()

MPI

- Los sockets tienen 2 problemas: por un lado no hacen transparente la comunicación, sigue siendo necesario programar send y recv. Por otro, fueron diseñados para funcionar sobre TCP/IP, y no funcionaban sobre protocolos propietarios más eficientes y con soporte para funcionalidad más avanzada.

- Pero el hecho de que fueran propietarios traía un gran problema: los programas no eran portátiles. Solo funcionaban siempre y cuando el desarrollo fuese sobre la misma plataforma.

- En 1991 se empieza a desarrollar la Message Passing Interface, que ofrece operaciones estándar para el manejo de mensajes.

- Sin perder la eficiencia y escalabilidad que tenían los sistemas propietarios ofrece portabilidad y flexibilidad, soportando diferentes patrones de comunicación

Particularidades

- MPI está pensado para casos muy particulares

- Requiere que todos los procesos empiecen y terminen en simultáneo y todos sean creados bajo un mismo contexto que van a compartir para intercambiar mensajes. Es por esto que los detalles de comunicación son transparentes para el usuario.

- Funciona mejor en escenarios de baja latencia y amplio ancho de banda.

- Baja latencia en estos escenarios refiere a nanosegundos.

- Tiene optimizaciones para compartir mensajes por memoria, para ser más rápido que la interfaz TCP/IP incluso localmente. El entorno tiene que ser lo más homogéneo posible.

- No está adaptado para funcionar con tolerancia a fallos, si algo falla todo el sistema falla

[Ver ejemplo del repo de Rodri] Todos los procesos/nodos en MPI tienen un rango. Si el rango es 0, hablamos del nodo padre, que va a crear la data (generalmente).

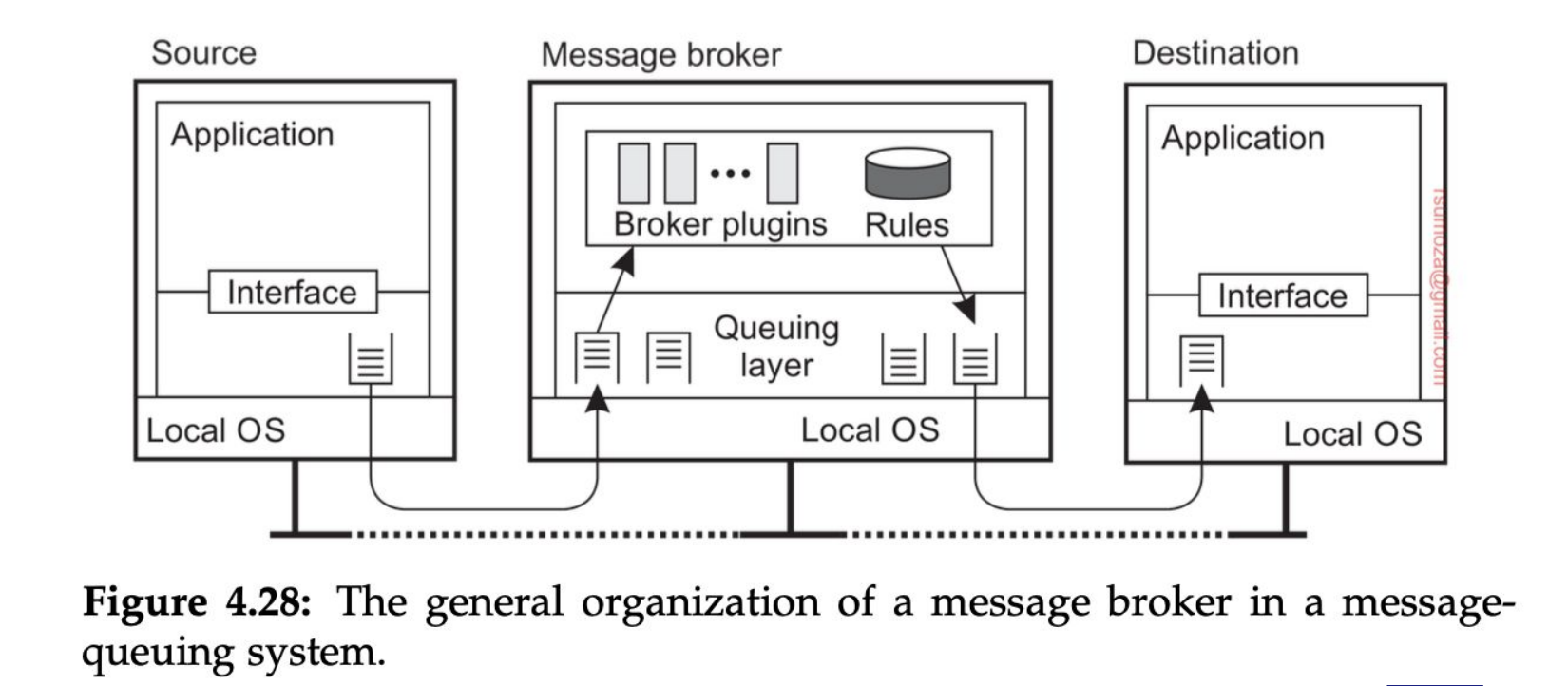

MoM (Message Oriented Middleware)

Llegamos al tipo de middleware basado en mensajes más importante: los sistemas de encolado de mensajes que proveen mecanismos de comunicación persistente asíncrona La única garantía que nos dan estos sistemas es que el mensaje va a ser insertado en la queue de destino. Y nada más.

Para poder enviar un mensaje a una queue es necesario conocer la queue a la que me tengo que conectar.

Hay sistemas donde la queue la vamos a sacar y vamos a administrar la queue como un proceso aparte. El chiste es que los procesos se puedan morir y revivir sin perder consistencia.

- Si se muere el proceso de la queue en estos casos (pensando en queues que viven en memoria), se pierden los mensajes

- Puede darse el caso de la queue

- Los brokers son, a grosso modo, intermediarios que operan entre los participantes de un proceso de comunicación, que "se fijan como hacer el pasamano de mensajes", hablando en criollo.

- Las distintas colas que maneja son por las diferentes prioridades que maneja el broker

- Está hecho para trabajar de manera modular, de modo que si un nuevo cliente quiere interactuar con algo desconocido para el broker, éste sólo debe "instalar el plugin" para manejar a este nuevo cliente

- Las reglas de negocio al cual pertenece el broker particular deben ser conocidas por este mismo, no debe ser agnóstico a estas.

Tiempo real: tiene que llegar en un orden correcto, pausado en el tiempo y en un momento específico en el tiempo. Es decir, debe respetar el orden y el tiempo que tardaría en la realidad, tiene que darse en los tiempos en los que yo espero percibir eso en la realidad.

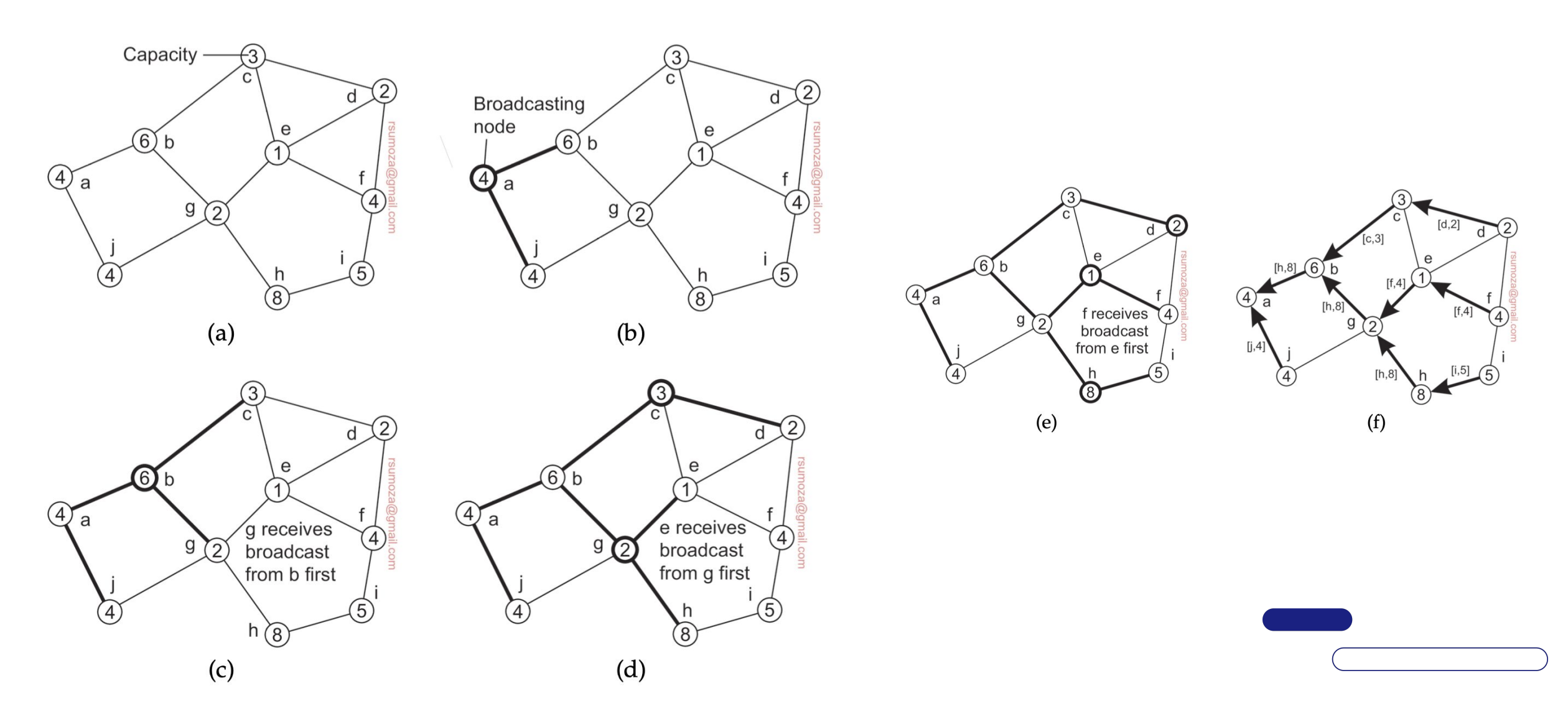

Broadcasting

Consiste en mandarle un mensaje a todos los oyentes/disponibles.

Multicasting

Consiste en mandarle un mensaje a varios de los oyentes/disponibles, mas no necesariamente a todos.

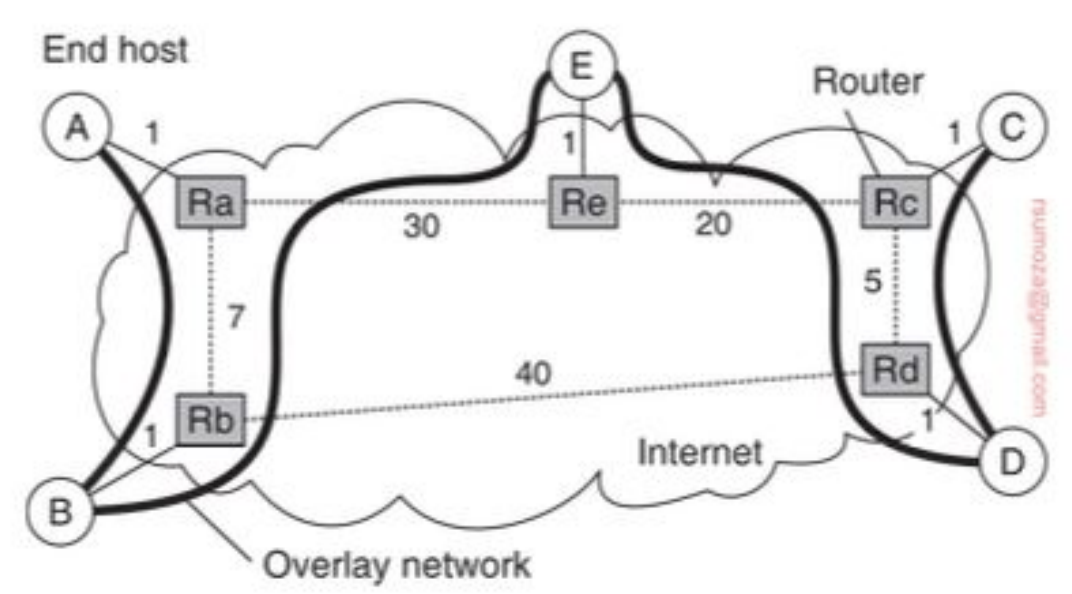

- La primera técnica que vamos a explorar es la de multicasting basado en árboles a nivel aplicación

- La distinción más relevante es que este árbol existe en la capa de aplicación y no la física. Es decir que tenemos una overlay network.

- ¿Cómo llegamos de A hasta C?

Métricas

Hay 3 métricas para medir la calidad del árbol: link stress, relative delay penalty (RDP) y tree cost.

Link Stress: cuántas veces un mismo paquete pasa por el mismo link físicoRDP: relación de demora entre seguir el camino de la red de aplicación y seguir el camino de la red física (aplicación/física) para llegar del nodo A al B. En general se promedian todos los RDP y se trata de minimizar ese valorTree Cost: es una métrica asociada al costo total del árbol. Para minimizarlo, es cuestión de encontrar un Minimal Spanning Tree (MST)

Particularidades

- Multicasting != broadcasting: cuando hago multicasting quiero enviar un mensaje a un conjunto de nodos, que no necesariamente son todos los nodos. Y obviamente quiero reducir la cantidad de nodos que procesan mensajes que no son para ellos.

- Una forma simple de resolver esto es tener multicast groups, sobre los que puedo hacer broadcasting. Son una overlay network sobre la overlay network original.

- Y para hacer broadcasting podemos usar el mecanismo de flooding: cada nodo envía el mensaje que recibió a todos sus vecinos, excepto al nodo que le envió el mensaje. También deberíamos evitar enviar mensajes que ya recibimos, lo cual requiere algún tipo de tracking.

- El mejor escenario es un grafo que sea un árbol (orden lineal de cantidad de mensajes), y el peor es un grafo completamente conectado (orden cuadrático).

- DISCRETE MATH MENTIONED 🗣️

Protocolos epidémicos

- Buscan propagar información rápidamente usando sólo información local

- Vamos a tener

- Nodos infectados (tienen el mensaje y lo van a compartir)

- Susceptible (no tiene el mensaje)

- Removidos (tiene el mensaje y no lo comparte)

- Y vamos a tener rondas, que son ventanas de tiempo en la que todos los nodos tomaron la iniciativa de intercambiar mensajes, una vez cada uno.

- Cada infectado elige a los próximos disponibles

- En estos casos, hablamos de modelos anti-entrópicos, ya que tienden al orden.

- Aquí cada nodo elige de forma random a otro vecino e intercambian updates.

- Una solución dentro de estos modelos es el de push/pull:

- Push no es una gran solución, porque conforme hay cada vez más infectados la probabilidad local de elegir un nodo susceptible es baja.

- Pull es más apropiado, porque conforme crece la cantidad de infectados los nodos susceptibles tienen más chances de elegir un nodo infectado.

- Push/Pull es la mejor solución y se puede demostrar empíricamente.

- Tenemos también algoritmos de gossiping o rumor spreading, los cuales funcionan de la siguiente manera: cuando el nodo P se contacta con el nodo Q para comunicarle un update y Q ya tenía ese update, con cierta probabilidad , P puede decidir volverse un nodo removido.

- Este método ta güeno para compartir información rápidamente pero no garantiza que todos los nodos van a recibir todas las actualizaciones. Para hacerla corta, es mucho más improbable saturar la red, puesto que puede pasar que no lleguemos a todos.

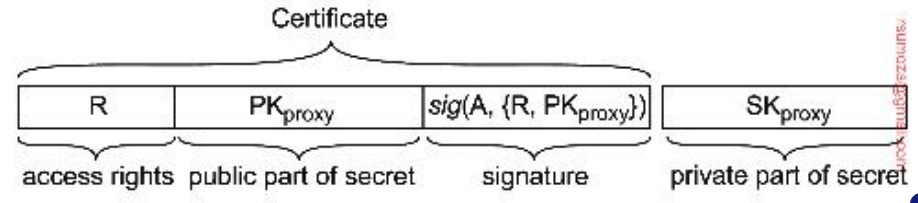

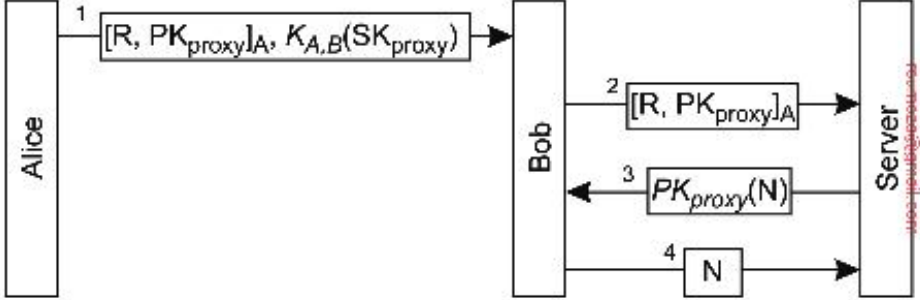

Certificados de distribución

- Para remover data tenemos que usar certificados de defunción de la data, de forma que si por alguna razón llega un update los nodos saben que tienen que ignorarlo.

- Los certificados pueden tener un timestamp que determina por cuánto tiempo tienen que almacenarse, de forma que los nodos solo los almacenen hasta un tiempo en el que se sabe que los mensajes viejos pueden seguir dando vuelta por el sistema

- Para garantizar un delete, algunos nodos van a mantener una lista de certificados permanente, de forma que si les llega un update sobre data que debería estar eliminada pueden volver a esparcir el certificado de defunción.

Coordinación

La idea es ordenar/orquestar 2 o más procesos para lograr un objetivo en común.

¿Por qué la estudiamos?

La coordinación es clave para determinar cuál es la verdad dentro del sistema.

Lo que necesitamos es que los nodos cooperen correctamente, tomando decisiones consistentes para evitar conflictos o errores. Ya tenemos comunicación, ahora necesitamos averiguar los mecanismos con los cuales vamos a llegar a la consistencia en algún punto.

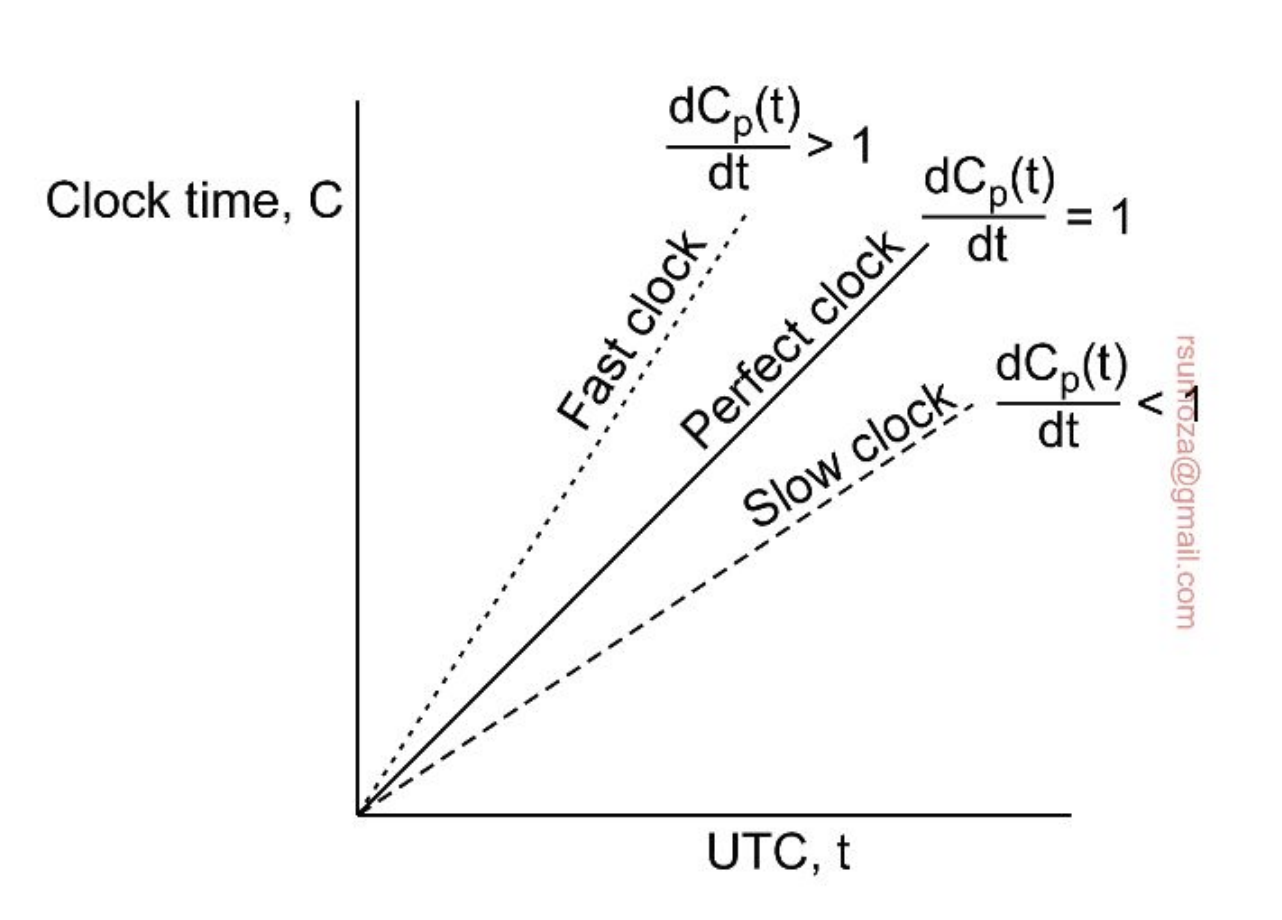

Sincronización de relojes

- Las computadoras tienen varios circuitos dedicados a mantener el tiempo

- Tienen un cuarzo que soporta cierta tensión y oscila

- El circuito mide las oscilaciones del cuarzo y por cada una disminuye un contador predefinido

- Cuando el contador llega a cero, el reloj emite un tick

- Este tick es la unidad más chica de tiempo de la que disponemos.

- El cuarzo para estos relojes oscila a 32768 Hz

- Tienen una propiedad isoeléctrica por la cual se da la siguiente doble identidad:

- Aplico una transformación se genera un pulso eléctrico

- Tienen una propiedad isoeléctrica por la cual se da la siguiente doble identidad:

Los teléfonos coordinan sus relojes con un protocolo de coordinación llamado NTP.

Sincronización

- Es imposible garantizar la coordinación de relojes físicos. Todo reloj tiene cierto sesgo y a lo largo del tiempo tienden a diferir más y más.

- Si yo a 2 relojes en algún momento con algún mecanismo los pongo a la misma hora, en algún momento van a desfasarse.

- Una primera solución a este problema es el Coordinated Universal Time (UTC), que se mantiene con antenas distribuidas a lo largo del planeta, que emiten un pulso por segundo. También existen satélites que emiten este pulso. Tienen una exactitud de +-10ms y +-5ns respectivamente.

- Los satélites tienen mucha menos interferencia.

- Estas antenas y satélites usan relojes atómicos que son mucho más precisos y su sesgo es despreciable.

Precisión y exactitud

- Para lograr precisión entre dos máquinas tenemos que la diferencia de tiempo entre dos máquinas sea menor o igual a un valor específico

- Para mejorar la exactitud tenemos que reducir la diferencia con el tiempo real

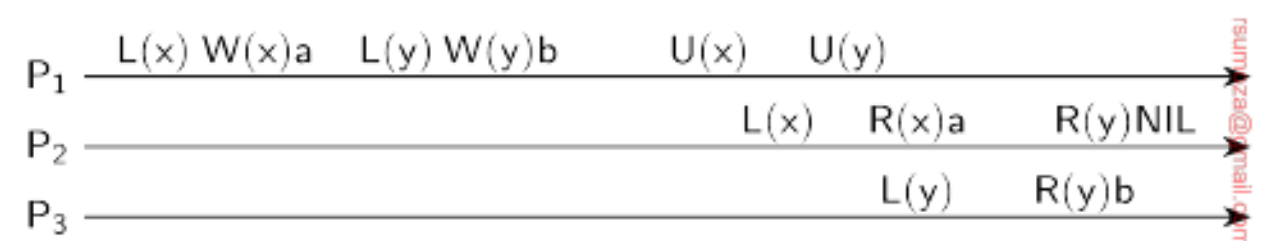

- P y Q son procesos

Mantener una buena precisión entre máquinas es IMPERATIVA para su coordinación, porque basta un desfasaje de un momento/tick/unidad de tiempo para que reviente todo por los aires.

Desviación

- Todos los relojes (de computadora) vienen con una desviación conocida, que suele ser de aproximadamente 31.5 segundos por año.

- Los de mano se suelen desfasar 30 seg por mes.

- Para mantener los relojes sincronizados, necesitamos realizar sincronizaciones de manera periódica

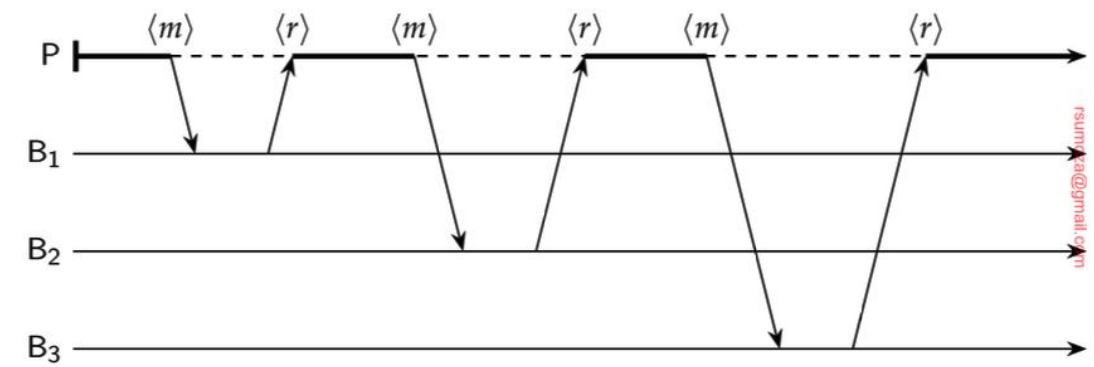

Algoritmos de sincronización

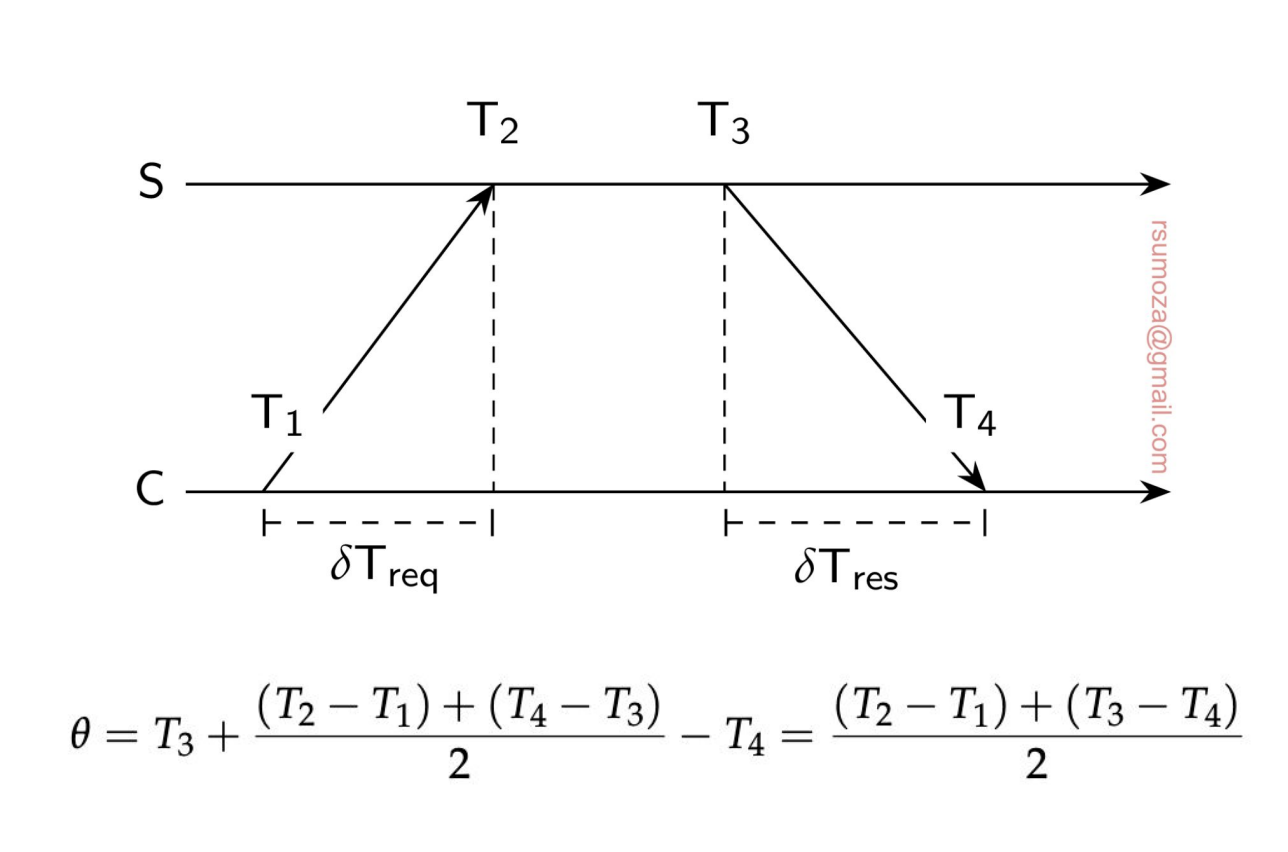

NTP (Network Time Protocol)

El Unix TimeStamp tiene el 0 (el primero de todos) en el 01/01/1970

- Una solución es tener un timeserver que se encarga de decirnos qué hora es.

- Pero como los delays de la red no son despreciables, tenemos que tenerlos en cuenta también de forma de actualizar el reloj con el valor que nos da el server más un offset.

- No es trivial el tiempo que tarda en llegar la response.

- Si el tiempo del server es anterior al actual hay que ralentizar el reloj local

- En NTP particularmente hay un atributo de los relojes que es el estrato, que nos dice qué tan confiable es el reloj.

- El estrato 0 es el reloj en particular (UTC, relojes atómicos). Son lo más exacto que hay

- Este estrato sólo se consigue si tenés hardware que lo permita (es decir, tenés literalmente el reloj en particular)

- El estrato 1 es el servidor que existe alrededor del reloj puntual. Son servidores con mecanismos confiables.

- De acá para abajo (hasta N) baja la confiabilidad y la exactitud.

- El estrato 0 es el reloj en particular (UTC, relojes atómicos). Son lo más exacto que hay

Relojes lógicos

- Si nos interesa llevar un registro con exactitud, una solución como NTP es necesaria.

- Si todos estamos de acuerdo que A pasa antes que B, y B pasa antes que C, ya nos ponemos de acuerdo con cómo fueron las cosas, entonces no hay duda entre los procesos de cuál es el orden correcto

- Nos desacoplamos del tiempo, y nos fijamos específicamente en los eventos y su orden.

- Me importa lo que pasó y en qué orden, no cuándo pasó.

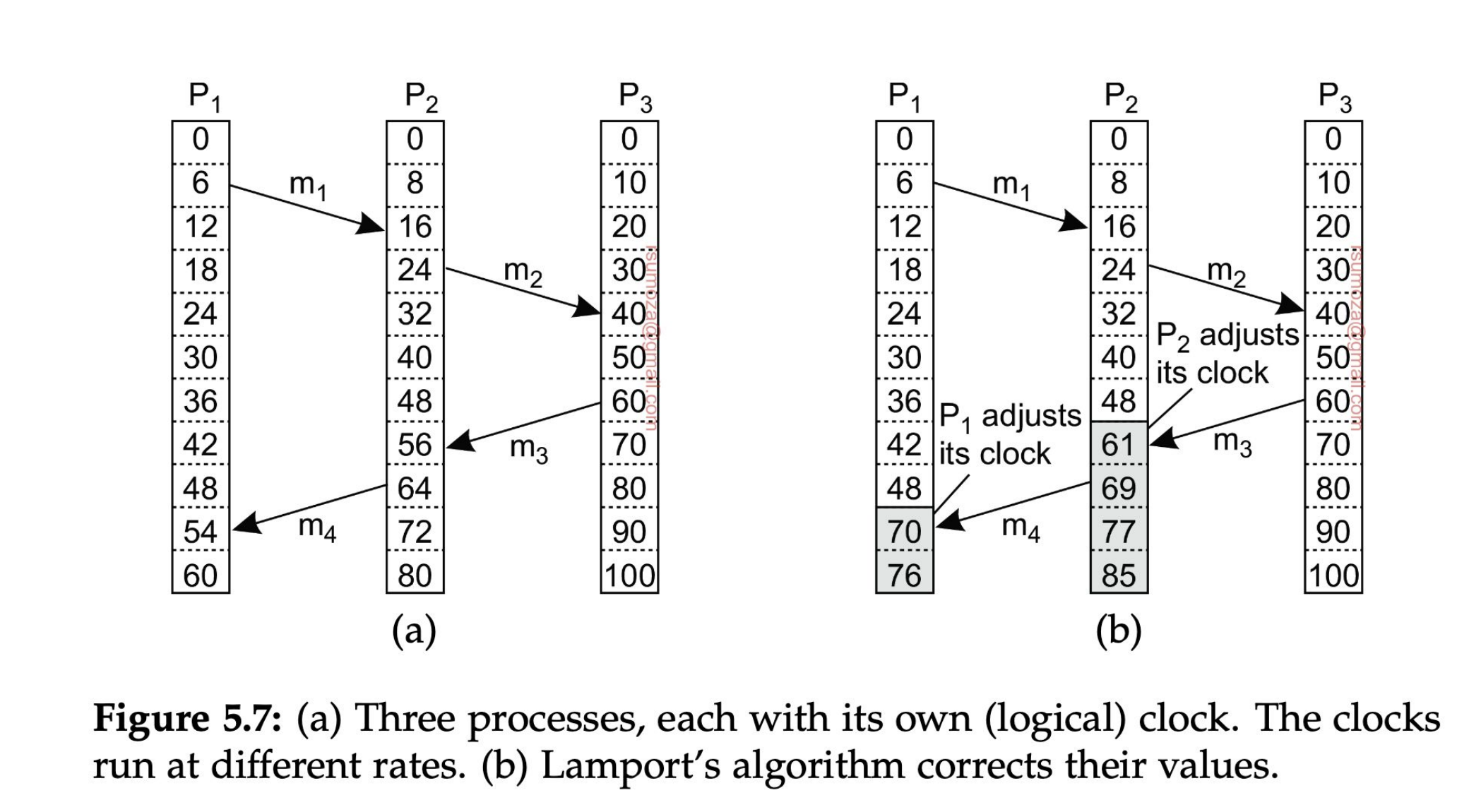

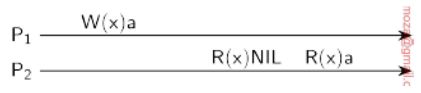

Lamport

- Si dos procesos no interactúan entonces no es necesario que estén coordinados. Su falta de sincronización no es observable, y por ende no genera problemas.

- No me interesa saber en qué orden pasaron las cosas si los procesos no se comunican entre sí.

- Para procesos que interactúan entre sí, Lamport define el happens-before

- a b. A pasa antes que B.

- Hay 2 reglas para el happens-before.

- Si A y B ocurren dentro de un mismo proceso, y A ocurre antes que B, entonces A B es cierto.

- Si A es el evento en el que un proceso envía un mensaje X, y B es el evento en el que otro proceso recibe el mensaje X, entonces A B es cierto. Un mensaje no puede recibirse antes de ser enviado.

- Happens-before es transitivo (A B y B C A C)

- Si ni X Y ni Y X, entonces X e Y son concurrentes.

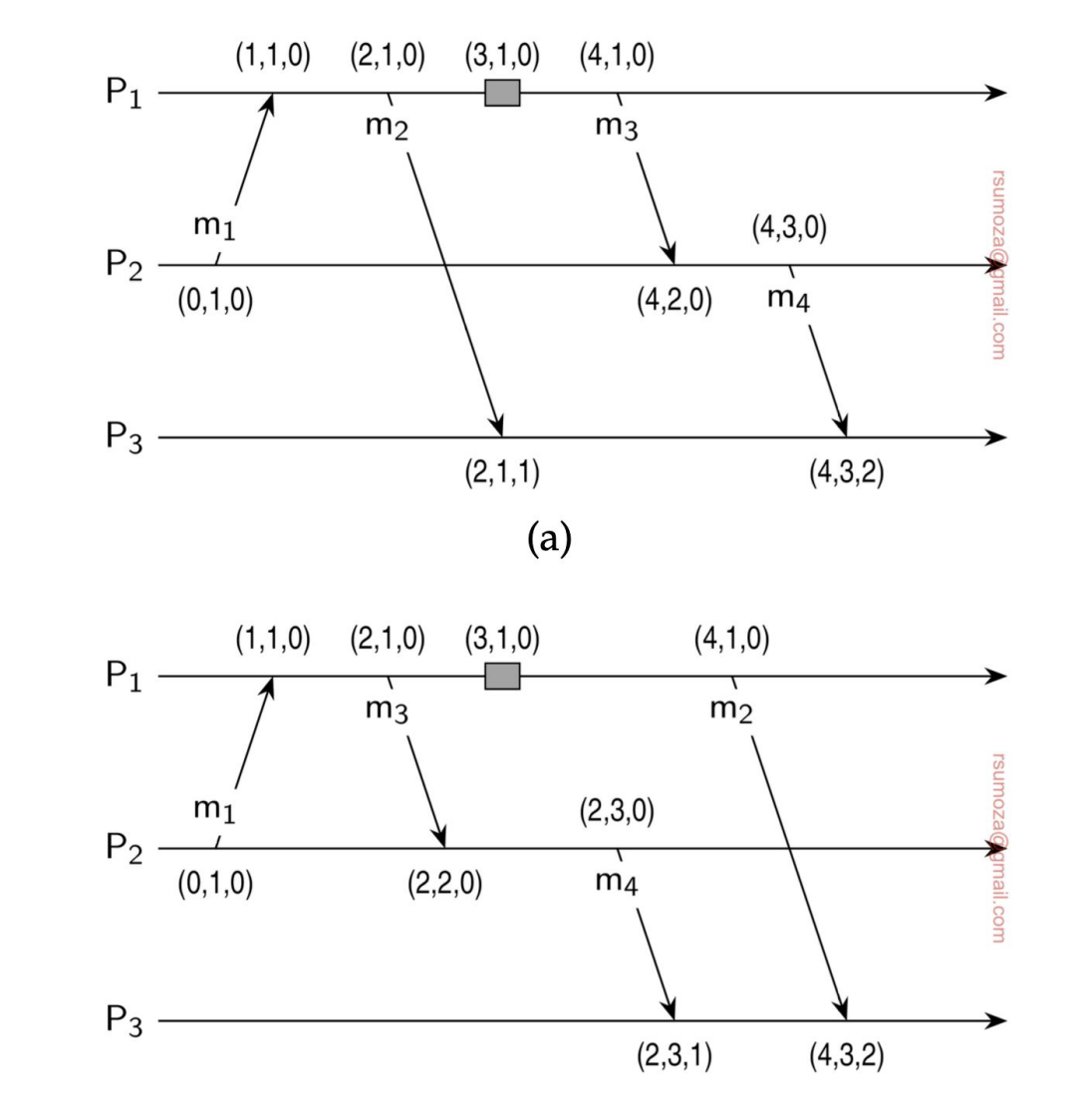

- Fíjense en la figura de la derecha que los relojes se auto-ajustan porque, por definición de Lamport, es imposible recibir un mensaje antes de que se haya enviado.

- Por tanto, los relojes le agregan uno al momento en el que salió el mensaje desde el otro proceso.

Relojes de vectores

Los relojes lógicos tienen un problema subyacente:

- Con los relojes lógicos tenemos mensajes que van y vuelven por el mismo camino, a través del cual puedo rearmar la causalidad.

- ¿Qué pasa cuando tengo muchísimas interacciones/eventos? ¿Y si tenemos eventos que existen no sólo por comunicación sino que son generados por el proceso per se?

- Seguir la causalidad en estos casos es un bodrio, es casi imposible.

- ¿La solución? Un reloj de vectores.

Nosotros sabemos cuántos procesos existen, y por cada posición de ese vector que usamos como reloj tenemos un proceso.

- Cada proceso mantiene un contador de eventos asociados a c/u de los procesos

- Entonces en todo momento cada proceso tiene su versión local del clock de todos los procesos.

- Si llega una nueva versión con valores más altos para cualquier posición en comparación con la local, se actualiza.

Cuando detectamos un conflicto en la sincronización de los relojes de vectores, tenemos que tomar alguna decisión arbitraria. El manejo de conflictos es muy similar al de los VCS (Git, por ejemplo).

Podemos determinar la posible precedencia de 2 eventos en base a la siguiente proposición:

Sea y . Decimos que si para toda posición se cumple que , y además existe al menos una posición tal que . Es decir, todos los elementos pueden ser iguales o mayores, pero al menos uno debe ser estrictamente mayor; si esto no se cumple, no se puede definir una relación de precedencia estricta entre los vectores.

A efectos de este ejemplo, se usan sólo 3 procesos para el reloj, pero en un caso real pueden haber N procesos participando.

Sobre el papel, es muy difícil determinar la causalidad de manera definitiva, por lo que decimos que si A ocurre antes que B, B pudo haber sido causado por A, pero no asegurarlo.

Exclusión mutua

Hay alguien que tiene el control sobre el recurso en este momento, en principio nadie más puede leerlo ni modificarlo.

Podemos empezar a determinar roles en estos casos, para determinar un esquema de jerarquía sobre los recursos.

Solución centralizada

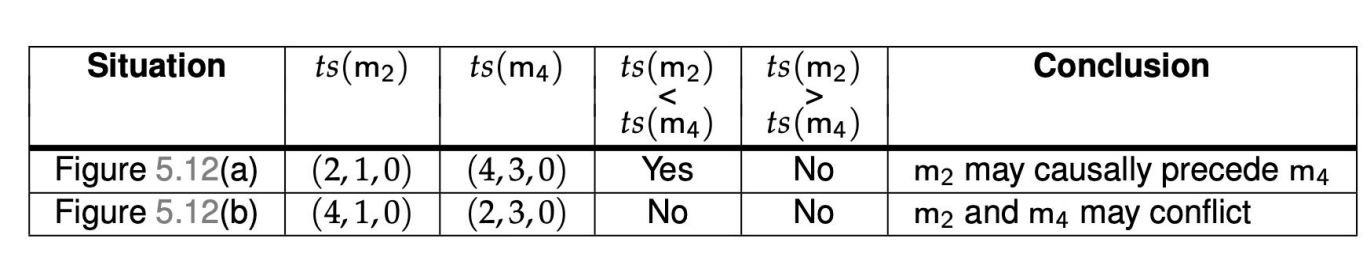

- El coordinador (uno solo) es el que se encarga de proteger/administrar el recurso

- El resto de procesos le piden acceso al recurso.

- Si me dice OK, puedo acceder al recurso

- Si otro proceso quiere acceder al mismo tiempo que otro, no se le responde nada, y se encola.

- Cuando se libere el recurso, se le manda un OK al proceso encolado

Problema subyacente: se genera un SPoF (Single Point of Failure), el cual es el coordinador. Si se muere el coordinador y se quiere recuperar, se puede llegar a perder la Queue, dando lugar a la posibilidad de generar Starvation.

Beneficio: es simple, fácil de entender, administrar, implementar, es sencillo debuggearlo.

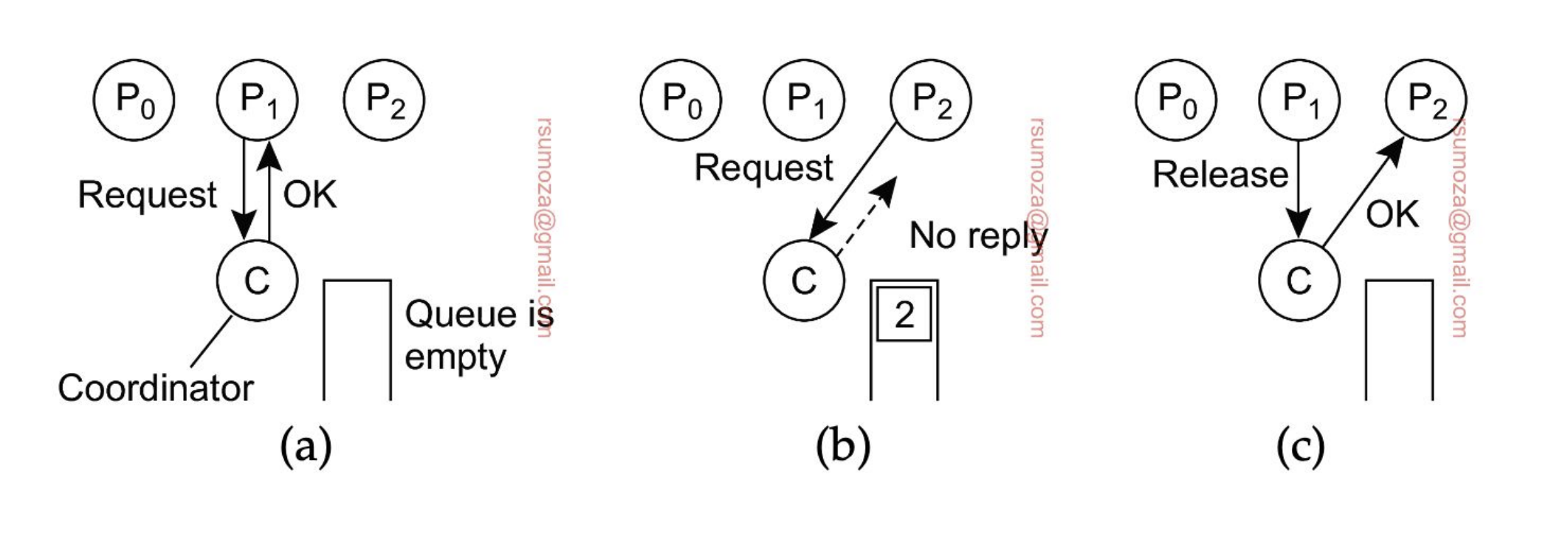

Solución distribuida - Algoritmo de Ricart

El algoritmo de Ricart original consiste en que cuando un nodo necesita acceder a un recurso, le pide permiso a todos los nodos del sistema. Si al menos uno le contesta que no, no opera. El que vemos es una optimización sobre Ricart que hace uso de los timestamp.

- Cuando un proceso quiere acceder a un recurso compartido, envía un mensaje con el nombre del recurso, su ID y su timestamp a todos los nodos (incluso a sí mismo).

- Luego, hay 3 escenarios diferentes para cada nodo:

- Si no quiere acceder a ese recurso devuelve un OK

- Si tiene acceso al recurso, encola el mensaje y no responde nada

- Si quiere acceder al recurso pero todavía no lo hizo, compara su mensaje con el que recibió.

- El que tenga el timestamp más chico, gana. Se basa 100% en el orden en el que se envían los mensajes.

- Si gana el mensaje entrante, devuelve un OK. Si no, encola el mensaje

- Un proceso sólo va a acceder al recurso cuando haya recibido un OK de todos los otros procesos.

¿Cómo se da cuenta si él mismo quiere acceder al recurso? Se fija en la queue interna si tiene un mensaje suyo.

Se puede dar starvation en el caso de que el timestamp de 0 siempre sea más chico que 2 y que los procesos estén desordenados. Esto claramente no va a pasar si usamos una Queue bien estructurada, ya que los procesos se van a ordenar.

Problema: Si uno de los procesos se cae, se bloquean todos.

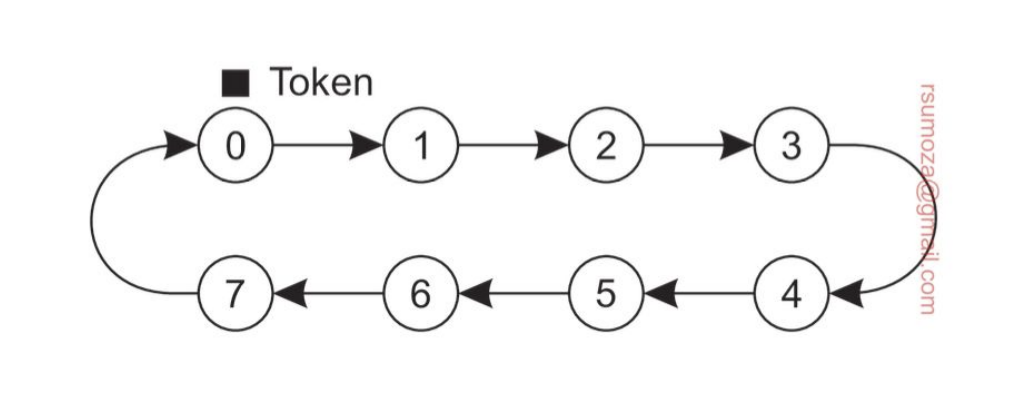

Solución distribuida - Token Ring

Es un anillo en el que se van a organizar los procesos. En principio, un proceso sólo conoce el próximo proceso.

En exclusión mutua, tenemos 2 escenarios:

- Token Based: se usa un token (llave) para habilitar el acceso a recursos

- El token tiene que ser difícil de replicar.

- Permission Based: en algún momento conseguimos el permiso del resto de los nodos. El ejemplo anterior es permission-based

- Cuando el anillo se inicializa, a uno de los procesos se le da el token. Si en ese momento quiere usar el recurso puede hacerlo, y cuando termina pasa el token al siguiente del anillo. Está prohibido que use el token inmediatamente después de haberlo usado.

- Si al recibir el token el proceso no quiere acceder al recurso, simplemente pasa el token

- Problema: Si se pierde el token, ¿cuándo se regenera?

- Puedo tener también problemas de espera en función del tamaño del anillo.

- Beneficio: evitamos starvation porque el token tiene que pasar de mano y, si uso el mismo token puedo evitar el deadlock.

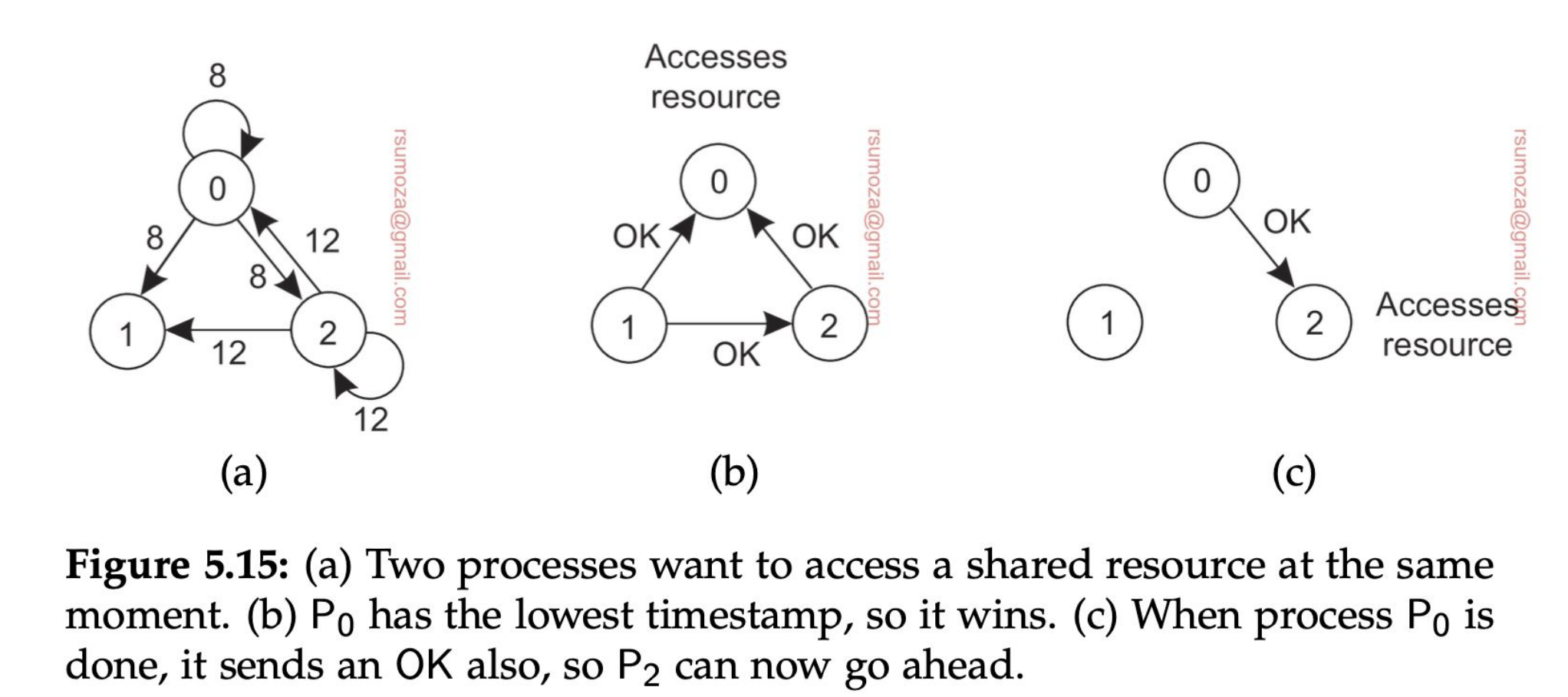

Algoritmos de elección

Los necesitamos para poder entender más adelante cosas que vamos a ver al final de la materia.

- Muchos algoritmos distribuidos requieren la existencia de un nodo coordinador. Pero, ¿cómo nos ponemos de acuerdo en quién es el coordinador?

- Los nodos tienen que tener algún mecanismo para elegir y ponerse de acuerdo en cuál es el coordinador

- Para poder diferenciar a los nodos es necesario que todos tengan un ID único

- En general lo que se hace es designar como coordinador al proceso con ID más grande.

- Además es importante que todos los nodos conozcan al resto de nodos. Lo que pueden no conocer es su estado.

Vamos a usar 2 criterios para elegir un coordinador:

- Todos los nodos se conocen entre sí

- El coordinador es el del ID más grande

- Es ineficiente cuando hablamos a gran escala

Los escenarios en los cuales vamos a usar algoritmos de elección son:

- Cuando se cayó el último coordinador

- Cuando se inicializa el sistema y no está decidido el coordinador

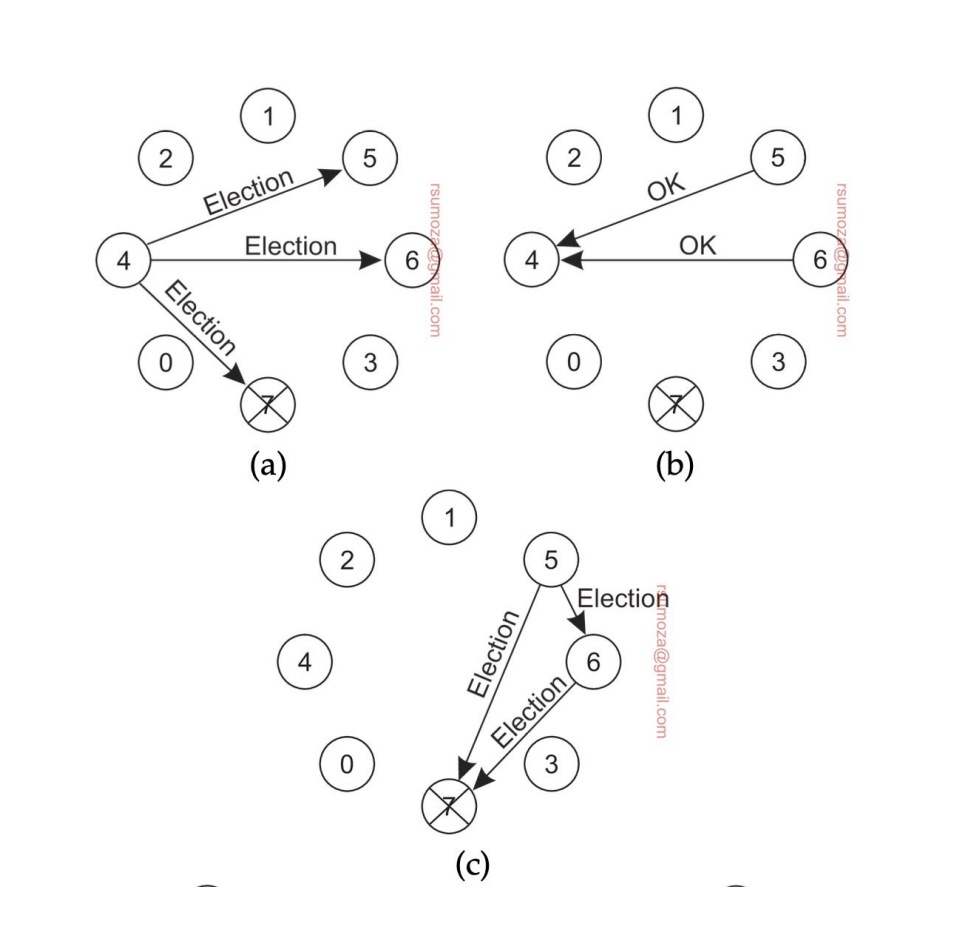

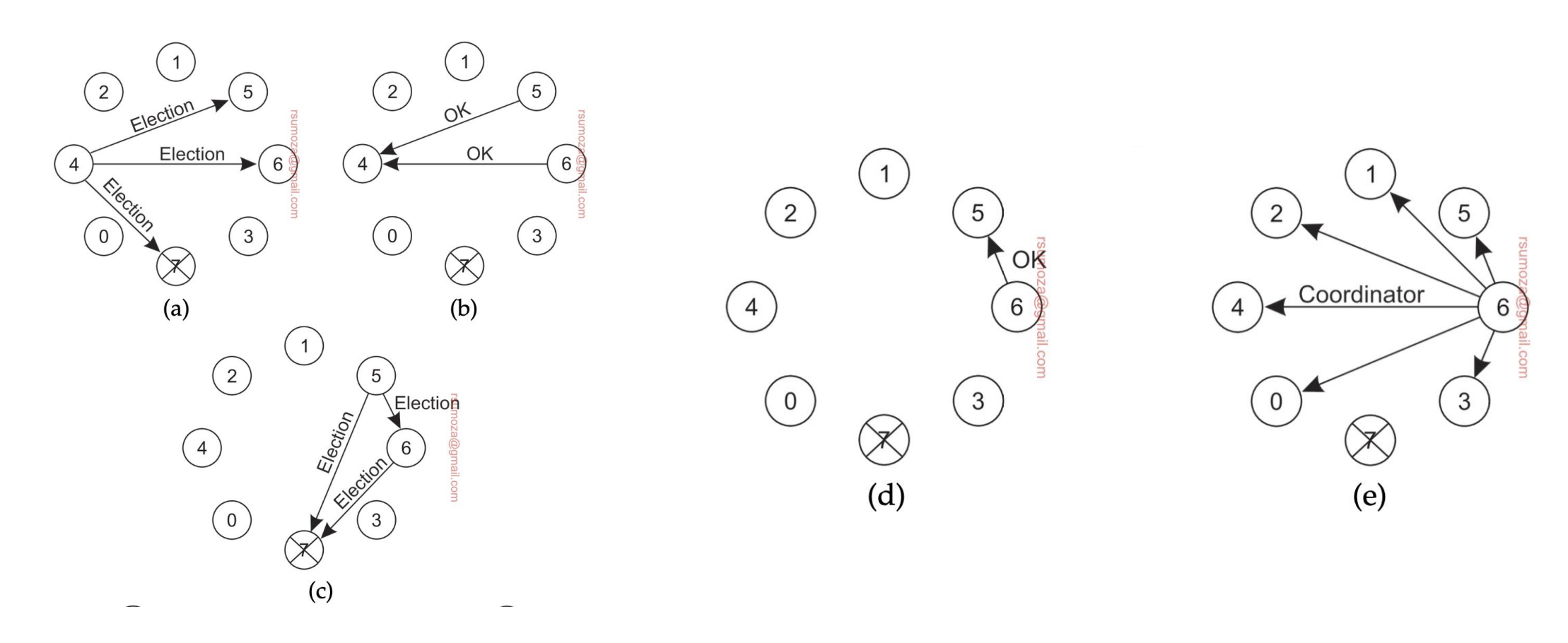

Algoritmo bully

- Cuando un proceso detecta que el coordinador no responde, inicia una elección

- Envía un mensaje de elección a todos los nodos con ID mayor al suyo

- No me interesan los nodos más chicos que el nodo que inicia la votación

- Si ninguno responde, este nodo gana la elección

- Si alguno responde significa que ese nodo se encarga de seguir la elección, repitiendo el mismo proceso.

- Si algún proceso se recupera o se suma al sistema, arranca otra elección

- Si el que aparece es el del ID más grande, le manda un mensaje a todos los nodos diciendo que él es el coordinador.

- Si el que aparece es el más chico, arranca la votación de vuelta.

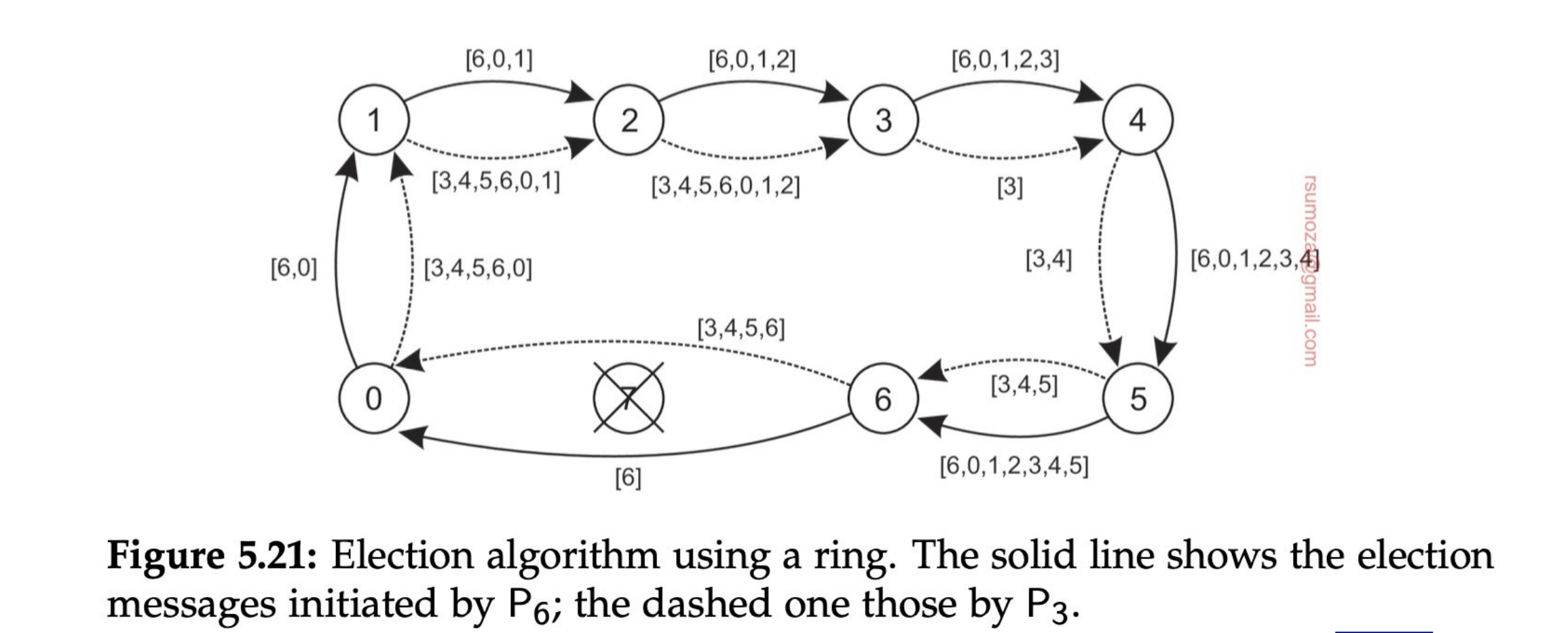

Algoritmo del anillo

Que el sistema esté diseñado como un anillo no implica que la red de elección sea en forma de anillo. Son 2 cosas inherentemente diferentes.

- Los nodos se organizan en una overlay network con forma de anillo.

- Cuando un nodo detecta que el coordinador no está funcionando, empieza una elección enviando un mensaje ELECTION con su ID al próximo proceso.

- Cada proceso suma su ID a la lista, y envía el mensaje al próximo proceso

- Finalmente el proceso que originó la elección recibe una lista con su propio ID. De todos los IDs, se selecciona el más grande, y lo comparte con un mensaje COORDINATOR con el próximo elemento, a lo largo de todo el anillo.

- Si cualquier nodo no responde el mensaje se envía al próximo proceso que esté funcionando del anillo.

Si 2 nodos detectan en simultáneo que se cayó el coordinador y arrancan la elección, el resultado va a ser el mismo, solamente va a haber más pasamanos porque van a haber 2 listas circulando.

Cada nodo que se anota en la lista, por más que sepa que no va a ser el coordinador, se anota para notificarle al resto que está vivo.

Algoritmo de Raft

Es un algoritmo basado en términos. Hay momentos para elecciones. Una elección arranca en el momento A y termina en el momento B, existe una ventana de tiempo.

Ningún nodo tiene ninguna jerarquía, solo se determina por quién pide ser coordinador.

Este algoritmo falla cuando más de un nodo pide ser coordinador.

Sistemas de gran escala - Proof of work

Hay un líder que le dice al resto "la versión real es esta".

- Hashing: toma un input cualquiera y produce una cantidad fija de bits. Calcular un hash debería ser barato computacionalmente. Pero calcular un input al que le corresponda el mismo hash. Y siempre o casi siempre, sin importar cuán mínima sea la diferencia, si dos inputs son diferentes van a producir hashes diferentes.

- Entonces es muy fácil garantizar que cualquier cambio a la blockchain va a generar un hash necesariamente diferente

- Esto hace que modificar la blockchain sin que el resto de los validadores se den cuenta sea prácticamente imposible.

- Cada validador produce un hash para el nodo que está procesando, que se llama digest.

- El desafío es calcular el nonce: un valor que, cuando se combina con el digest y se hashea, produce un valor con una cierta cantidad de ceros consecutivos al principio del hash final.

- El validador que lo encuentre primero pasa a ser líder, pero la probabilidad de encontrar un nonce válido es de

- En general este proceso suele tomar 10 minutos a nivel global

- Un nodo encontró un nonce a nivel global.

- Esto puede ajustarse cambiando la cantidad de ceros que se piden (suelen ser 64 ceros) de forma buscar un balance entre el tiempo que se tarda en calcular y posibles conflictos.

Elecciones en sistemas wireless

- Muchas de las propiedades que asumimos como ciertas en otros escenarios (los mensajes siempre llegan, la topología no cambia, la red es confiable) no son ciertas para sistemas wireless.

- Necesitamos un algoritmo capaz de elegir al mejor nodo

- Para eso, necesitamos un algoritmo que pueda conseguir información de todos los nodos disponibles en ese momento.

Naming

Conceptos básicos

- Los nombres juegan un papel importante en todos los sistemas informáticos

- Se usan comúnmente para compartir recursos, identificar entidades de manera única, hacer referencia a ubicaciones y más.

- Se traduce como "nombramiento" o "designación".

Todos los servicios de Internet necesitan un esquema de direccionamiento para poder ubicar un recurso.

La resolución de nombres se distribuye a través de múltiples nodos.

- Un nombre puede resolver la entidad a la que se refiere

- De esta forma la resolución de nombres permite que un proceso acceda a la entidad nombrada.

- Para resolver nombres, es necesario implementar un sistema de nombres

- La diferencia entre los nombres de los sist. distribuidos y no distribuidos radica en la forma en la que se implementan los sistemas de naming

- Los sistemas distribuidos implementan el sistema de naming de manera distribuida en múltiples máquinas

- En los no distribuidos los nombres están centralizados en un nodo.

Para los fines de esta materia se considerarán 3 tipos de sistemas distribuidos de naming:

- Flat Naming System (Sistema de direccionamiento plano)

- Se suele implementar en redes P2P (punto a punto) porque normalmente incorporan la información de las redes de los nodos vecinos

- Van haciendo un "teléfono descompuesto" basado en preguntar "¿vos tenés este recurso?"

- Ejemplo: BitTorrent.

- No hay un servidor centralizado que tiene todo, sino que la info está distribuida entre nodos.

- Los sistemas están preparados para la desconexión

- Se suele implementar en redes P2P (punto a punto) porque normalmente incorporan la información de las redes de los nodos vecinos

- Structured names (nombres estructurados, como por ejemplo DNS)

- Named Based Routing (enrutamientoi basado en nombres o características)

Pregunta de parcial: ¿DNS se puede aplicar sólo en Internet?

Respuesta: No, se puede aplicar a nivel organizacional y poner nombres puntuales a recursos dentro del dominio de una empresa, por ejemplo.

- Los nombres se usan para designar entidades en un sistema distribuido

- Para operar con una entidad, necesitamos acceder a ella mediante un punto de acceso

- Los puntos de acceso son entidades que se nombran mediante una dirección

- Una entidad puede ofrecer más de un punto de acceso

- Ej: puedo contactarme con Juan a través de su celular o de su teléfono de línea

En un sistema distribuido, un ejemplo típico de un punto de acceso es un host que ejecuta un servidor específico, con su dirección formada por la combinación de, por ejemplo, una dirección IP y un número de puerto.

- Del mismo modo, si una entidad ofrece más de un punto de acceso, no queda claro qué dirección usar como referencia.

Gateway: puerta de enlace o de salida. En este caso me va a permitir redireccionar cada cliente a cada servidor, o avisarme

- Una solución mucho mejor es tener un solo nombre para el servicio web, independientemente de las direcciones de los diferentes servidores web. (De esta manera, va a ser un esquema simplificado)

- Esta variante es independiente de la ubicación (en cuanto a su dirección IP)

Estos ejemplos ilustran que un nombre para una entidad que sea independiente de sus direcciones suele ser mucho más fácil y flexible de usar

Este tipo de nombre se denomina independiente de la ubicación.

Las direcciones y los identificadores.son dos tipos importantes de nombres que se utilizan para propósitos muy diferentes.

Otro tipo importante de nombre es el que está diseñado para ser usado por humanos, también conocidos como nombres amigables para los humanos (como los nombres DNS).

¿Cómo resolvemos nombres e identificadores en direcciones?

Tanenbuam presenta 2 enfoques:

- Mantener una tabla (generalmente distribuida) de pares (nombre, dirección). DNS usa este enfoque

- En el segundo enfoque, un nombre se resuelve enrutando la solicitud gradualmente a la dirección asociada al nombre o incluso directamente a un punto de acceso. Usualmente utilizado en sistemas estructurados de pares (peer-to-peer).

Flat Naming System

En estos sistemas existe un identificador que en principio no tiene mucho significado ni estructura, por lo que necesitamos una forma de rastrear la entidad.

No tienen estructura, lo que implica que necesitamos mecanismos especiales para rastrear la ubicación de dichas entidades.

A menudo, los identificadores son simplemente cadenas de bits aleatorias, a las que nos referimos convenientemente como nombres no estructurados o planos.

No tiene información de cómo llegar al punto de acceso desde la entidad asociada.

Tenemos 2 soluciones para alcanzar una entidad:

- Fordwarding pointers (punteros de difusión)

- Broadcasting

Ambas soluciones son aplicables principalmente sólo a redes de área local.

El router me permite saltar entre redes, pero el switch no. La información queda dentro de la red del switch, a menos que sea un switch de Capa 3.

Broadcast

Difundir el ID (por Broadcast), solicitando a la entidad que devuelva su dirección actual

- Nunca puede escalar más allá de las redes de área local

- Requiere que todos los procesos escuchen las solicitudes de ubicación entrantes

ARP (Address Resolution Protocol)

- Para saber qué dirección MAC está asociada con una dirección IP, hay que hacer broadcast de la consulta "¿quién tiene esta IP?"

Capa de enlace (OSI) maneja direcciones MAC.

arp -d: borra la tabla de direcciones

Forwarding pointers (punteros de reenvío)

Cuando una entidad se mueve, deja atrás un puntero que indica su próxima ubicación.

- La desreferenciación puede ser completamente transparente para los clientes siguiendo la cadena de punteros

- Se debe actualizar la referencia de un cliente al encontrar su ubicación actual

- Problemas de escalabilidad geográfica (para los que se requieren mecanismos de reducción de cadena independientes):

- Las cadenas largas no toleran fallos

- Mayor latencia de red al desreferenciar

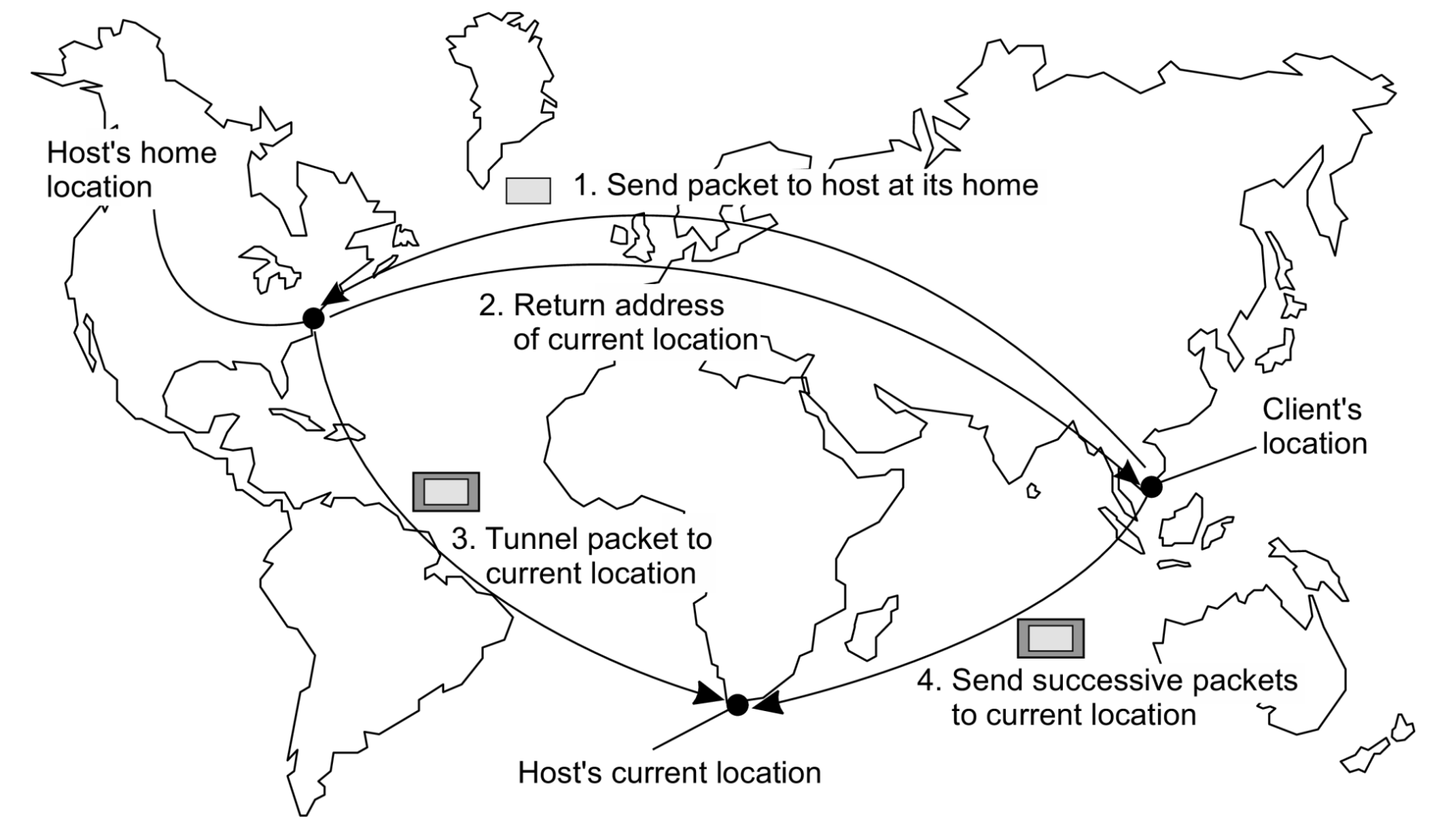

Home based approach (enfoque basado en origen)

Tengo una cierta cantidad de ubicaciones fijas, que de alguna manera reenvían la información.

Las ubicaciones fijas redireccionan las IP en una cierta ubicación de origen, de manera que no tenga que armar cadenas demasiado largas.

- Se realiza un seguimiento de la ubicación actual de una entidad

- El enfoque basado en el origen se usa como mecanismo de respaldo para los servicios de ubicación basados en punteros de reenvío

- Otro ejemplo donde se sigue el enfoque basado en el origen es en IP móvil (para dispositivos móviles). Cada host móvil tiene una dirección IP fija.

- Los datos móviles te permiten conectarte de manera directa con el proveedor de servicios (Movistar, Personal, etc.)

Esquema de un solo nivel: permitir que un home (origen) lleve un registro de dónde se encuentra la entidad

- La dirección de origen (home address) de la entidad registrado en un servicio de nombres

- El origen (home) registra la dirección externa de la entidad.

- El cliente contacta primero con el origen (home) y luego con la ubicación foránea o externa (foreign location).

Problemas

- La dirección particular debe mantenerse durante toda la vida útil de la entidad

- La dirección particular es fija una carga innecesaria si la entidad se muda permanentemente

- Baja escalabilidad geográfica (la entidad puede estar junto al cliente).

Distributed Hash Tables

- Cuando necesito comunicarme con una entidad móvil, el cliente primero debe contactar con su origen, que puede estar en una ubicación completamente distinta a la de la propia entidad.

- Esto provoca un aumento de la latencia de la comunicación.

Cómo resolver un identificador en la dirección de la entidad asociada.

- En la última década se han desarrollado muchos sistemas basados en DHT.

- El sistema Chord (cuerda/anillo) es un representante típico

- Cada miembro del anillo tiene un puntero al siguiente miembro, y una tabla que muestra, en cada miembro,

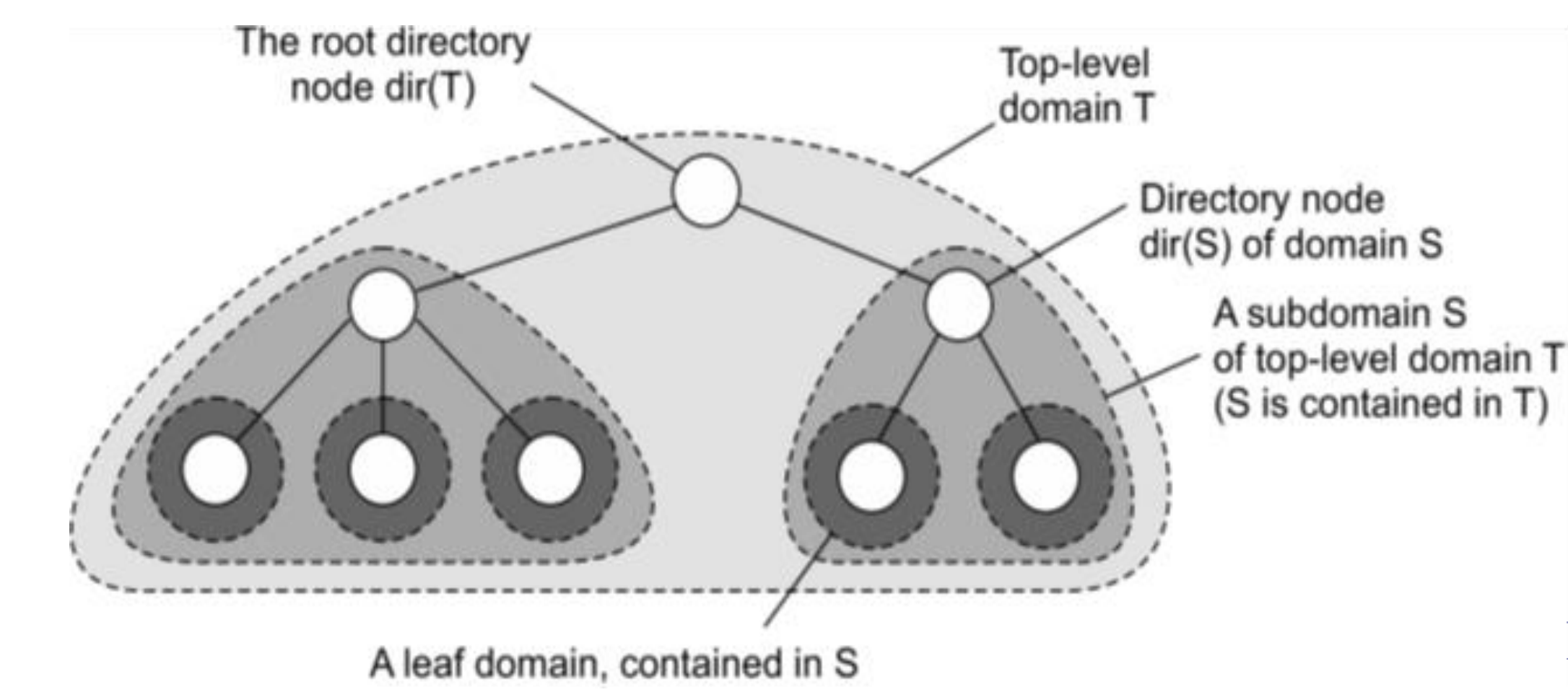

Sistemas de ubicación jerárquica (HLS)

- Construir un árbol de búsqueda a gran escala cuya red subyacente se divide en dominios jerárquicos

- Cada "dominio" está representado por un nodo de directorio independiente

- Tener un espacio de nombres dividido acelera el tiempo de búsqueda.

- Tengo una frecuencia mayor de comunicación en un espacio reducido que en el espacio total.

No confundir con DNS; DNS usa nombres fáciles para el usuario, mientras que HLS sigue manejándose por direcciones IP.

Nomenclatura de HLS

Invariantes:

- La dirección de la entidad E se almacena en un nodo hoja o intermedio

- Los nodos intermedios tienen un punteor a un hijo el subárbol con raíz en el hijo almacena la dirección de la entidad

- La raíz conoce todas las entidades

- Cada nodo tiene un puntero al padre

Almacenamiento de información de una entidad con 2 direcciones en diferentes dominios hoja

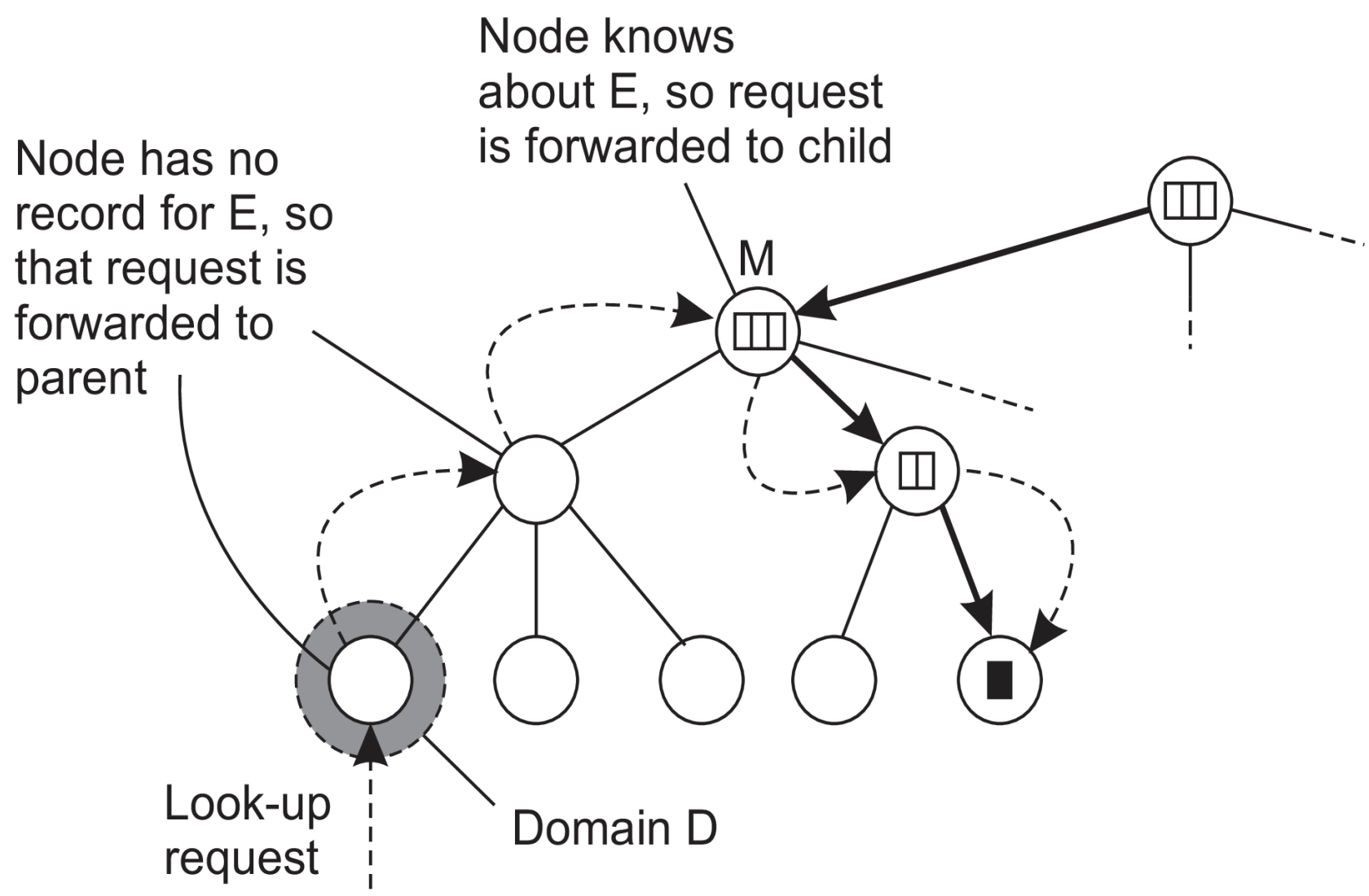

Buscando una ubicación

Principios básicos de HLS

- Iniciar la búsquead en el nodo hoja local

- Si el nodo conoce E sigue el puntero hacia abajo; de lo contrario, sube

- La búsqueda hacia arriba siempre frena en la raíz

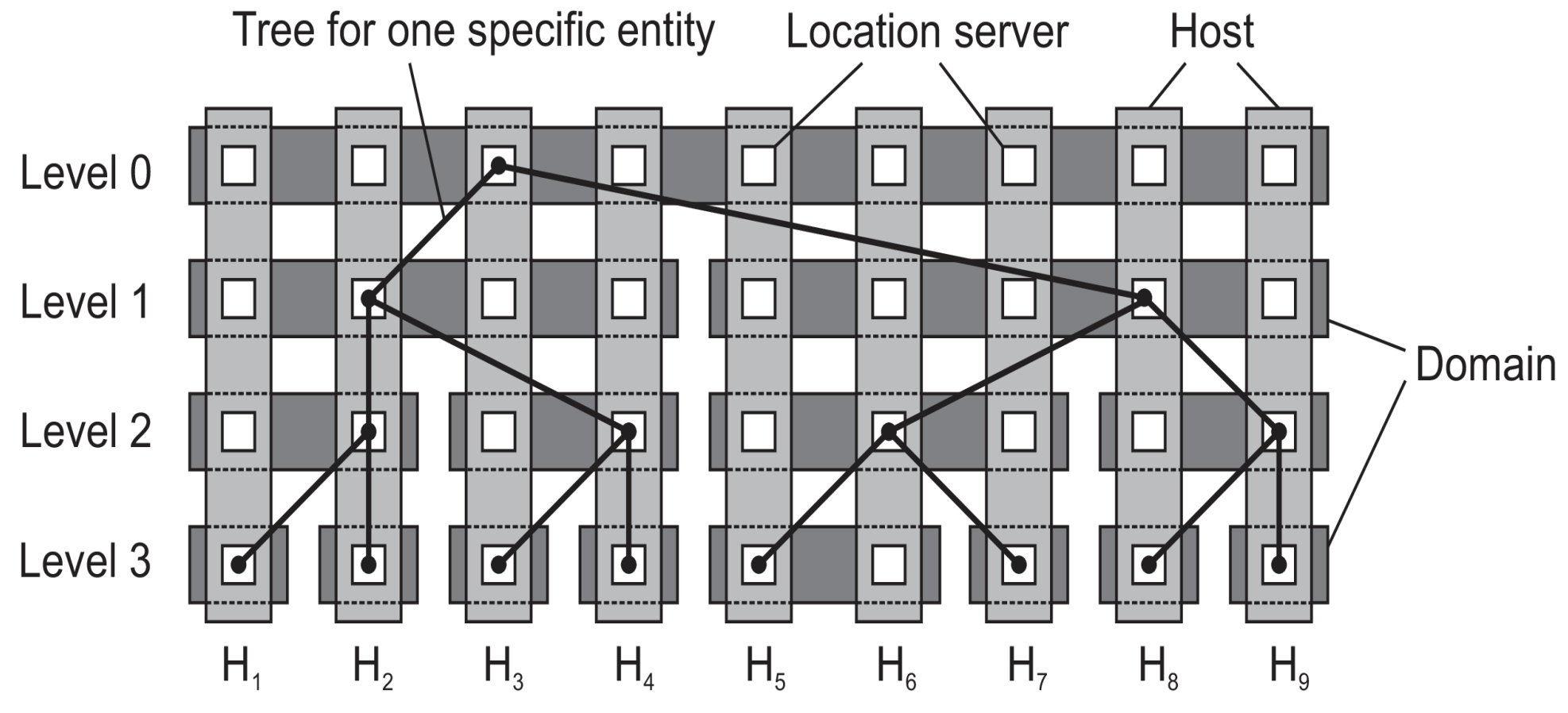

Escalabilidad

- Es importante distinguir entre un diseño lógico y su implementación física

- Veamos como podemos llegar a una implementación altaente escalable de un servicio de ubicación jerárquico

- denota los dominios en el nivel

- Para cada nivel , el conjunto de hosts se divide en subconjuntos, y cada host ejecuta un servidor de ubicación que representa exactamente uno de los dominios de

Principio de distribución de servidores de ubicación lógicos

Seguridad en Flat Naming

- No hay información sobre cómo resolver un nombre a la entidad a la que hace referencia

- Por lo tanto, es necesario confiar completamente en el proceso de resolución de nombres para finalmente acceder a la entidad asociada

- ¿Qué pasa si el esquema de resolución de nombres del cual dependemos no es confiable?

Tenemos 2 opciones:

- Asegurar el proceso de resolución de nombres

- Es el más complicado porque estoy dependiendo de otro sistema

- Asegurar la asociación entre el identificador y la entidad

- Tengo una forma de autenticar a quien se está conectando

- Es un bodrio autenticar a nivel IP porque es un sistema de búsqueda.

- Existen ataques del tipo

ARP Floodingque consisten en inundar la red de solicitudes ARP.

- Existen ataques del tipo

Asegurar la asociación entre el identificador y la entidad

- Ocurre en un nombre autocertificado

- Como principio general, podemos calcular un identificador de una entidad simplemente usando una función hash

-

- Se le da un hash a cada uno, y si coincide el hash con el que se le dio la dirección, está diciendo la verdad

- Es parecido a la dirección de email, que es irreplicable

Structured Naming

Los nombres planos son buenos para las máquinas, pero generalmente no son muy convenientes para el uso humano.

Como alternativa, los sistemas de nombres generalmente admiten nombres estructurados.

- Se componen de nombres simples y legibles para humanos.

- Nombres de archivos y hosts en Internet siguen este enfoque.

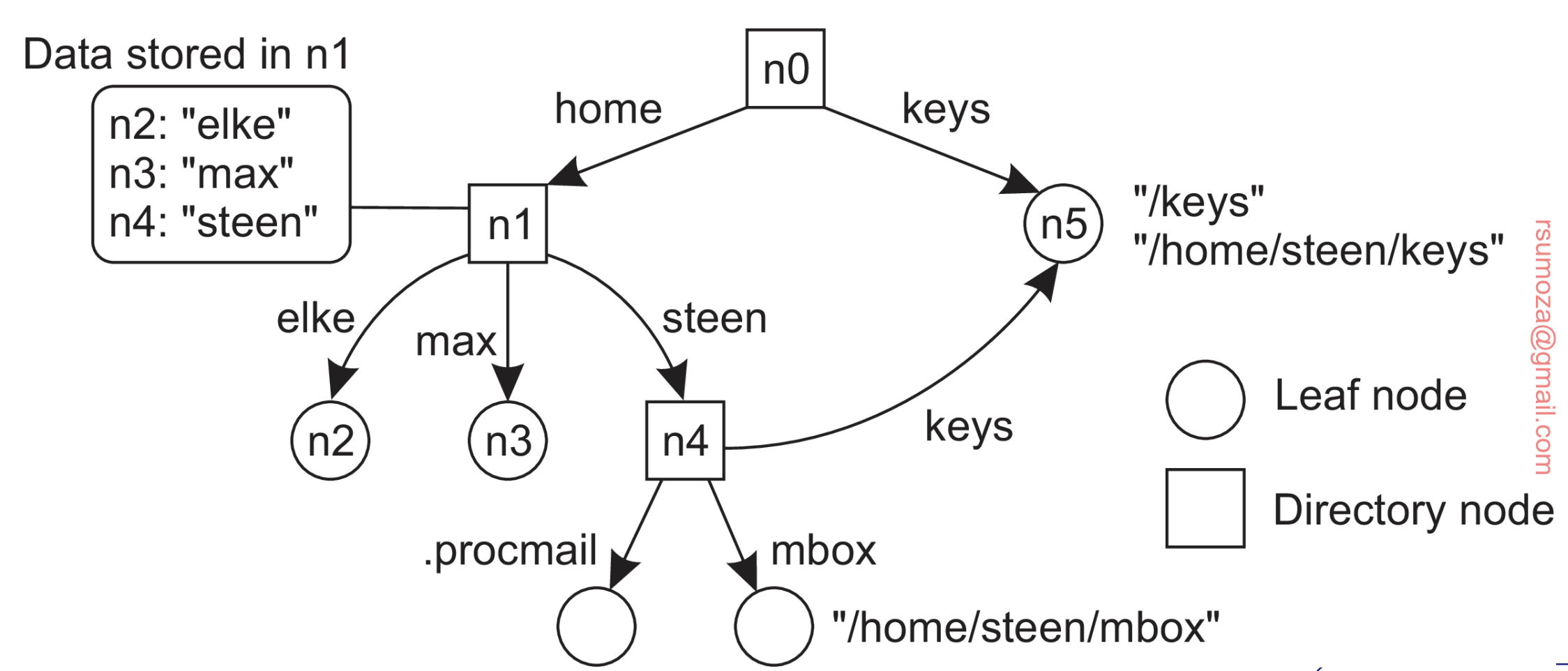

Name Spaces

Se pueden representar como un grafo dirigido y etiquetado con dos tipos de nodos.

- Leaf node (Nodo hoja): Un nodo hoja representa una entidad nombrada y no tiene aristas salientes. Mantiene información representativa de la entidad (ej: dirección).

- Directory node (nodo directorio): tiene varias aristas salientes, cada una etiquetada con un nombre. Cada nodo en un grafo de nombres se considera como otra entidad en un sistema distribuido.

- Un nodo de directorio almacena una tabla en la que una arista de salida se representa como un par (identificador de nodo, etiqueta de arista).

- Dicha tabla se denomina tabla de directorio.

Name Resolution

- Los espacios de nombres ofrecen un mecanismo conveniente para almacenar y recuperar información sobre entidades a través de nombres.

- De manera más general, dado un nombre de ruta (route name), debería ser posible buscar cualquier información almacenada en el nodo al que hace referencia ese nombre.

- El proceso de buscar un nombre se llama resolución de nombres.

Se reduce a "En base a un nombre, dame una IP".

Mecanismo de clausura

- Sólo puede tener lugar si sabemos cómo y dónde empezar

- Saber cómo y dónde comenzar la resolución de nombres generalmente se conoce como mecanismo de clausura.

- Un mecanismo de clausura se ocupa de seleccionar el nodo inicial en un espacio de nombres, desde el cual debe comenzar la resolución de nombres.

Implementación de un espacio de nombres

- Un espacio de nombres forma el corazón de un servicio de nombres

- Es un servicio que permite a los uusarios y procesos agregar, eliminar y buscar nombres

- Un servicio de nombres se implementa mediante servidores de nombres

- En una LAN, se puede implementar un servicio de nombres con un sólo DNS

- En una WAN, se distribuye a través de varios DNS

- Acá los espacios de nombres usualmente se organizan jerárquicamente

- Asumir que el espacio de nombres tiene un solo nodo raíz

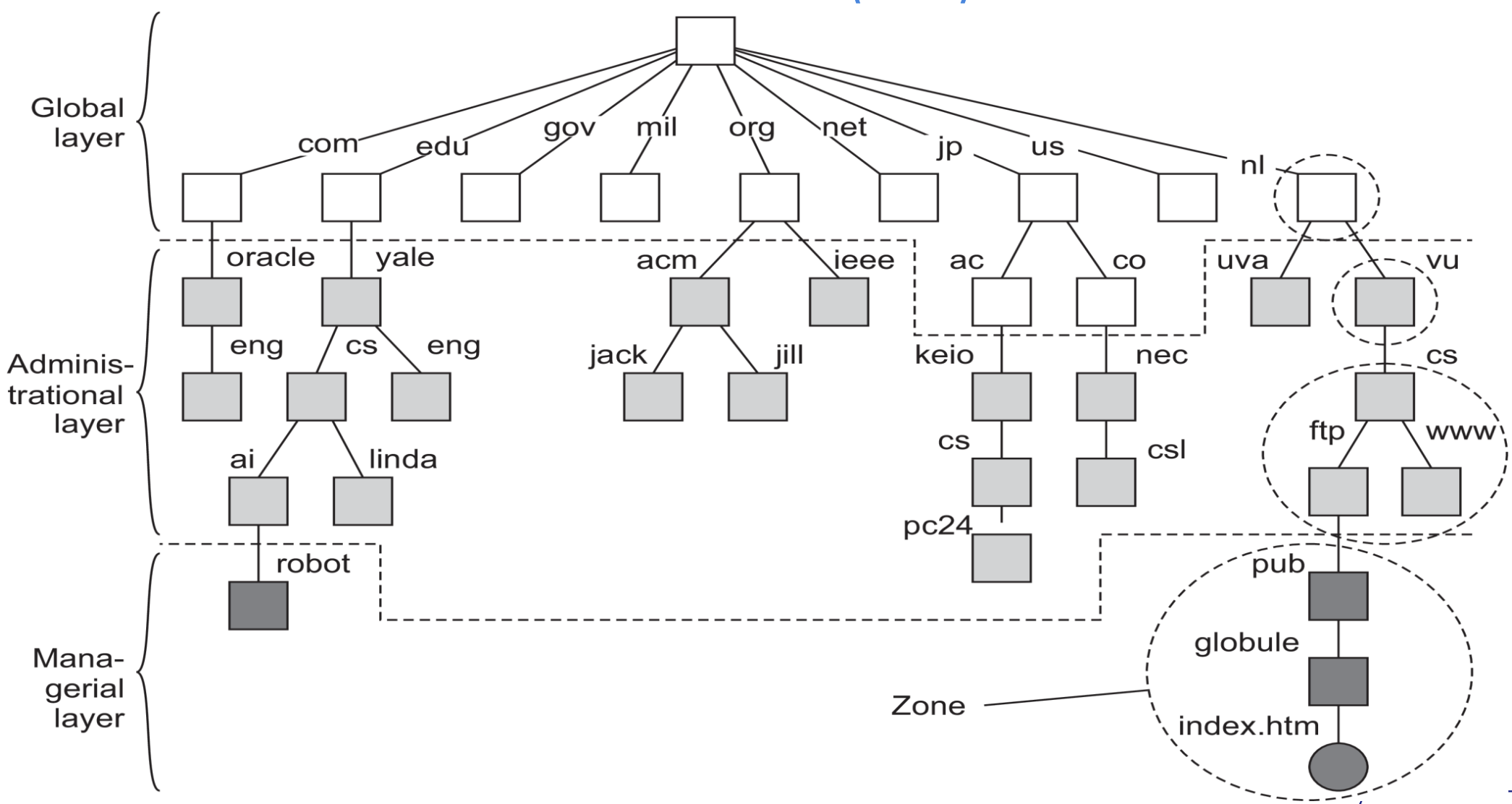

- Para implementar eficazmente dicho espacio de nombres, es conveniente dividirlo en capas lógicas

- Capa global: formada por nodos de nivel más alto

- Comprende el nodo raíz y otros nodos de directorio lógicamente cercano s ala raíz, es decir, sus hijos directos

- Los nodos representan organizaciones o grupos de ellas

- Se me caen estos y se me cae todo

- Capa administrativa: formada por nodos de directorio que, en conjunto, se gestionan dentro de una única organización. (Ej: la universidad y sus departamentos)

- Capa de dirección (Managerial layer): consta de nodos que suelen cambiar periódicamente. (Ej: nodos host, directorios y archivos)

- Capa global: formada por nodos de nivel más alto

DNS

- Usa el sistema de distribución por capas que mencionamos antes

- Es el sistema de resolución de nombres que usa actualmente internet

- DNS se usa para buscar direcciones IP de hosts y servidores de mail

- El namespace de DNS está organizado jerárquicamente como un árbol.

- Los subárboles son los dominios

- La ruta a su nodo raíz es el nombre de dominio

- La resolución de nombres se distribuye a través de varios servidores de dominio o "DNS servers"

- Para resolver un nombre, se comienza a leer desde adelante hacia atrás.

En esencia, el DNS namespace se puede dividir en una capa global y una administrativa:

Nota: la capa de dirección (managerial layer) no es gestionada por el sistema DNS, por no ser formalmente parte de este sistema.

- Cada zona se implementa mediante un servidor de nombres, que prácticamente siempre se replica para garantizar la disponibilidad.

- Una base de datos DNS se implementa como una (pequeña) colección de archivos

- El más importante contiene todos los registros de recursos de todos los nodos en una zona particular.

- Este enfoque permite identificar los nodos de forma sencilla a través de su nombre de dominio

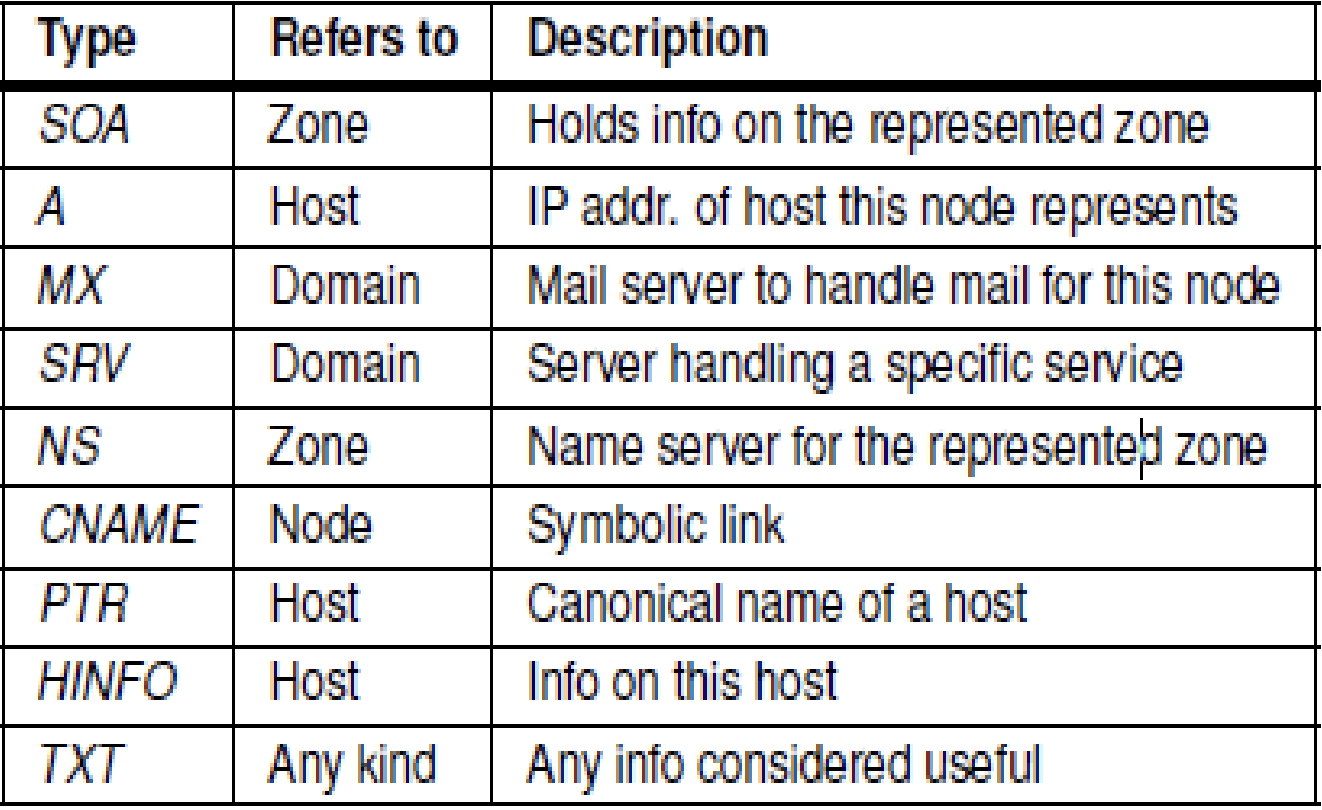

El contenido de un nodo está formado por una colección de registros de recursos.

Los más comunes para cada nodo son:

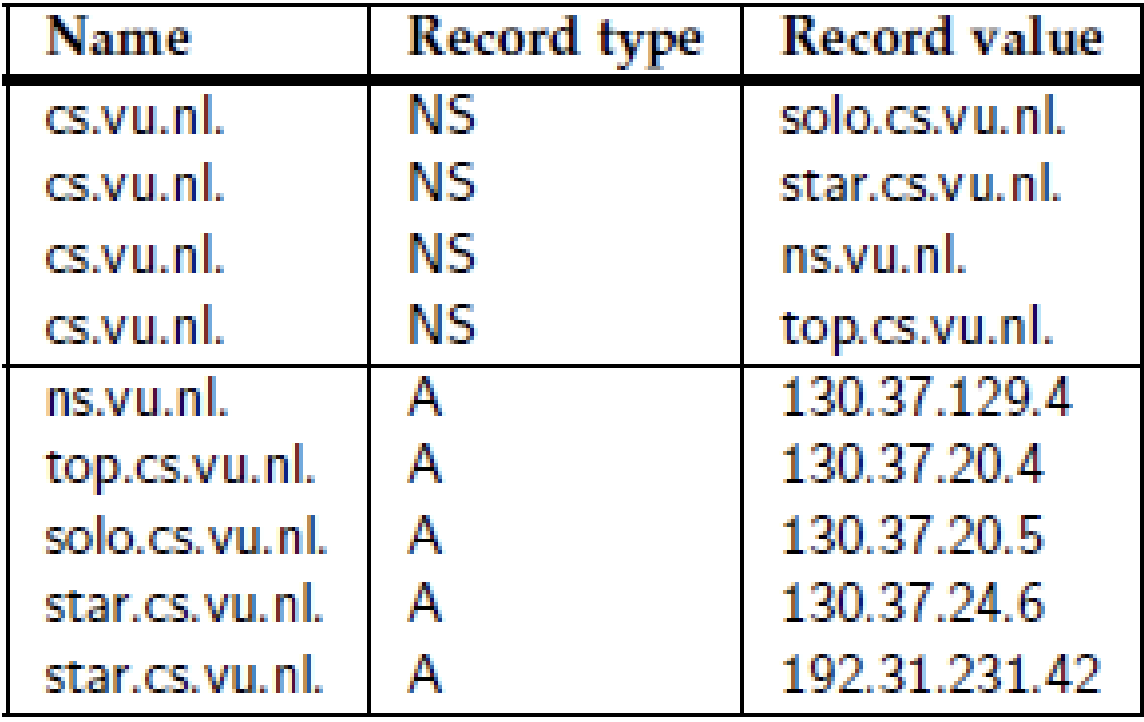

Al resolver un nombre para un nodo que se encuentra en el dominio cs.vu.nl, la resolución del nombre continuará en un punto determinado leyendo la base de datos DNS almacenada por el servidor de nombres para el dominio cs.vu.nl.

Attribute-based Naming

- Los nombres planos y estructurados generalmente proporcionan una forma única e independiente de la ubicación para referirse a las entidades.

- Los nombres estructurados se han diseñado en parte para proporcionar una forma amigable para los humanos de nombrar entidades.

- En particular, a medida que se dispone de más información, se vuelve importante buscar entidades de manera efectiva.

- Este enfoque requiere que el usuario pueda proporcionar simplemente una descripción de lo que está buscando.

- Entre las formas en que se puede proveer descripciones, una forma popular en sistemas distribuidos es describir una entidad en términos de pares (atributo, valor).

- Generalmente se conoce como “attribute-based naming” (nombramiento basado en atributos).

- En este enfoque, se asume que una entidad tiene una colección de atributos asociada.

- Cada atributo dice algo acerca de la entidad.

Servicios de directorio

- Los sistemas de nombres basados en atributos también se conocen como servicios de directorio.

- Con los servicios de directorio, las entidades tienen un conjunto de atributos asociados que se pueden utilizar para realizar búsquedas.

- Para casos simples, por ejemplo, en un sistema de correo electrónico, los mensajes se pueden etiquetar con atributos para el remitente, el destinatario, el asunto, etc.

- Para casos más complejos, un ejemplo son determinados filtros de email.

Desventajas

- En la mayoría de los casos, el diseño de atributos debe realizarse manualmente.

- En la práctica, establecer valores de manera consistente por parte de un grupo diverso de personas es un problema en sí mismo. Por ejemplo, búsquedas en bases de datos de música y vídeo en Internet.

- Para aliviar algunos de estos problemas, se han llevado a cabo investigaciones para unificar las formas en que se pueden describir los recursos

RDF

- Un desarrollo relevante es Resource Description Framework (RDF).

- Fundamental para el modelo RDF es que los recursos se describen como tripletes que constan de un sujeto, un predicado y un objeto.

- Por ejemplo, (Persona, nombre, Alicia) describe un recurso denominado Persona cuyo nombre es Alicia.

- En RDF, cada sujeto, predicado u objeto puede ser un recurso en sí mismo

- Esto significa que Alice puede implementarse como una referencia a un archivo que puede recuperarse posteriormente.