Resumen de Programación Concurrente

Esta página, creada con mdbook, recopila las explicaciones y apuntes de los conceptos clave vistos en la materia de Programación Concurrente. A continuación se listan los temas principales. También puedes consultar ejemplos de código en la Carpeta de Práctica, donde encontrarás implementaciones y ejercicios resueltos.

Temas vistos

-

Thread Programming

Introducción a la creación y manejo de hilos (threads), su ciclo de vida, sincronización básica y comunicación entre hilos. -

Parallelism

Estrategias para dividir un problema en subproblemas que puedan ejecutarse en paralelo y aprovechar varios núcleos de CPU. -

Mutual Exclusion

Exclusión mutua para evitar condiciones de carrera: secciones críticas y protocolos básicos como test-and-set. -

Concurrency Abstractions

Mecanismos de más alto nivel para coordinar hilos:- Locks

Cerraduras simples para proteger secciones críticas. - Reader‐Writer Locks

Locks que permiten múltiples lectores simultáneos o un único escritor. - Semaphores

Contadores sincronizados que controlan el acceso a recursos compartidos. - Condition Variables

Variables de condición que permiten a un hilo esperar hasta que se cumpla cierta condición, liberando antes el mutex. - Monitors

Abstracción que combina mutex y condition variables en un solo bloque para proteger datos compartidos. - Messages

Comunicación mediante envío y recepción de mensajes entre hilos, evitando acceso directo a variables compartidas.

- Locks

-

Mutex Implementation

Ejemplos de implementación de mutex en bajo nivel usando operaciones atómicas (test-and-set,compare-and-swap). -

Non Blocking Algorithms

Algoritmos lock-free y wait-free: pilas y colas no bloqueantes, contadores atómicos y estructuras de datos concurrentes sin mutex. -

Asynchronicity

Programación asíncrona con corutinas (en Kotlin):suspend fun,async/awaitFutures- Timeouts y manejo de errores

-

Actors (en Scala)

Modelo de actores usandoAkka: cada actor mantiene su propio estado y coordina con otros mediante mensajes, evitando la necesidad de memoria compartida.

Ejemplos de código en la Carpeta de Práctica

Para ver implementaciones concretas y ejercicios resueltos en cada uno de los temas anteriores, visita la siguiente ruta dentro de este sitio:

Allí encontrarás carpetas organizadas por tema con el código fuente y las explicaciones correspondientes.

Introducción

Definición

La programación concurrente es un paradigma en el desarrollo de software que permite ejecutar múltiples tareas o procesos simultáneamente, ya sea mediante una ejecución paralela real (como en sistemas multicore o multiprocesador) o intercalando tareas de manera que parezca que se ejecutan al mismo tiempo.

Nota: Es importante diferenciar un sistema multicore de uno multiprocesador, siendo el primero un sistema que tiene múltiples núcleos de procesamiento en un solo chip, mientras que el segundo tiene múltiples chips, cada uno con su propio núcleo.

En ambos casos, la programación concurrente permite aprovechar al máximo los recursos del sistema y mejorar el rendimiento de las aplicaciones.

Todo esto de teoría va a ser un bodrio, va a estar mucho más simplificada la práctica

¿Por qué surge?

- La necesidad de mejorar el rendimiento y la eficiencia de los sistemas informáticos.

- La mayoría de los programas y sistemas eran single-threaded, por lo que había que reducir tiempos de ejecución.

Previo a hablar de programación concurrente, es importante entender el concepto de multiprogramming.

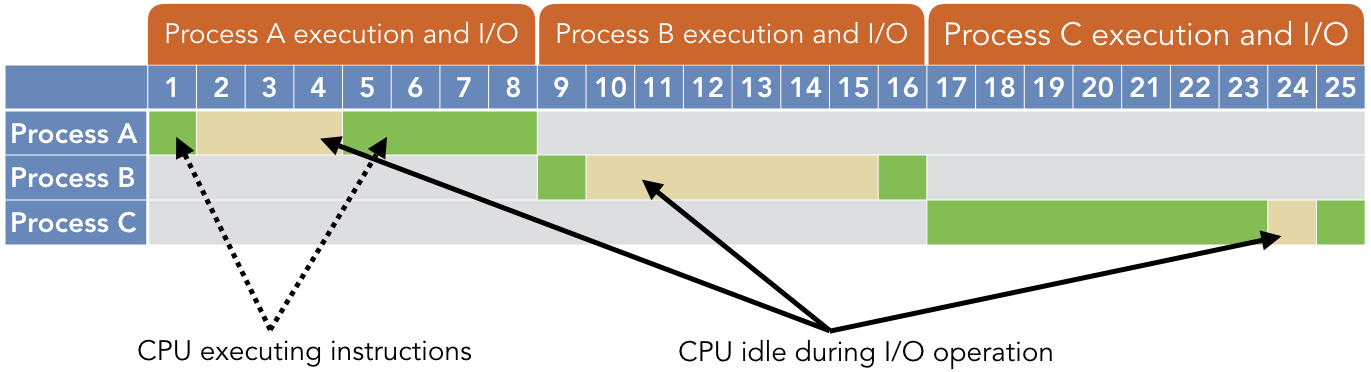

Multiprogramming

- Permite que varios programas se carguen en memoria y se ejecuten de manera concurrente.

- El sistema operativo gestiona la ejecución de los programas, asignando tiempo de CPU a cada uno de ellos.

- Gestiona el tiempo de ejecución de cada programa con tal de que la CPU siempre esté ocupada.

Sistemas Operativos y Time-Sharing

- Time-sharing: una extensión lógica de multiprogramación.

- El tiempo del procesador se comparte entre varios usuarios al mismo tiempo

- Se crea la ilusión de una máquina rápida y dedicada para cada usuario

¿Por qué aplicamos programación concurrente?

- Uso de recursos: uso eficiente del tiempo de inactividad durante operaciones de entrada/salida.

- Equidad: compartición equitativa de recursos entre múltiples usuarios o programas.

- Conveniencia: facilita la gestión de múltiples tareas o procesos.

Scheduling

Cooperativo

Las tareas ceden voluntariamente el control de la CPU, permitiendo que otras tareas se ejecuten.

Características Clave

-

Control de Tarea: Las tareas controlan su propia cesión de la CPU.

-

Cesión: Una tarea cede la CPU cuando está inactiva o cuando decide permitir que otras tareas se ejecuten.

-

Ventajas: Simplicidad, baja sobrecarga, utilización predecible de recursos.

-

Desafíos:

-

Depende de que las tareas se comporten correctamente.

-

Una sola tarea mal comportada puede acaparar la CPU, afectando la capacidad de respuesta del sistema.

-

Casos de Uso Ideales

-

Entornos donde las tareas pueden ser confiables para ceder regularmente.

-

Sistemas que priorizan la simplicidad sobre la eficiencia del multitarea.

Preventivo

El sistema operativo controla la ejecución de las tareas, interrumpiendo y reanudándolas por la fuerza según sea necesario para garantizar una asignación justa y eficiente de recursos.

Características Clave

-

Controlado por SO: El SO decide cuándo una tarea debe ceder la CPU.

-

Partición de Tiempo: Las tareas tienen porciones de tiempo de CPU y son preemptadas cuando las exceden.

-

Ventajas: Mejor capacidad de respuesta, equidad, mejor manejo de tiempo real.

-

Desafíos:

-

Mayor complejidad en la implementación.

-

Potencial para contención de recursos y sobrecarga asociada.

-

Casos de Uso Ideales

-

Sistemas operativos de propósito general.

-

Entornos donde las tareas no pueden ser confiables para ceder regularmente.

-

Sistemas de tiempo real que necesitan tiempos de respuesta garantizados.

Cambio de Contexto

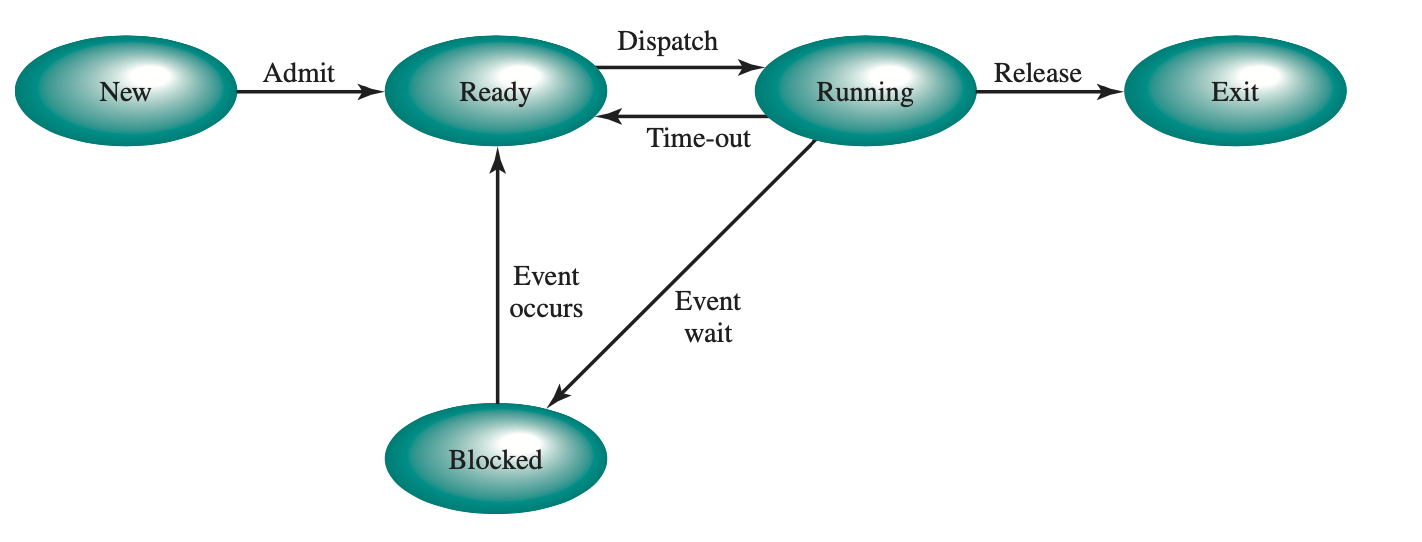

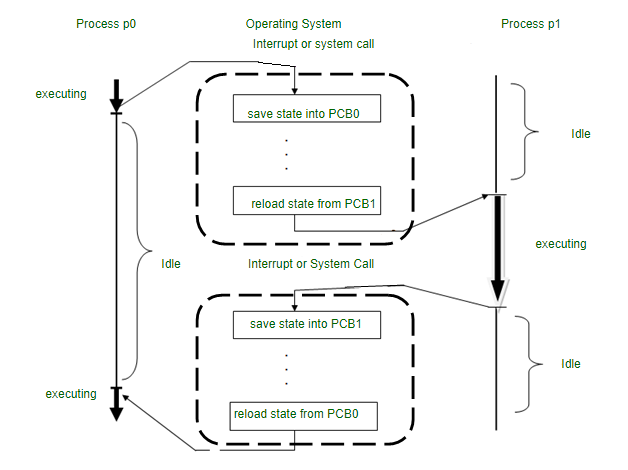

- El proceso de guardar el estado de una tarea actualmente en ejecución y cargar el estado de otra tarea.

¿Qué guarda como estado?

- Program Counter: dirección de la siguiente instrucción

- Registros de la CPU en ese momento

- Stack: variables locales, parámetros de funciones, y direcciones de retorno

- Información de manejo de memoria y otros.

Concurrencia vs Paralelismo vs Interleaving

Concurrencia

- La concurrencia se refiere a la capacidad de un sistema para gestionar múltiples tareas u operaciones al mismo tiempo.

- No significa necesariamente que estas operaciones se estén ejecutando simultáneamente.

- En los sistemas concurrentes, diferentes partes de una tarea o múltiples tareas pueden estar en progreso al mismo tiempo, pero no necesariamente tienen que estar ejecutándose en el mismo momento exacto.

La concurrencia trata sobre la estructura.

Paralelismo

- El paralelismo se refiere a la ejecución de múltiples tareas o procesos simultáneamente.

- Esto requiere hardware con múltiples unidades de procesamiento, como procesadores multi-núcleo.

- En los sistemas paralelos, las tareas se ejecutan literalmente al mismo tiempo, como líneas de ensamblaje paralelas en una fábrica trabajando simultáneamente.

El paralelismo trata sobre la ejecución.

Interleaving / Intercalado

Una técnica para alternar rápidamente entre tareas, ejecutándolas en pequeños fragmentos.

Características clave

- Simula el paralelismo.

- Enfoque de compartición de tiempo: el tiempo de CPU se divide entre múltiples procesos en sucesión rápida.

- Eficiencia: proporciona una utilización eficiente de la CPU al reducir el tiempo de inactividad durante las tareas, como las operaciones de entrada/salida.

- Ejemplo: un chef que prepara múltiples platos alternando entre ellos, en lugar de cocinar cada uno de principio a fin.

Contraste con Overlapping

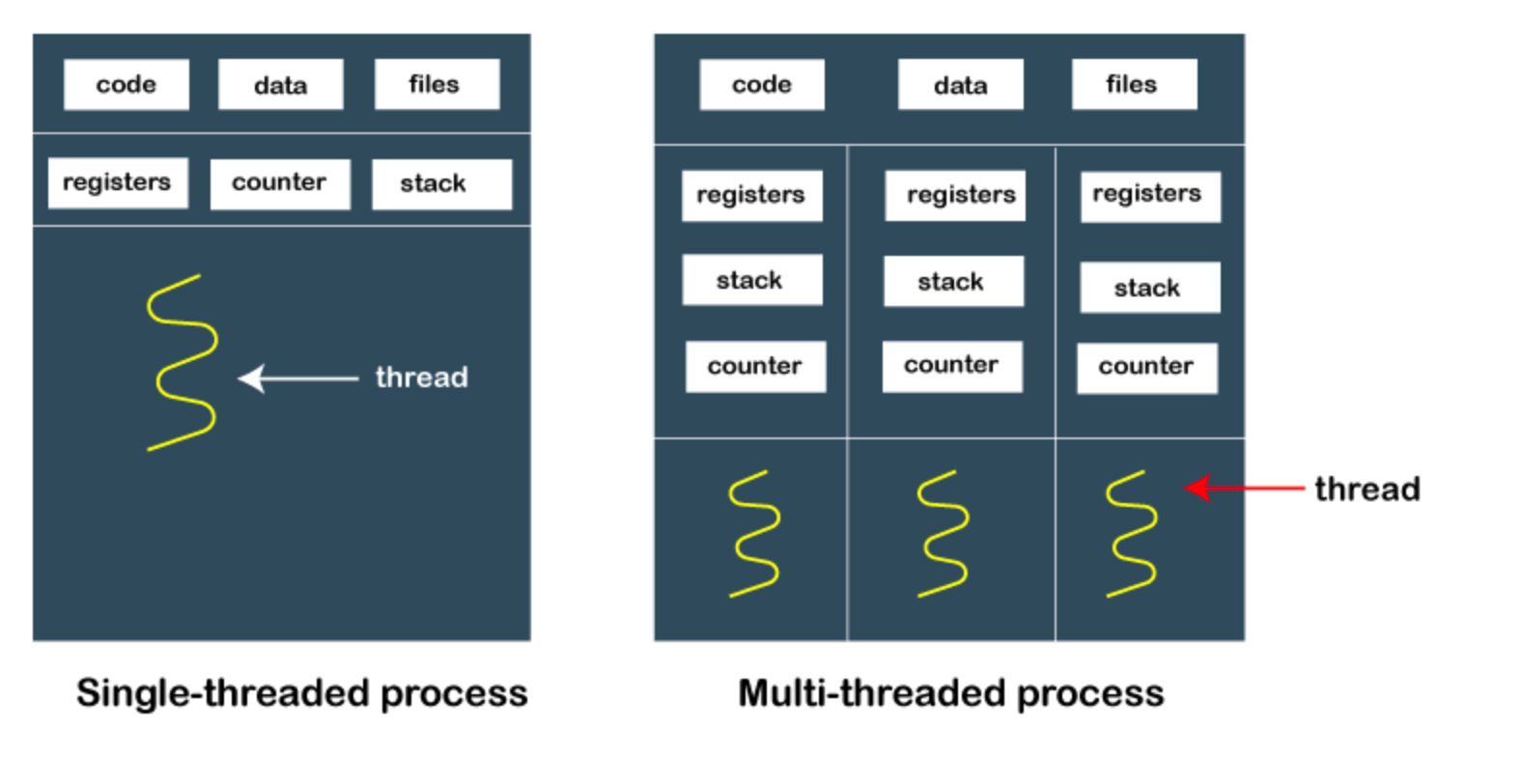

Procesos vs. Threads

- Programa

Una colección de instrucciones y datos que pueden ser ejecutados por una computadora para realizar una tarea o función específica.

- Proceso

Una instancia en ejecución de un programa. Es una unidad independiente que consiste en su propio espacio de direcciones, memoria, datos y recursos del sistema.

- Thread

La unidad más pequeña de ejecución dentro de un proceso.

Representa una secuencia única de instrucciones que puede ser programada por el scheduler del sistema.

Múltiples hilos dentro de un proceso comparten el mismo espacio de memoria pero tienen su propio

Tipos de threads

- User-Level: El trabajo de gestión de hilos lo hace la aplicación y el kernel no es consciente de la existencia de estos hilos.

- Kernel-Level: Todo el trabajo de gestión de hilos lo realiza el kernel. A nivel de aplicación hay una API para la funcionalidad de hilos del kernel.

| Característica | Hilos a Nivel de Usuario | Hilos a Nivel de Kernel |

|---|---|---|

| Implementación | En espacio de usuario | En espacio de kernel |

| Tiempo de Cambio de Contexto | Rápido | Más lento |

| Sobrecarga/Consumo de Memoria | Bajo | Mayor |

| Reconocimiento del SO | No reconocidos | Reconocidos |

| Programación | Por biblioteca de nivel de usuario | Por kernel del SO |

| Asignación de Recursos | No directa | Directa |

| Bloqueo | Un hilo puede bloquear todo el proceso | Bloqueo independiente |

| Rendimiento en Multi CPU | Limitado | Mejor |

Thread Programming

Hay que saber cómo levantar un thread en los lenguajes que vayamos a usar,

para entender cómo los tratan por abajo.

Java

private static void hello() {

var t1 = new Thread(new Runnable() {

@Override

public void run() {

System.out.println("Hello from thread 1");

}

});

var t2 = new Thread(new Runnable() {

@Override

public void run() {

System.out.println("Hello from thread 2");

}

});

t1.start();

t2.start();

}

// Con Lambdas

private static void helloLambda() {

var t1 = new Thread(() -> System.out.println("Hello from thread 1"));

var t2 = new Thread(() -> System.out.println("Hello from thread 1"));

t1.start();

t2.start();

}

Cabe destacar que lo anterior simplemente levanta los threads, que se ejecutarán como el procesador los quiera ejecutar.

Administrar manualmente la ejecución

private static void hello() throws InterruptedException {

var t1 = new Thread(() -> System.out.println("Hello from thread 1"));

var t2 = new Thread(() -> System.out.println("Hello from thread 2"));

t1.start();

t2.start();

t1.join();

t2.join();

}

El método join espera a que el thread termine su ejecución.

Si no se llama a join, el thread principal puede terminar antes que los threads secundarios.

Denle importancia al

throws InterruptedException. La firma de esta función es así porque, al querer unir los threads al principal (o esperar a que terminen), puede haber una interrupción.

Al llamar a este método, se habilita a que cualquier thread interrumpa el actual (donde se está ejecutando esta función) por la razón que sea.

Rust

#![allow(unused)] fn main() { fn hello() { thread::spawn(|| println!("Hello from thread 1")); thread::spawn(|| println!("Hello from thread 2")); } }

Esperar a que termine la ejecución

#![allow(unused)] fn main() { fn hello() { let t1 = thread::spawn(|| println!("Hello from thread 1")); let t2 = thread::spawn(|| println!("Hello from thread 2")); // Esperar a que los threads se completen t1.join().expect("t1 failed"); t2.join().expect("t2 failed"); } }

Thread Scope

El Scope es una forma de agrupar threads, de forma tal que se ejecuten en un mismo contexto.

Además, el Scope permite que los threads se compartan variables entre ellos, sin necesidad de usar Arc o Mutex (para

casos de solo lectura).

Una vez termina el Scope, los threads se unen automáticamente, por lo que no es necesario llamar a join manualmente.

#![allow(unused)] fn main() { fn hello() { thread::scope(|s| { s.spawn(|| println!("Hello from thread 1")); s.spawn(|| println!("Hello from thread 2")); }); } }

Lifetime

Sabiendo que Rust sabe que los threads no escapan del scope:

- Las reglas de Lifetime son más simples

- Podemos usar variables del scope externo

#![allow(unused)] fn main() { fn hello() { let n = 10; let mut m = 10; thread::scope(|s| { s.spawn(|| { m += 1; println!("Hello from thread 1, n = {n}") }); s.spawn(|| println!("Hello from thread 2, n = {n}")); }); println!("{m}"); } // Output: 11 }

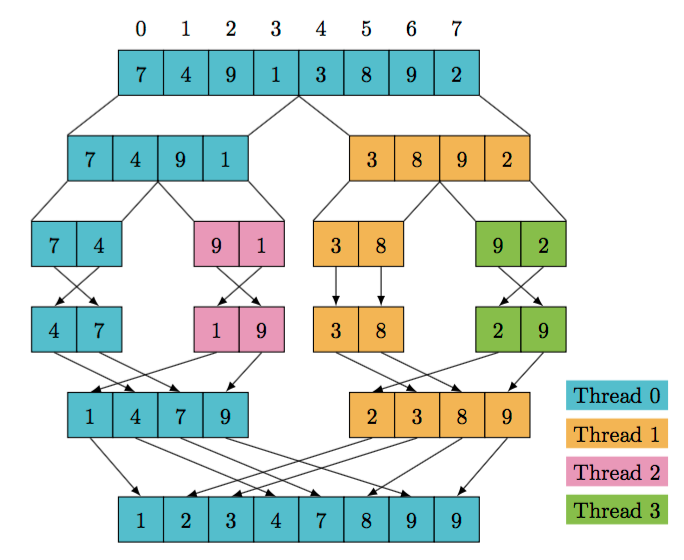

Paralelismo

Esta clase todo lo que hace es mostrar implementaciones concurrentes de resolver algoritmos iterativos, que terminan siendo dividir los cálculos en algún punto, spawnear un thread en esa división y seguir calculando.

Después de eso se espera que el thread termine y se junten los resultados.

Ejemplo

Si queremos calcular , podemos:

- Primero calcular

- Después calcular

- Finalmente, multiplicar los resultados de los dos pasos anteriores.

Implementación secuencial

#![allow(unused)] fn main() { fn evaluate_sequential(k: f64, a: f64, t: f64) -> f64 { let a = 2.0 * k * a * t; let b = f64::exp(-a * t * t); return a * b; } }

Implementación concurrente

#![allow(unused)] fn main() { use std::thread; fn evaluate_parallel(k: f64, a: f64, t: f64) -> f64 { let thread1 = thread::spawn( || 2.0 * k * a * t ); let thread2 = thread::spawn( || f64::exp(-a * t) ); let a = thread1.join().unwrap(); let b = thread2.join().unwrap(); return a * b; } }

Se puede hacer una pequena optimización, en vez de crear dos threads, podemos crear uno solo y hacer el cálculo de dentro del thread. Esto es para que el thread principal no se quede esperando a que termine el otro thread, con tal de seguir ejecutando el resto del código.

#![allow(unused)] fn main() { use std::thread; fn evaluate_parallel_opt(k: f64, a: f64, t: f64) -> f64 { let first_half = 2.0 * k * a * t; let thread2 = thread::spawn(|| f64::exp(-a * t)); let second_half = thread2.join().unwrap(); return first_half * second_half; } }

Observación importante

A veces, no siempre es mejor hacer implementaciones paralelas, dado que puede suponer un overhead a partir de los cambios de contexto.

Si el cálculo es muy rápido, el overhead de crear un thread puede ser mayor que el tiempo que se tarda en calcular el resultado de manera iterativa.

Ejemplo - MergeSort

#![allow(unused)] fn main() { pub fn merge(first: &[i32], second: &[i32]) -> Vec<i32>{ let mut result = Vec::new(); let mut i = 0; let mut j = 0; // Merge until one of the inputs is exhausted while i < first.len() && j < second.len() { if first[i] <= second[j] { result.push(first[i]); i += 1 } else { result.push(second[j]); j += 1 } } // Copy the remaining items result.extend_from_slice(&first[i..]); result.extend_from_slice(&second[j..]); result } pub fn sort(array: &[i32]) -> Vec<i32> { let len = array.len(); if len <= 1 { array.to_vec() } else { let (first, second) = thread::scope(|s| { let x = sort(&array[..len / 2]); // First half let y = s.spawn(|| sort(&array[(len / 2) + 1..])); // Second half (x, y.join().unwrap()) // <-- Scope also returns a value }); merge(&first, &second) } } }

Por lo general se optimiza de la siguiente manera (conceptualmente):

- Se implementan ambos métodos de cálculo (secuencial y concurrente)

- Si se supera un cierto threshold o límite, se llama al método concurrente

- Este threshold va a variar dependiendo del caso y del algoritmo a implementar

- Inclusive puede variar según la máquina donde se esté corriendo

- Si no, se opera con el método secuencial.

Esto se hace para evitar cambios de contexto innecesarios. Los threshold se obtienen/determinan a prueba y error.

Más ejemplos

Matriz

#![allow(unused)] fn main() { #[derive(Debug, Clone)] pub struct Matrix(pub Vec<Vec<f64>>); impl Matrix { pub fn rows(&self) -> usize { self.0.len() } pub fn columns(&self) -> usize { self.0[0].len() } } }

#![allow(unused)] fn main() { // Suma de matrices pub fn add_serial(&self, other: &Matrix) -> Matrix { let rows = self.rows(); let cols = self.columns(); let mut result = Vec::new(); for i in 0..rows { let mut row = Vec::new(); for j in 0..cols { row.push(self.0[i][j] + other.0[i][j]); } result.push(row); } Matrix(result) } // Secuencial con map pub fn add_serial(&self, other: &Matrix) -> Matrix { let rows = self.rows(); let cols = self.columns(); let result = (0..rows) .map(|i| (0..cols) .map(|j| self.0[i][j] + other.0[i][j]) .collect() ) .collect(); Matrix(result) } }

#![allow(unused)] fn main() { // Paralelo, fila por fila pub fn add_parallel(&self, other: &Matrix) -> Matrix { let rows = self.rows(); let cols = self.columns(); thread::scope(|s| { let threads: Vec<_> = (0..rows) .map(|i| { s.spawn(move || { (0..cols).map(|j| self.0[i][j] + other.0[i][j]).collect() }) }) .collect(); Matrix(threads.into_iter() .map(|t| t.join().unwrap()) .collect()) }) } }

Exclusión Mutua

La raíz del problema

- No determinismo causado por hilos concurrentes accediendo a un estado mutable compartido.

- Ayuda encapsular el estado en actores o transacciones, pero el problema fundamental sigue siendo el mismo.

No determinismo = procesamiento paralelo + estado mutable.

- Para obtener un procesamiento determinista, ¡evita el estado mutable!

- Evitar el estado mutable significa programar funcionalmente.

Condición de carrera

Una condición de carrera ocurre cuando dos o más operaciones deben ejecutarse en una secuencia específica, pero el comportamiento sustancial del sistema no está garantizado, llevando a resultados erráticos e impredecibles.

Ejemplo en Java

public class Counter {

int value = 0;

void increment() {

int localCounter = value;

System.out.println(threadName() + " reads counter as: " + localCounter);

localCounter = localCounter + 1;

value = localCounter;

System.out.println(threadName() + " updated counter to: " + value);

}

}

public class Main {

public static void main(String[] args) {

var counter = new Counter();

// Two threads trying to increment the counter simultaneously

Thread t1 = new Thread(counter::increment, "Thread 1");

Thread t2 = new Thread(counter::increment, "Thread 2");

startAll(t1, t2);

joinAll(t1, t2);

System.out.println("Expected value: 2, actual value: " + counter.value);

}

}

Output:

Thread 1 reads counter as: 0

Thread 2 reads counter as: 0

Thread 1 updated counter to: 1

Thread 2 updated counter to: 1

Expected value: 2, actual value: 1

Solución: Forzar Acceso Único

Si forzamos una regla de que solo un proceso puede entrar al método incrementar a la vez entonces:

- Thread1 entra a incrementar primero y crea un bloqueo

- Thread2 intenta entrar pero es bloqueado

- Thread1 completa la ejecución y libera el bloqueo

- Thread2 se reanuda y ejecuta incrementar

public class Counter {

int value = 0;

synchronized void increment() {

int localCounter = value;

System.out.println(threadName() + " reads counter as: " + localCounter);

localCounter = localCounter + 1;

value = localCounter;

System.out.println(threadName() + " updated counter to: " + value);

}

}

Nótese que el keyword synchronized en Java es un ejemplo básico de un lock (específicamente de un Mutex).

- Si se hace sobre un método, el lock es sobre el objeto que contiene el método.

- Si se hace sobre un bloque, el lock es sobre el objeto que se le pasa al bloque.

- Si se hace sobre una variable o atributo de la clase, el lock es sobre la variable o atributo.

- Si se hace sobre un método estático, el lock es sobre la clase.

Memoria compartida entre hilos

public class Test {

boolean a = false, b = false;

int x = -1, y = -1;

void test(int execution) {

var t1 = new Thread(() -> {

sleep(1);

a = true;

y = b ? 0 : 1;

});

var t2 = new Thread(() -> {

sleep(1);

b = true;

x = a ? 0 : 1;

});

startAll(t1, t2);

joinAll(t1, t2);

if (x == 1 && y == 1)

throw new RuntimeException("Failed at execution number : " + execution);

}

}

Posibles casos para el programa anterior:

-

Primera alternativa:

t1corre primero

t1escribetrueena, luego leeby vefalse→ escribe1eny

t2escribetrueenb, luego leeay vetrue→ escribe0enx

Resultado:x == 0yy == 1 -

Segunda alternativa:

t2corre primero

t2escribetrueenb, luego leeay vefalse→ escribe1enx

t1escribetrueena, luego leeby vetrue→ escribe0eny

Resultado:x == 1yy == 0 -

Tercera alternativa: Ejecución parcial

t1escribetrueenay es interrumpido

t2escribetrueenb

Luego, tantot1comot2ven ambos valores entrue, así que escriben0enxey

Resultado:x == 0yy == 0

Conclusión: No existe ninguna ejecución en la que x == 1 y y == 1

Pongámoslo a prueba

public static void main(String[] args) {

for (var i = 0; i < 10_000; i++)

new Test().test(i);

}

Output:

Exception in thread "main" java.lang.RuntimeException: Failed at execution number : 880

at org.example.counter.Test.test(Test.java:25)

at org.example.counter.Test.main(Test.java:30)

¿Por qué falló?

Los hilos pueden correr en distintos núcleos usando su propia memoria (por ejemplo, L1 cache).

Los threads se sincronizan a través de la memoria compartida, por ejemplo, después de hacer join.

Entonces, esto es posible:

t1escribetrueena, luego leeby vefalse→ escribe1enyt2escribetrueenb, luego leeay vefalse→ escribe1enxPorquet2tiene su propio valor deaque todavía no fue sincronizado.

En el ejemplo anterior en el que es virtualmente imposible que falle, la falla se da porque el thread que falló leyó memoria vieja (que ya no existe) respecto a una de las 2 variables, y actualizó la otra.

Es difícil compartir la memoria entre threads debido a estas cuestiones, por lo que en distintos lenguajes se implementan distintas formas de hacerlo.

En Java, se usa el keyword volatile. En este caso se declaran a y b con este keyword.

Esto fuerza a la JVM a sincronizar la variable hacia y desde la memoria compartida. volatile es ligero y más rápido que el bloqueo.

Competencia por recursos

Ahora, otro de los problemas principales de la memoria compartida es que los procesos van a competir por recursos, lo que genera las siguientes necesidades y problemas:

- Necesidad de Exclusión Mutua. Sólo un proceso a la vez debe ser permitido en la sección crítica del programa.

- Deadlock

- Starvation

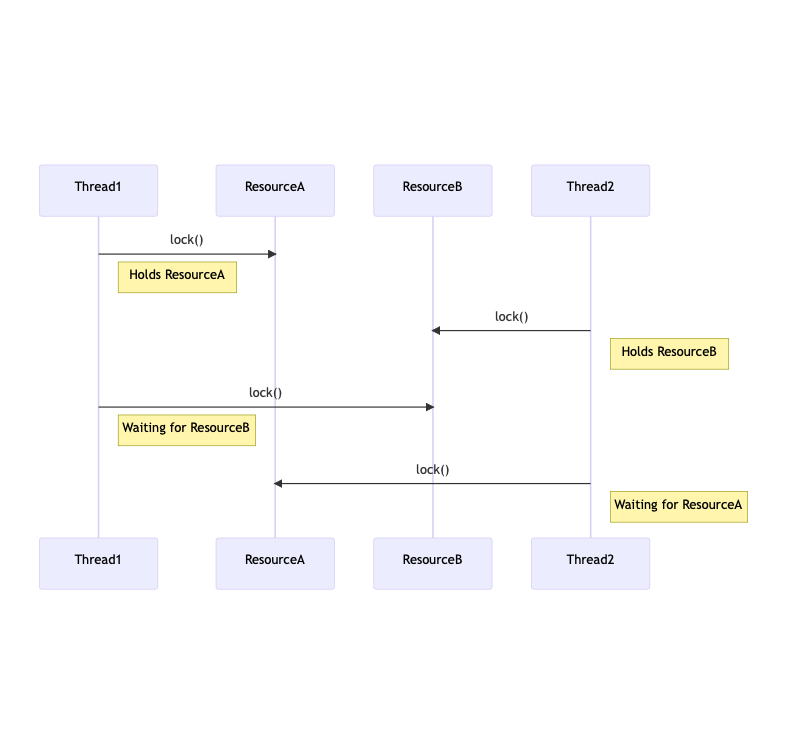

Deadlock

Deadlock puede ser definido como el bloqueo permanente de un conjunto de procesos que compiten por recursos.

Un conjunto de procesos está en deadlock cuando cada proceso en el conjunto está bloqueado

esperando por un recurso que está retenido por otro proceso bloqueado en el conjunto.

Ejemplo

public void transferTo(BankAccountSync to, double amount) {

synchronized (this) {

// Lock over 'this' acquired

// Try to lock 'to'

synchronized (to) {

// Lock over 't0' acquired.

withdraw(amount);

to.deposit(amount);

}

// lock over 'to' released

}

// lock over 'this' released

}

Starvation

Una situación donde a un proceso se le niegan perpetuamente los recursos que necesita para progresar, mientras que otros procesos son favorecidos, llevando a una espera indefinida.

En resumen, un proceso se muere de hambre porque quiere acceder a un recurso y siempre se le deniega dicho acceso.

Ejemplo de solución de Starvation

public class Counter {

int value = 0;

void increment() {

disableInterruptions();

int localCounter = value;

localCounter = localCounter + 1;

value = localCounter;

enableInterruptions();

}

}

- Esto sólo funciona en uni-procesadores

- Generalmente es ineficiente

Otro ejemplo

volatile boolean lock = false;

void increment() {

while (lock) {

// Busy Loop

}

lock = true;

// Begin Critical Section

int localCounter = value;

System.out.println(threadName() + " reads counter as: " + localCounter);

localCounter = localCounter + 1;

value = localCounter;

// End Critical Section

lock = false;

System.out.println(threadName() + " updated counter to: " + value);

}

- Necesito del keyword

volatilepara el lock justamente por estas cuestiones de sincronización. - El problema radica acá:

while (lock) {

// Busy Loop

}

// Puedo tener un Context Switch acá !

lock = true;

La alternativa para estos casos es el uso de variables atómicas, otorgadas por el hardware (que veremos más adelante en Non-Blocking Algorithms):

void increment() {

while (v.compareAndSet(false, true)) {

// busyLoop

}

// Critical section

// ...

}

- Lo bueno: Aplicable a cualquier cantidad de procesos.

- Lo malo: El busy-waiting consume tiempo de procesador.

- Solución:

- Después de girar un poco (spinning), devolver el control al sistema operativo.

while (lock.compareAndSet(false, true)) Thread.yield();

Por último, en clase vimos que Rust no puede tener condiciones de carrera porque es un lenguaje de verdad y el borrow checker lo evita (al menos con una variable mutable).

En casos más complejos lo resuelve de otra manera.

#![allow(unused)] fn main() { fn counter() -> i32 { let mut counter = 0; thread::scope(|s| { s.spawn(|| counter += 1); s.spawn(|| counter += 1); }); return counter } }

Output:

error[E0499]: cannot borrow `counter` as mutable more than once at a time

... Etc..

Sin embargo, según la documentación de Rust, el lenguaje previene específicamente Data Races, un subtipo de condiciones de carrera donde:

- Dos o más threads acceden concurrentemente un espacio de memoria

- Uno o más de ellos realiza una operación de escritura

- Uno o más de ellos no está sincronizado

Y dicha prevención proviene justamente de lo explicado anteriormente respecto al borrow checker.

Sin embargo, no nos protege de condiciones de carrera en general. Por ejemplo, veamos el siguiente caso:

fn main() { let data = vec![1, 2, 3, 4]; let idx_mutex = Arc::new(Mutex::new(0)); let other_idx_mutex = Arc::clone(&idx_mutex); let _ = thread::spawn(move || { let mut current_idx = other_idx_mutex.lock().unwrap(); *current_idx += 10; }); let current_index_value; { let idx_guard = idx_mutex.lock().unwrap(); current_index_value = *idx_guard; } println!("{}", data[current_index_value]); }

- Si el thread principal se termina de ejecutar y luego corre el thread que él mismo inicializa, el print funciona, mostrando el primer elemento del Vec.

- En cambio, si ese segundo thread logra ejecutarse primero, entonces

current_index_value = 10. Esto provoca un panic en el print, ya que se intenta acceder al elemento 10 del Vec, pero solo tiene 4 elementos.

En consecuencia, se da una condición de carrera porque el programa puede ser exitoso o fallar dependiendo del orden de ejecución de los threads.

Abstracciones de Concurrencia - Parte I

Lock

Un lock (o mutex de exclusión mutua) es una primitiva de sincronización que previene que el estado sea modificado o accedido por múltiples hilos de ejecución a la vez.

- Cuando un hilo quiere acceder a un recurso compartido, primero intenta adquirir el lock asociado con ese recurso.

- Si el lock está disponible (i.e., no está siendo retenido por otro hilo), el hilo adquiere el lock, accede al recurso, y luego libera el lock cuando termina.

- Si el lock no está disponible (i.e., actualmente retenido por otro hilo), el hilo que lo solicita es bloqueado para proceder hasta que el lock esté disponible.

Tipos de Lock

- Mutex (Exclusión Mutua) : Un lock básico que permite que solo un hilo acceda a un recurso a la vez.

- Reentrant Lock: Puede ser adquirido múltiples veces por el mismo hilo sin causar un deadlock.

- Read/Write Locks: Permite que múltiples lectores accedan al recurso simultáneamente, pero requiere acceso exclusivo para escritura.

Ejemplos

- Con

synchronizedsobre un objeto:

class BankAccountSync {

private double balance;

private final Object lock = new Object();

public BankAccountSync(double initialBalance) {

this.balance = initialBalance;

}

// Synchronized method to deposit money

public void deposit(double amount) {

synchronized (lock) {

if (amount > 0) {

balance += amount;

System.out.println("Deposited: " + amount);

}

}

}

// Synchronized method to withdraw money

public void withdraw(double amount) {

synchronized (lock) {

if (amount > 0 && balance >= amount) {

balance -= amount;

System.out.println("Withdrawn: " + amount);

} else {

System.out.println("Insufficient balance for withdrawal");

}

}

}

public double getBalance() {

synchronized (lock) {

return balance;

}

}

}

synchronizedsobre un método:

class BankAccountSync {

private double balance;

public BankAccountSync(double initialBalance) {

this.balance = initialBalance;

}

// Synchronized method to deposit money

public synchronized void deposit(double amount) {

if (amount > 0) {

balance += amount;

System.out.println("Deposited: " + amount);

}

}

// Synchronized method to withdraw money

public synchronized void withdraw(double amount) {

if (amount > 0 && balance >= amount) {

balance -= amount;

System.out.println("Withdrawn: " + amount);

} else {

System.out.println("Insufficient balance for withdrawal");

}

}

public double getBalance() {

synchronized (this) {

return balance;

}

}

}

- Con

Lockdel API deJava:

class BankAccountWithLock implements BankAccount {

private double balance;

private final Lock lock = new ReentrantLock();

public BankAccountWithLock(double initialBalance) {

this.balance = initialBalance;

}

// Method to deposit money using Lock

public void deposit(double amount) {

lock.lock();

try {

if (amount > 0) {

balance += amount;

System.out.println("Deposited: " + amount);

}

} finally {

lock.unlock();

}

}

// ... etc

}

En un lenguaje de verdad...

- Un mutex en Rust es un dato con un lock que protege su acceso.

- Para acceder al dato dentro del mutex, un thread tiene que avisar que quiere acceder pidiendo adquirir el lock del mutex.

lockdevuelve un Smart Pointer al valor dentro del Mutex.- Devuelve un

MutexGuard<T>

- Devuelve un

- Mutex sólo le permite a un thread a la vez acceder al dato.

#![allow(unused)] fn main() { use std::sync::Mutex; pub struct BankAccount { balance: Mutex<f64> } impl BankAccount { pub fn new(initial_balance: f64) -> BankAccount { BankAccount { balance: Mutex::new(initial_balance) } } pub fn deposit(&self, amount: f64) { let mut balance = self.balance.lock().unwrap(); *balance += amount; println!("Deposited: {}", amount); } pub fn withdraw(&self, amount: f64) { if let Ok(mut balance) = self.balance.lock() { if *balance >= amount { *balance -= amount; println!("Withdrawn: {}", amount); } else { println!("Insufficient balance for withdrawal"); } } } pub fn get_balance(&self) -> f64 { *self.balance.lock().unwrap() } } }

Livelock

Es una condición que tiene lugar cuando 2 o más threads cambian su estado continuamente, sin que ninguno de ellos haga progreso.

Esto lo hace ver con el ejemplo del problema de los filósofos, en la variante donde todos agarran primero el tenedor derecho y el último lo da vuelta (agarra el izquierdo).

Recordemos que en el caso donde todos intentan agarrar primero el derecho se produce un deadlock.

Reader Writer Lock

También conocido como un lock compartido-exclusivo o un lock de múltiples lectores/un único escritor.

- Es un mecanismo de sincronización para manejar situaciones donde un recurso puede ser accedido por múltiples hilos simultáneamente.

- Este tipo de lock permite acceso concurrente de solo lectura al recurso compartido, mientras que las operaciones de escritura requieren acceso exclusivo.

Son útiles en escenarios de alta concurrencia donde las lecturas son frecuentes y las escrituras son poco frecuentes.

- Múltiples threads pueden sostener el lock de lectura simultáneamente, siempre y cuando ningún thread sostenga el lock de escritura.

- Solo un thread puede sostener el lock de escritura a la vez. Cuando un thread sostiene el lock de escritura, ningún otro thread puede sostener el lock de lectura o escritura.

- Se pueden implementar con diferentes políticas de prioridad, como dar preferencia a los lectores, escritores o ninguno.

- La elección de la política puede afectar el comportamiento del lock en términos de equidad y potencial de

Starvation.

Ejemplo

#![allow(unused)] fn main() { impl BankAccountRW { pub fn new(initial_balance: f64) -> BankAccountRW { BankAccountRW { balance: RwLock::new(initial_balance) } } pub fn deposit(&self, amount: f64) { if let Ok(mut balance) = self.balance.write() { *balance += amount; println!("Deposited: {}", amount); } } pub fn get_balance(&self) -> f64 { *self.balance.read().unwrap() } } }

Semáforos

Son una primitiva de sincronización usada en programación concurrente.

Proveen un mecanismo para controlar el acceso a recursos compartidos por múltiples procesos o hilos.

En definitiva, es un contador con 2 operaciones principales:

down (P)oacquire: Decrementa el contador. Si el contador es menor a 0, el hilo se bloquea hasta que se libere.up (V)orelease: Incrementa el contador. Si el contador era 0 o menor, despierta a un hilo bloqueado.

Tipos de semáforos

- Semáforo binario: Puede tomar solo los valores 0 o 1. Se usa para implementar exclusión mutua.

- El

MutexoLockcomún que conocemos es de este tipo.Mutexde Rust yLockde Java

- El

- Semáforo contable: Puede tomar cualquier valor entero no negativo. Se usa para controlar el acceso a un número limitado de recursos.

public class Counter {

int value = 0;

Semaphore semaphore = new Semaphore(1, true);

void increment() {

semaphore.acquire(); // wait or down or P

int local_counter = value;

local_counter = local_counter + 1;

value = local_counter;

semaphore.release(); // signal or up or V

}

}

Implementación de un semáforo

class Semaphore {

private boolean lock;

private int count;

private Queue<Thread> q;

public Semaphore(int init) {

lock = false;

count = init;

q = new Queue();

}

public void down() {

while (lock.testAndSet()) { /* just spin */ }

if (count > 0) {

count--;

lock = false;

}

else {

q.add(currrentThread);

lock = false;

suspend();

}

}

public up() {

while (lock.testAndSet()) { /* just spin */ }

if (q == empty) count ++;

else q.pop().wakeUp();

lock = false;

}

}

Abstracciones de Concurrencia - Parte II

Variables de Condición

Tienen como propósito hacer que los threads esperen una condición específica sin consumir recursos. Similar a los semáforos, tienen 2 operaciones principales:

- Esperar: un thread espera a que una condición se cumpla. Si no se cumple, libera el Mutex asociado de manera atómica para evitar condiciones de carrera.

- Señalizar: un thread notifica a otro que la condición se ha cumplido. Esto despierta al thread que estaba esperando.

Ejemplo de uso

// Sin condvar: use std::sync::{Mutex, Arc}; fn main() { let queue = Mutex::new(VecDeque::new()); thread::scope(|s| { s.spawn(|| { loop { // Busy loop !! let mut q = queue.lock().unwrap(); if let Some(item) = q.pop_front() { println!("Popped: {item}", ); } } }); for i in 0.. { queue.lock().unwrap().push_back(i); thread::sleep(Duration::from_secs(1)); } } ); }

// Con condvar: use std::sync::{Mutex, Condvar}; fn main() { let queue = Mutex::new(VecDeque::new()); let not_empty = Condvar::new(); thread::spawn(|| { loop { let mut q = queue.lock().unwrap(); if let Some(item) = q.pop_front() { println!("Popped: {item}", ); } else { q = not_empty.wait(q).unwrap(); // <--- Wait } } }); // Pushear elementos: for i in 0.. { queue.lock().unwrap().push_back(i); not_empty.notify_one(); // <-- notify the first thread waiting thread::sleep(Duration::from_secs(1)); } }

Beneficios

- Mecanismo de espera eficiente en programación concurrente

- Facilita escenarios de sincronización compleja

Problema de Producers-Consumers

Involcura 2 tipos de hilos: Productores y Consumidores

- Los productores generan datos y los pushean a un buffer de memoria compartido.

- Los consumidores consumen esos datos y los procesan.

Implementación en Rust

#![allow(unused)] fn main() { struct CircularBuffer<T> { buffer: Vec<Option<T>>, capacity: usize, head: usize, tail: usize, size: usize, } impl<T> CircularBuffer<T> { pub fn add(&mut self, element: T) -> bool { if self.size == self.capacity { return false } let i = self.head; self.buffer[i] = Some(element); self.head = (i + 1) % self.capacity; self.size += 1; return true; } pub fn remove(&mut self) -> Option<T> { if self.size == 0 { return None } let i = self.tail; let result = self.buffer[i].take(); self.tail = (i + 1) % self.capacity; self.size -= 1; result } } }

Implementación concurrente

#![allow(unused)] fn main() { struct Data<T> { buffer: Vec<Option<T>>, capacity: usize, head: usize, tail: usize, size: usize, } pub struct CircularBuffer<T> { data: Mutex<Data<T>>, // Se wrappean los datos en un mutex por cuestiones de sincronización // Se usan 2 variables de condición para notificar a cada tipo de hilo not_empty: Condvar, // Para consumidores not_full: Condvar // Para productores } impl<T> CircularBuffer<T>{ pub fn add(&self, element: T) { let mut data = self.data.lock().unwrap(); // Lock the Mutex while data.size == data.capacity { data = self.not_full.wait(data).unwrap(); // Wait until not full } data.buffer[data.head] = Some(element); data.head = (data.head + 1) % data.capacity; data.size += 1; self.not_empty.notify_one(); // notify that is not empty } pub fn remove(&self) -> T { let mut data = self.data.lock().unwrap(); // Lock the mutex while data.size == 0 { data = self.not_empty.wait(data).unwrap(); // Wait until not empty } let result = data.buffer[data.tail].take(); data.tail = (data.tail + 1) % data.capacity; data.size -= 1; self.not_full.notify_one(); // Notify that is not full result.unwrap() } } }

Monitores

Es una primitiva de sincronización que le permite a los threads tener:

- Exclusión mutua

- La capacidad de bloquear la ejecución si no se cumple una condición específica

- Un mecanismo de señalización para despertar threads que están esperando por la misma condición

En resumen, es un Mutex + una CondVar

En Rust no existen los monitores como tal, pero se pueden implementar usando Mutex y Condvar.

En Java sí están built-in, pero no como objeto, sino mediante el uso del keyword synchronized y los métodos wait(),

notify() y notifyAll().

class Account {

double balance;

synchronized public void withdraw(double amount) throws InterruptedException {

if (amount <= 0) return;

while (balance < amount) {

// Wait for enough balance");

wait();

}

balance -= amount;

}

synchronized public void deposit(double amount) {

if (amount > 0) {

balance += amount;

notify(); // Notify that some money have been deposited

}

}

}

Problema de Producer-Consumer en Java con Monitores

public class CircularBuffer<T> {

List<T> buffer;

int capacity, head, tail, size;

public CircularBuffer(int capacity) {

buffer = new ArrayList<>(capacity);

this.capacity = capacity;

}

public synchronized void add(T element) throws InterruptedException {

while (size == capacity) wait();

buffer.set(head, element);

head = (head + 1) % capacity;

size += 1;

notifyAll();

}

public synchronized T remove() throws InterruptedException {

while (size == 0) wait();

var result = buffer.get(tail);

tail = (tail + 1) % capacity;

size -= 1;

notifyAll();

return result;

}

}

Pasaje de mensajes

La idea de los mensajes es evitar la comunicación entre threads mediante la compartición de memoria. Esto lo logra "intentándolo al revés", es decir, compartiendo memoria a través de la comunicación.

Pasar de esto:

A esto:

- En el pasaje de mensajes, la información a compartir es copiada físicamente desde el espacio de direcciones del proceso remitente a los espacios de direcciones de todos los procesos destinatarios

- Esto se logra transmitiendo los datos en forma de mensaje

- Un mensaje es simplemente un bloque de información

Mensajes síncronos vs. asíncronos

| Característica | Síncrono | Asíncrono |

|---|---|---|

| Sincronización | El emisor espera a que el receptor obtenga el mensaje | El emisor continúa sin esperar |

| Control de Flujo | Automático mediante el bloqueo del emisor | Requiere gestión explícita |

| Complejidad | Menor, debido a la coordinación directa | Mayor, debido al manejo indirecto |

| Caso de Uso | Ideal para tareas estrechamente acopladas | Ideal para tareas independientes |

| Rendimiento | Puede ser más lento debido a las esperas | Mayor, ya que no implica esperas |

| Utilización de Recursos | Menor durante las esperas | Mayor, ya que las tareas siguen ejecutándose |

En Rust esto se logra a través de los channels, que vienen de la librería std::mpsc.

#![allow(unused)] fn main() { fn channels_example() { // Create a channel let (sender, receiver) = mpsc::channel(); // MPSC = Multiple Producer, Single Consumer // Spawn a new thread thread::spawn(move || { // Send a message to the channel let msg = "Hello from the spawned thread!"; sender.send(msg).unwrap(); println!("Sent message: '{}'", msg); }); // Receive the message in the main thread let received = receiver.recv().unwrap(); println!("Received message: '{}'", received); } }

#![allow(unused)] fn main() { fn other_example() { // Create a Channel: let (sender, receiver) = mpsc::channel(); // Spawn many threads for tid in 0..10 { let s = sender.clone(); // <--- Clone the sender part thread::spawn(move || { // Send a message to the channel let msg = format!("Hello from thread! {tid}"); println!("Sent message: '{}'", msg); s.send(msg).unwrap(); }); } } }

Algoritmos No Bloqueantes

Hasta ahora bloqueábamos el acceso (Mutex, Condvars, Locks) al resto de hilos para evitar condiciones de carrera.

Con este tipo de algoritmos vamos a tratar de resolver los problemas de los algoritmos bloqueantes, que son:

- Performance: se reduce la performance bajo alta concurrencia, debido a tener que contener el Lock

- Deadlocks

- Uso de recursos: teniendo threads esperando, se puede dar un uso ineficiente de los recursos del sistema.

Ventajas de algoritmos no bloqueantes

- Aumento de eficiencia: operaciones más granulares

- Escalabilidad: operaciones concurrentes sin locks

- Inexistencia de Deadlocks

Variables Atómicas

Rol

- Operaciones atómicas

- Se hacen en un único paso no divisible. No puedo tener el problema del lock porque no lo puedo "partir al medio".

- Integridad de los datos: asegura integridad sin usar locks

- Utilidad:

- Contadores y estadísticas

- Implementaciones concurrentes "lockless" de estructuras de datos

Implementación de un counter usando AtomicInteger

// Sin usar Atomic, deberíamos usar el keyword synchronized.

public class AtomicCounter {

AtomicInteger value = new AtomicInteger(0);

void increment() {

value.incrementAndGet(); // Análogo a un value++

}

int getValue() {

return value.get(); // return value

}

}

Operaciones típicas sobre variables atómicas:

get(),set(int newValue),getAndSet(int newValue)compareAndSet(int expect, int update): compara el valor actual con el esperado y si son iguales lo cambia al nuevo valor.getAndIncrement(),getAndDecrement(),getAndAdd(int delta)getAndUpdate(IntUnaryOperator lambda):IntUnaryOperatores una interfaz funcional que recibe un int y devuelve un int.- Tiene una estructura como esta:

int func(int x)

- Tiene una estructura como esta:

getAndUpdateaplica la función al valor actual y lo actualiza.

En un lenguaje de verdad como Rust

#![allow(unused)] fn main() { struct Counter { value: AtomicU64 } impl Counter { // Initialize a new counter fn new() -> Counter { Counter { value: AtomicU64::new(0) } } // Increment the counter by 1 fn increment(&self) { // Relaxed ordering is often sufficient for simple counters. self.value.fetch_add(1, Ordering::Relaxed); } // Get the current value of the counter fn get(&self) -> usize { self.value.load(Ordering::Relaxed) } } }

Ordering

Es más de bajo nivel, justamente porque Rust permite hacer controles a bajo nivel del procesador.

Cada tipo de ordering tiene diferentes garantías a nivel CPU. Refiere a cómo se ordenan las instrucciones a nivel procesador.

Ordering es un enum que especifica las garantías de visibilidad y orden de las operaciones atómicas entre hilos. En el contexto de algoritmos no bloqueantes, elegir el nivel de Ordering adecuado es clave para asegurar corrección (sin data races) y optimizar rendimiento (minimizando barreras de memoria).

Los órdenes son los siguientes:

-

Sequentially Consistent (

SeqCst): más restrictivo, pero es el más lento. Debe funcionar para TODOS LOS CASOS.- Todas las operaciones atómicas con

SeqCstaparecen en un único orden global, simplificando el razonamiento, pero teniendo como trade-off un mayor costo en barreras de memoria.- Tiene que poner barreras de memoria, justamente para asegurar la consistencia.

- Si se declara un acceso como

SeqCst, ese acceso se queda anclado ahí. - No se pueden reordenar las operaciones de lectura y escritura.

Javalo usa por defecto.

- Todas las operaciones atómicas con

-

AcqRel: combinación de Acquire y Release- Combina Acquire y Release en una operación de lectura-modificación-escritura (por ejemplo, fetch_add), ideal para estructuras de lock-free donde una sola operación hace ambas cosas.

-

Acquire: más restrictivo queRelease, pero menos queAcqRel- Asegura que ninguna lectura/escritura posterior al “load” pueda reordenarse antes de él. Se sincroniza con un

Releasecorrespondiente para “ver” los efectos previos alstore. - Como se usa en conjunto con

Release, lo que se busca (o al menos su caso de uso inicialmente intencionado) es "adquirir y liberar locks".- Lo que intentan ambos orderings es que las secciones críticas del programa no se solapen.

- Todos los accesos posteriores a un

Acquirese van a ejecutar después de este. - No hay ninguna garantía de que se las operaciones anteriores no se reordenen para ejecutarse después.

- El caso de uso de estos 2 en conjunto es bastante simple:

- Adquiero el "lock" al comenzar una sección crítica con

Acquirey cuando termino lo libero usandoRelease(normalmente usando la operación atómicastore).

- Adquiero el "lock" al comenzar una sección crítica con

- Asegura que ninguna lectura/escritura posterior al “load” pueda reordenarse antes de él. Se sincroniza con un

-

Release: más restrictivo queRelaxed, pero menos queAcquire- Garantiza que ninguna lectura/escritura previa al “store” pueda reordenarse después de él. Permite publicar cambios en memoria antes de que otro hilo los observe con un

Acquire. - Todos los accesos anteriores a un

Releasese van a ejecutar antes de este. - No hay ninguna garantía de que se las operaciones posteriores no se reordenen para ejecutarse antes.

- Garantiza que ninguna lectura/escritura previa al “store” pueda reordenarse después de él. Permite publicar cambios en memoria antes de que otro hilo los observe con un

-

Relaxed: menos restrictivo- Solo garantiza la atomicidad de la operación: no impone ningún orden relativo con otras lecturas o escrituras. Útil cuando solo importa el valor atómico, no la sincronización con otros datos.

Operaciones típicas

new(val: i32) -> AtomicI32: lo creaload(order: Ordering) -> i32,store(val: i32, order: Ordering): load lo lee, store le graba un nuevo valorcompare_exchange(expected: i32, new: i32, ...): si encuentra el valor, cambia por el valor del new y devuelve el valor viejo.fetch_add(val: i32, order: Ordering) -> i32,fetch_sub(val: i32, order: Ordering) -> i32: suman y restan, respectivamentefetch_update<F>(set_order: Ordering, fetch_order: Ordering, lambda: F): exactamente igual algetAndUpdatede Java.- Le paso un lambda a aplicar sobre el valor almacenado.

Estructuras de Datos No Bloqueantes

Stack

class Stack<E> {

class Node<E>(val item: E, var next: Node<E>? = null)

private var top: Node<E>? = null

fun push(item: E) {

val newHead = Node(item)

newHead.next = top // Me pueden interrumpir acá, y reemplazar el top

top = newHead

}

// fun pop(): E? { ... }

}

Non-Blocking Concurrent Stack

class ConcurrentStack<E> {

class Node<E>(val item: E, var next: Node<E>? = null)

private var top = AtomicReference<Node<E>?>()

fun push(item: E) {

val newHead = Node(item)

var oldHead: Node<E>?

do {

oldHead = top.get()

newHead.next = oldHead

} while (!top.compareAndSet(oldHead, newHead))

}

fun pop(): E? {

var oldHead: Node<E>? = top.get()

// Siempre que el top sea el mismo que el oldHead, lo reemplazo por el siguiente

while (oldHead != null && !top.compareAndSet(oldHead, oldHead?.next))

oldHead = top.get()

return oldHead?.item

}

}

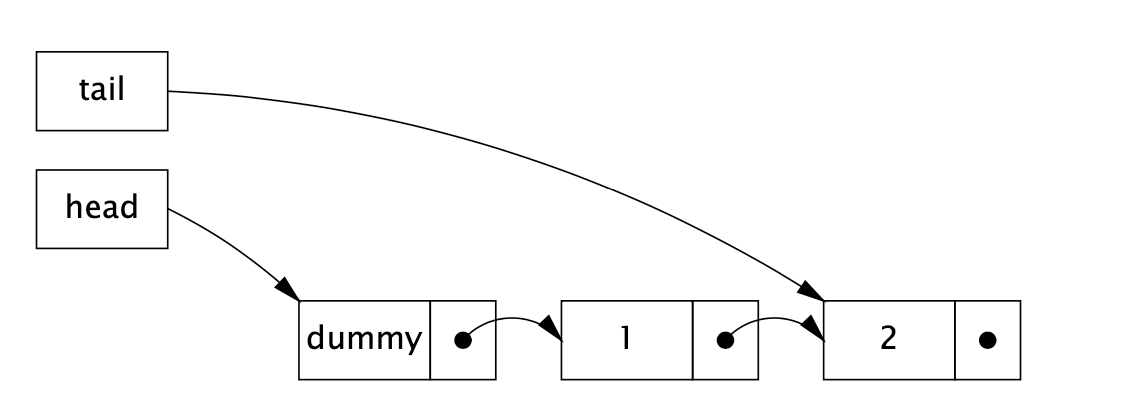

Queue

class Queue<E> {

class Node<E>(val item: E?, var next: Node<E>? = null)

val dummy = Node<E>(null)

var head = dummy

var tail = dummy

fun enqueue(item: E) {

val newNode = Node(item)

tail.next = newNode

tail = newNode

}

fun dequeue(): E? {

val headNext = head.next ?: return null

head = headNext

return head.item

}

}

Non-Blocking Concurrent Queue

La idea de esta implementación no bloqueante es poder completarle la operación a otro hilo, en caso de que se encuentre en un estado intermedio. Es decir, si tengo la

La idea de esta implementación no bloqueante es poder completarle la operación a otro hilo, en caso de que se encuentre en un estado intermedio. Es decir, si tengo la Queue en el estado de la foto, donde tengo que mover el puntero, otro hilo puede completarme la operación si se da un cambio de contexto .

En el caso del Stack es lo mismo.

import java.util.concurrent.atomic.AtomicReference

class ConcurrentQueue<E> {

class Node<E>(val item: E?, var next: AtomicReference<Node<E>>? = null)

val dummy = Node<E>(null)

val head = AtomicReference(dummy)

val tail = AtomicReference(dummy)

fun enqueue(item: E) {

val newNode = Node(item)

while (true) {

val curTail = tail.get()

val tailNext = curTail.next?.get()

// Check if the tail has not moved, which could've happened given a context switch

if (curTail == tail.get()) {

if (tailNext != null) {

// Queue in intermediate state, advance tail (complete operation)

tail.compareAndSet(curTail, tailNext)

}

// If the next to tail is still the same, update the tail

else if (curTail.next?.compareAndSet(null, newNode) == true) {

tail.compareAndSet(curTail, newNode)

return

}

// Try again

}

}

}

}

Problema ABA

El problema ABA es un problema que ocurre en algoritmos no bloqueantes cuando una variable es leída, luego se modifica y finalmente se vuelve a modificar a su valor original. Esto puede llevar a que un hilo crea que la variable no ha cambiado, cuando en realidad sí lo ha hecho. El valor A cambia a B, y luego vuelve a su valor original A.

No es detectable por operaciones concurrentes, lo cual puede llevar a asunciones incorrectas.

¿Por qué es un problema?

- Las operaciones como

compare-and-swap(CAS) pueden ser "engañadas" para que piensen que no ocurrió ningún tipo de cambio - Esto potencialmente puede causar un comportamiento incorrecto del programa

- Por ejemplo, si poppeo un item de un stack y lo vuelvo a pushear

Soluciones posibles

- Versioning: agregar un contador o un timestamp a la variable, y cada vez que se modifica, se incrementa el

contador.

- ABA se vuelve A1 - B2 - A3.

- En Java se puede usar

AtomicStampedReference, que es una referencia atómica que incluye un "timestamp" o versión.ref.compareAndSet(currentValue, newValue, currentStamp, newStamp);

- En

Rustno puede existir este problema. ¿Por qué?- Por el borrow checker y por la inexistencia del Garbage Collector. No puedo tener una pasada del GC en el medio de la operación.

- Como no hay GC, no puedo limpiar "memoria vieja" ni quedarme apuntando a memoria inexistente.

Pros y Contras de los Algoritmos No Bloqueantes

| Aspecto | Pros | Contras |

|---|---|---|

| Rendimiento | Alto en baja contención. | Puede degradarse en alta contención. |

| Escalabilidad | Mejorada debido a la ausencia de bloqueos. | Limitada por la contención y el costo de reintentos. |

| Interbloqueo | Evitado por completo. | Pueden ocurrir livelocks. |

| Simplicidad | Directo para operaciones simples. | Las operaciones complejas son difíciles de diseñar. |

| Sobrecarga del Sistema | Menor, sin cambios de contexto. | Aumentada por espera activa en contención. |

| Recuperación | Sin estados inconsistentes en fallos de hilos. | Recuperación compleja para mantener la consistencia. |

| Equidad (fairness) | No inherente; puede causar starvation. | Difícil de garantizar la equidad. |

| Modelo de Memoria | Puede ser eficiente con CPUs modernas. | Requiere un entendimiento profundo para evitar problemas. |

Alta contención es cuando múltiples threads frecuentemente intentan acceder y modificar el mismo recurso compartido al mismo tiempo.

Programación Asíncrona

Ejemplo: pedir un café

Aclaración: Cada cajero tiene una máquina de café

- El cliente 1 le pide al cajero un café.

- El cajero hace el café

- El cajero le da el café al cliente 1

- Luego viene el cliente 2 y repite la secuencia

De manera síncrona

Consideraciones

- Mientras se está haciendo el café, el cajero se queda esperando, no puede hacer nada más en ese "tiempo muerto".

- El cliente 2 no es atendido por nadie, ni siquiera se encola el pedido de café mientras el café del cliente 1 se está haciendo.

Manera síncrona con 2 vendedores de café

- Existe un cajero por cliente, entonces se resuelve, pero es más caro (?)

De manera asíncrona

- Se manejan de mejor manera los tiempos "muertos".

- Una vez se pide el café, se manda a hacer, y se pueden seguir recibiendo pedidos.

- Una vez termine el primer café, se lo da al primer cliente, y luego se manda a hacer el segundo

- Esto ahorra 1 cajero y 1 máquina de café, haciéndolo prácticamente en el mismo tiempo que con 2.

Ejecución Asíncrona

- Es la ejecución de una operación de cómputo en otra unidad de cómputo

- No se espera "activamente" a que dicha operación termine, sino que se "manda a hacer en el background"

- Se usan los recursos de manera más eficiente

¿Qué pasa si una función depende del resultado de otra?

fun coffeeBreak() {

val coffee = makeCoffee()

drink(coffee)

chatWithColleagues()

}

fun makeCoffee(): Coffee {

println("Making Coffee")

// Work for some time

return Coffee()

}

fun drink(coffee: Coffee) { ... }

Solución usando Callbacks

fun coffeeBreak() {

// MakeCoffee recibe un lambda para interpretar que no hace falta quedarse esperando a que termine

makeCoffee { coffee ->

drink(coffee)

}

chatWithColleagues()

}

fun makeCoffee(coffeeDone: (Coffee) -> Unit) {

println("Making Coffee")

// Work for some time

val coffee = Coffee()

coffeeDone(coffee)

}

fun drink(coffee: Coffee) { }

makeCoffee()es lanzable en otro thread, tranquilamente.

De Sync hacia Async

Para transformar una función de sync a async (o al menos su firma), se debe:

- No devolver un valor

- Tomar como parámetro una continuación que defina qué hacer una vez devuelto el valor computado.

- Esta continuación en definitiva termina siendo un lambda

fun program(a: A): B {

// Do Something

return B()

}

Se lo transforma en CSP (Continuous Passing Style)

fun asyncProgram(a: A, c: (B) -> Unit) {

// Do Something

c(B())

}

Callback Hell

¿Qué sucede si otro programa depende de que el coffee break haya terminado?

Por ejemplo, una conferencia incluye un coffee break en el medio:

fun coffeeBreak(breakDone: ()->Unit)

fun conference() {

presentation { p1 ->

coffeeBreak {

presentation { p2 ->

endConference(p1, p2)

}

}

}

}

Esto se vuelve ilegible, en definitiva. Escala muy poco. También se lo llama "The doom pyramid"

Futures

Es análogo al Promise de JS/TS. Es una "promesa" o un registro de que se llamó a una función asíncrona, por así decirlo.

Este Future va a devolver un valor en algún momento (cuando quiera usar el valor).

Se propaga "para arriba" en la jerarquía de llamados el cuándo espero por el valor.

Es decir, si yo me quedo esperando por un valor asíncrono (por un Promise), la función donde espero por dicho valor se vuelve asíncrona.

En el caso del ejemplo del café, se hace cuando quiera tomar el café, por ejemplo.

Se intenta pasar de esto:

fun program(a: A): B {}

// CSP

fun program(a: A, k: (B) -> Unit) {}

A esto:

fun program(a: A): Future<B> {}

Currying

Esencialmente, pasamos de esto:

fun program(a: A, k: (B) -> Unit) : Unit {}

- Tomamos un callback como parámetro y lo ejecutamos

A esto:

fun program(a: A): ((B) -> Unit) -> Unit {}

- Devolvemos una función que toma una función que devuelve un

Unit, que termina devolviendo unUnit

Usando Currying (como en Haskell)

add :: Num a => a -> a -> a

add x y = x + y

-- El tipo de `add 10` va a ser:

add 10 :: Num a => a -> a

- En Haskell yo me puedo guardar una función en una variable con un parámetro con un valor "por default", e invocarla en otro lado. Es decir, "invocarla parcialmente".

- Justamente eso es Currying.

Ejemplo del Café usando Future

fun makeCoffeeFuture(): Future<String> {

return CompletableFuture.supplyAsync {

println("Making Coffee")

sleep(2000)

"coffee ${coffeeNumber.incrementAndGet()}"

}

}

// Función principal

fun futureCoffeeBreak() {

val f: Future<String> = makeCoffeeFuture() // Mando a hacer el café

chatWithColleagues() // Me pongo a charlar con mis amigos, o a hacer otra cosa

drink(f.get()) // Me tomo el café una vez listo

}

Future.get()espera a que el valor esté listo para usar, devolviéndolo.- Nótese que

coffeeNumberes unAtomicInteger, justamente para mantenernos en el contexto concurrente.

De manera non-blocking con Futures

import java.util.concurrent.CompletableFuture

fun futureCoffeeBreak() {

val f: CompletableFuture<String> = makeCoffeeFuture()

f.thenAccept { coffee ->

drink(coffee)

}

chatWithColleagues()

}

Manejar errores con Futures

fun futureCoffeeBreak() {

val f: CompletableFuture<String> = makeCoffeeFuture()

f.thenAccept { coffee ->

drink(coffee)

}

.handle { r, exception ->

println("Failed with $exception")

}

chatWithColleagues()

}

Combinando Futures

fun futureCoffeeBreakBlended() {

val f1 = makeCoffeeFuture()

val f2 = makeCoffeeFuture()

val combinedFuture = f1.thenCombine(f2) { result1, result2 ->

"$result1 blended with $result2"

}

combinedFuture.thenAccept { c ->

drink(c)

}

chatWithColleagues()

}

En definitiva, los Futures son Monads

Cabe recordar que un Monad en Haskell es una interfaz para wrappear valores en un contexto, y operar con los valores internos del contexto.

Recordar el tipo Maybe a = Just a | Nothing .

blendedCoffee =

do

coffee1 <- makeCoffeeFuture

coffee2 <- makeCoffeeFuture

return coffee1 ++ " Blended With " ++ coffee2

- Esto es exactamente igual al

Future<T>.thenAccept(Future<T>)

Programación Asíncrona - Continuación

En JavaScript se los llama Promises

let coffeeNumber = 0;

function makeCoffeePromise(): Promise<string> {

return new Promise((resolve) => {

console.log("Making Coffee");

setTimeout(() => { // Equivalente al sleep(2000)

coffeeNumber += 1;

// Al terminar una promesa se llama a este método para devolver un valor

resolve(`coffee ${coffeeNumber}`);

}, 2000);

});

}

function coffeeBreak() {

const f: Promise<string> = makeCoffeePromise();

f.then(coffee => {

drink(coffee);

})

chatWithColleagues();

}

Syntax Sugar para el Async/Await

async function coffeeBreak(): Promise<void> {

const f: Promise<string> = makeCoffeePromise();

chatWithColleagues();

const coffee = await f;

// The code below will be executed when the promised is fullfilled

drink(coffee);

// Promised is propagated!

}

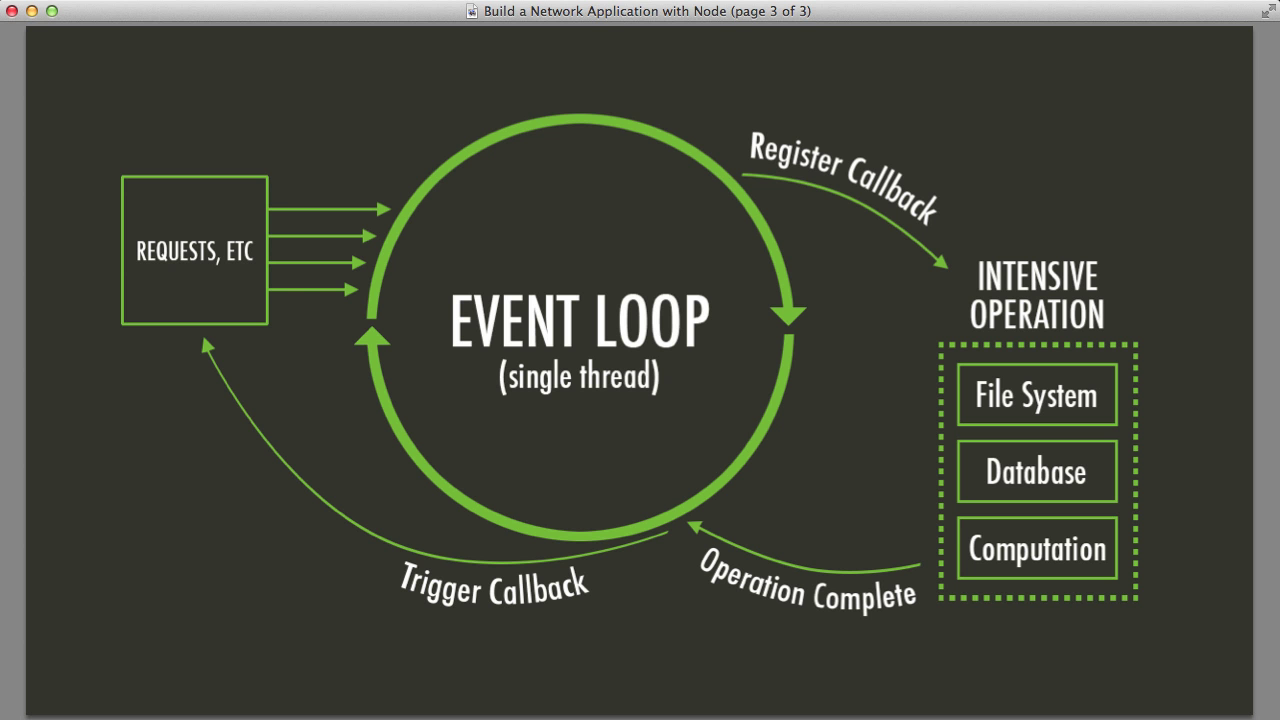

JavaScript es Single-Threaded

- Originado en el browser:

javascriptfue diseñado para manipular el DOM en navegadores web. - El modelo single-threaded previene conflictos e inconsistencias.

- Event Loop:

javascriptopera sobre un modelo basado en eventos. El bucle de eventos verifica tareas como entradas de usuario, solicitudes de red y temporizadores. - Asegura la capacidad de respuesta procesando un evento a la vez.

- Como no puedo levantar threads en el Browser, en JS se tiene que pensar la programación de manera asíncrona

Corutinas

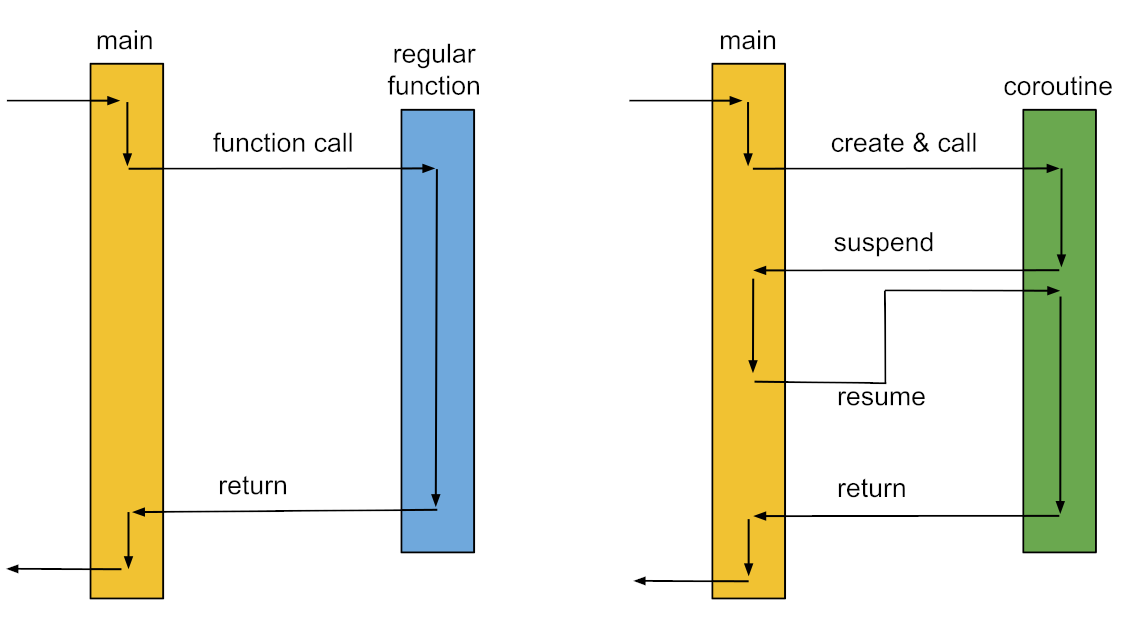

- Subrutinas vs. Corutinas

- Las funciones (o llamados a estas) que conocemos en definitiva son subrutinas

- Subrutinas: 1 entrada, 1 salida

- Corutinas: N puntos de entrada, puede pausarse y reanudarse

- Ceder ejecución

- Las corutinas pueden cederle el control de vuelta a los "callers", que son quienes la invocan

- Reanudan desde el punto donde las pausaron

Ejemplo del café con corutinas

suspend fun makeCoffee(): String {

println("Making Coffee")

delay(2000) // Using delay from kotlinx.coroutines instead of Thread.sleep

return "coffee ${coffeeNumber.incrementAndGet()}"

}

fun coffeeBreakWithCoroutines() = runBlocking {

// Los launch sólo pueden invocarse dentro de una corutina

// `runBlocking` dispara una corutina "bloqueante",

// que bloquea el thread en el que se ejecuta hasta que termine la operación

launch {

val coffee = makeCoffee()

drink(coffee)

}

chatWithColleagues()

}

suspendindica que es una función que se puede suspender, ergo, es unacoroutine- Una corutina puede llamar otra dentro suyo

- Por adentro pueden alocarlas distintos threads

- Si la aloca el mismo thread, el flujo se sigue de la siguiente manera:

- Va al

Launch, empieza la corutina - Empieza a ejecutar

- Hace un yield en el delay de

makeCoffee()e invocachatWithColleagues() - Vuelve a

makeCoffee(), devuelve el valor, y ejecuta eldrink(coffee)de lamain routine

- Va al

runBlockinghace que la función se ejecute en su totalidad- En una corutina se puede ceder el control usando

returnoyield.returnes implícito,yieldes explícito

Las corutinas están pensadas para que, en un mismo hilo, yo pueda tener una ejecución paralela que se realiza con un interleaving.

Es una forma colaborativa de tener concurrencia, similar a los virtual threads.

En runtime (en el caso particular de Kotlin) se permite tener un dispatcher, al que se le pueden alocar a varios threads.

El dispatcher te permite que una corutina no necesariamente se quede esperando.

Beneficios

- Código más simple

- Código asíncrono que parece síncrono

- Más fácil de leer y mantener

- Concurrencia

- Se pueden manejar múltiples tareas de manera concurrente

- Evita la complejidad de threads

- Muy liviano

Concurrencia liviana

fun main() = runBlocking {

for (i in 0..50_000) { // ejecuto la misma corutina 50.000 veces

launch {

println("Hello $i!")

delay(5000L)

}

}

}

Si no estuviera el launch, tardaría aproximadamente 250.000 segundos

Como existe el launch, tarda un poquito más de 5 segundos (por lo que tarda en imprimir, también) por el cambio entre las rutinas, ya que hace el "salto" justo antes del delay.

Se interrumpe y salta a la siguiente corutina justo antes del llamado al delay.

Secuencias (colecciones Lazy)

No tiene que ver de manera directa con concurrencia, pero es la forma más pura de escribir una corutina.

El yield está explícito.

val fibonacciSeq: Sequence<Int> = sequence {

yield(1)

yield(1)

var a = 1;

var b = 1

while (true) {

val result = a + b

yield(result)

a = b; b = result

}

}

fun main() = fibonacciSeq.take(10).forEach { print("$it ") }

sequenceinvoca una lambda y la irá llamando a medida que se lo pida.- Producen elementos a pedido (lazy)

- Esa lambda es una corutina, en definitiva.

- Puedo interrumpir la secuencia usando

seq.take(N).

- Si no se usa con

sequence, se debería armar usando unIterator yieldfunciona parecido areturnpero no finaliza la corutina. Simplemente la interrumpe.- Cuando se vuelve a llamar la corutina, sigue desde el punto siguiente al

yield.

- Cuando se vuelve a llamar la corutina, sigue desde el punto siguiente al

Ejecución paralela vs. secuencial

suspend fun doSomethingUsefulOne(): Int {

delay(1000L); return 13

}

suspend fun doSomethingUsefulTwo(): Int {

delay(1000L); return 29

}

fun main() = runBlocking {

val time = measureTimeMillis {

val one = doSomethingUsefulOne()

val two = doSomethingUsefulTwo()

println("The answer is ${one + two}")

}

println("Completed in $time ms")

}

Como estoy pidiendo un resultado (la suma de ambos resultados de las corutinas), se ejecutará todo secuencial

Paralela

fun main() = runBlocking {

val time = measureTimeMillis {

val one = async { doSomethingUsefulOne() }

val two = async { doSomethingUsefulTwo() }

println("The answer is ${one.await() + two.await()}")

}

println("Completed in $time ms")

}

Clavarle el async fuerza que se te vaya una de las 2 corutinas a otro thread ya que, justamente, crea una corutina.

Es "paralelo" porque los procesos se hacen en paralelo, pero termina siendo una ejecución secuencial del main porque

tenés que esperar los resultados (dados los .await())

Threads vs. Fibers vs. Corutinas

| Concepto | Estado | Ejecutado por | Unidad de suspensión |

|---|---|---|---|

| Hilo (Thread a nivel S.O) | Stack de modo usuario + Stack de modo kernel + contexto | Scheduler del sistema operativo | Hilo completo; la CPU queda libre para ejecutar otros hilos |

| Fiber (User-Mode-Thread, Virtual Thread) | Stack de modo usuario + contexto | Algún hilo | Fiber; el hilo subyacente queda libre para ejecutar otras tareas |

| Corutina | Variables locales + contexto | Algún hilo o fiber | Corutina; el hilo o fiber subyacente queda libre para ejecutar otras corutinas o tareas |

Lo único que la corutina precisa mantener como estado son las variables que está utilizando, que son las propias.

Actors

Lo mejor para actores es Erlang, pero vemos todo en Scala con una librería que se llama Akka por cuestiones de simplicidad

Sincronización tradicional

Varios threads se pisan entre sí. Esto se resuelve:

- Demarcando regiones de código con semánticas para "no molestar"

- Asegurando que el acceso a estado compartido sea protegido

En Scala todos los objetos tienen un lock: synchronized {...}

class BankAccount {

private var balance = 0

def deposit(amount: Int): Unit = synchronized {

if (amount > 0) balance = balance + amount

}

def withdraw(amount: Int): Int = synchronized {

if (0 < amount & amount <= balance) {

balance = balance - amount

balance

} else throw new Error("insufficient funds")

}

}

Qué es un Actor?

Lo que pretende el modelo de actores es pensar las interacciones de un sistema como personas interactuando entre sí. Lo modela como personas que envían mensajes entre sí.

Un actor es:

- Un objeto con identidad

- Que tiene comportamiento

- Y solo interactúa usando pasaje de mensajes asincrónico

Es OOP + Mensajes, en definitiva. Forzado dentro de un sistema donde todo tiene que seguir este estándar.

Actor trait

// Se define un type alias llamado 'Receive'

/* Representa una función que maneja los mensajes que se le envían a un Actor

- Es una PartialFunction, lo que significa que puede no manejar cualquier posible input

- Toma un mensaje de cualquier tipo, y no devuelve nada ('Unit')

*/

type Receive = PartialFunction[Any, Unit]

Receive es esencialmente una función que recibe cualquier parámetro y no devuelve nada.

¿Por qué PartialFunction?

Si las funciones matemáticas están bien definidas, deberían tener dominio para todos los reales. Si no, tienen "agujeros" en el dominio.

Trasladado a Scala y al contexto de Actors, que sea una función parcial quiere decir que hay valores que no soporta. Esto le sirve al lenguaje para hacer algún tipo de chequeo.

// Se define un trait llamado Actor

trait Actor {

// Este método abstracto DEBE ser implementado por el Actor en cuestión

// Define la lógica con la que se reciben los mensajes (qué se hace cuando se recibe un mensaje)

def receive: Receive

}

- Los

traitsen Scala son equivalentes a las interfaces de Java, o a lostraits(justamente) de Rust receivees un lambda.

Un Actor Simple

// La clase 'Counter' extiende el trait 'Actor' e implementa el método 'receive'

class Counter extends Actor {

// Variable mutable (contador actual)

var count = 0

// El método 'receive' define cómo el actor maneja los mensajes que le llegan

def receive = {

// Si el mensaje es el string "incr", incrementa el contador

case "incr" => count += 1

// El resto de mensajes se ignoran, porque la PartialFunction no define un caso para estos.

// Si se quiere definir un caso default, se usa el underscore (_)

}

}

Exponiendo el estado

class Counter extends Actor {

var count = 0

// Añadir el mensaje para get

def receive = {

case "incr" => count += 1

case ("get", customer: ActorRef) => customer ! count

}

}

!es el operador para mandar mensajes enAkkaAkkaes la librería deScalapara actores

customeres unActorRef- get le manda el count a un actor que puede recibir un entero (

int) en su métodoreceive

- get le manda el count a un actor que puede recibir un entero (

Ejemplo para apoyar lo anterior

// Es un actor simplón que recibe el contador y lo imprime

class Printer extends Actor {

def receive = {

// Que el nombre del parámetro sea el mismo en un actor y otro es casualidad

// Es buena práctica pero no es necesario

case count: Int => println("Printer received count: " + $count)

}

}

Uso:

// Inicializar el sistema de actores (posteriormente se ve cómo)

// Supongamos que counter y printer ya está inicializados anteriormente

counter ! "incr"

counter ! "incr"

counter ! "incr"

// Se le pide al contador que envíe su valor actual al printer

counter ! ("get", printer)

¿Cómo se mandan los mensajes?

trait Actor {

// 'self' es una referencia implícita a su propia instancia de actor

// Le permite al actor referirse a su propia dirección sin pasarla de manera explícita

implicit val self: ActorRef

// 'sender' nos da acceso a quien envía el mensaje que actualmente está siendo procesado

// Esto es útil para responder mensajes - se puede hacer `sender ! reply`

def sender: ActorRef

// ...

}

Qué es un ActorRef?

abstract class ActorRef {

// El "bang" o ! es la manera principal de enviarle un mensaje a otro actor

// - 'msg: Any': se puede mandar cualquier tipo de mensaje

// - 'implicit sender': el sender se pasa de manera implícita, de tal manera que el receptor sabe quién lo mandó

def !(msg: Any)(implicit sender: ActorRef = Actor.noSender): Unit

// `tell` es un alias para el !

// Hace que el llamado sea más explícito al pasar tanto el mensaje como el remitente

def tell(msg: Any, sender: ActorRef) = this.!(msg)(sender)

}

- En definitiva, un

ActorRefes una referencia utilizable hacia unActor- Se suelen pensar como la "dirección de mail" del actor en cuestión

- Justamente como el sender está implícito, si no le paso nada me lo mando a mí mismo

implicites syntax sugar de Scala

Usando el Sender

class Counter extends Actor {

var count = 0

def receive = {

case "incr" => count += 1

case "get" => sender ! count

}

}

Un ejemplo para verlo de afuera sería:

class Multiplier extends Actor {

def receive = {

case x: Int => if (x < 10) self ! (x * 2)

case ("ask", customer: ActorRef) => customer ! "get"

}

}

// Suponer multiplier ya inicializado

counter ! "incr"

counter ! "incr"

multiplier ! ("ask", counter) // --> esto va a multiplicar por 2 recursivamente de manera infinita el valor de counter

// El flujo va a ser multiplier ask => counter get => le mando count al multiplier => Multiplier se llama a sí mismo recursivamente hasta que sea mayor a 10

Nota: este ejemplo me lo crafteé yo

Interactuando con el Printer

class Printer extends Actor {

def receive = {

// Acá muestra que cuando le llega un mensaje cualquiera lo imprime

// y después le manda al sender un mensaje con un re texto

case count: Int =>

// Imprimir el count que le llegó

println(s"[${self.path.name}] received count: $count")

// Le mando un ACK a quien me lo envió

// `sender` me da acceso a la referencia de quien sea que me mandó el mensaje en primer lugar

sender ! s"Acknowledged count $count from ${self.path.name}"

}

}

class CounterClient(printer: ActorRef) extends Actor {

def receive = {

// Este actor recibe el ack del Printer

case ack: String => println(s"[${self.path.name}] got reply: $ack")

}

// Este método se ejecuta on init del objeto

override def preStart(): Unit = {

// envía un número al printer usando '!' (asynchronous fire-and-forget)

// 'self' se va a usar implícitamente como sender

// Esta instancia de CounterClient va a ser el sender la primera vez

printer ! 42

// Le mando otro número de manera explícita usando 'tell' y 'self'

printer.tell(99, self)

}

}

- En un programa estándar con estos 2 objetos instanciados:

- se le manda al printer un 42

- luego se le manda un 99

- en ambos casos con el CounterClient como Sender

Actor Context

En el modelo de los actores, el contexto es el ambiente donde el actor está corriendo. Dentro de lo que puede hacer, le puedo pedir al contexto:

- Crear otros actores

- Cambiar su comportamiento de manera dinámica

- Acceder a referencias de sí mismo y de los remitentes

- "Frenarse" a sí mismo o a otros actores

El actor describe el comportamiento, la ejecución la realiza su ActorContext

En código

trait ActorContext {

// Me permite actualizarle el receive al actor actual

def become(behavior: Receive, discardOld: Boolean = true): Unit

// Vuelve para atrás al último comportamiento guardado en caso de que

// discardOld era `false` en el llamado del become

def unbecome(): Unit

}